Dilemma: Wenn selbstfahrende Autos töten

Dieser Artikel ist älter als ein Jahr!

Ethik spielt bei der Zukunft von selbstfahrenden Autos eine größere Rolle, als manch einer glaubt. Davon hängt sogar ab, ob selbstfahrende Autos sich etablieren können, weil sie von den Menschen akzeptiert werden, schreibt das „MIT Technology Review“. Wie wichtig diese Frage tatsächlich ist, zeigten vor kurzem YouTube-Videos von Tesla-Fahrern, die "Probleme" mit ihren selbstfahrenden Autos hatten. Auch wenn selbstfahrende Autos prinzipiell viel sicherer sein sollen als von Menschen gesteuerte wird man über so manche unangenehmen Fragen trotzdem nachdenken müssen.

Szenarien

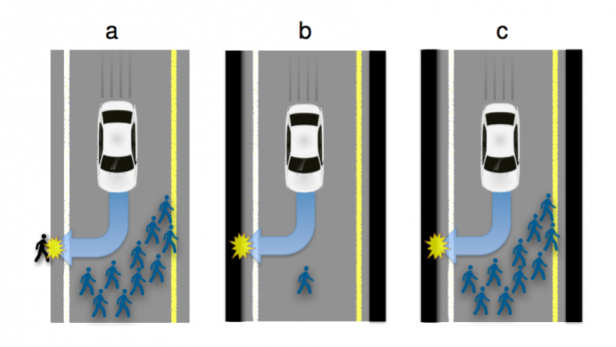

Etwa: Wie verhält sich ein autonom fahrendes Auto, wenn es die Wahl hat, ob jetzt der Insasse, also sein Fahrer, sterben soll, oder doch lieber zehn Menschen, die sich plötzlich aus unvorhersehbaren Gründen auf der Fahrbahn befinden, oder doch der Fußgänger, den das Auto erwischt, wenn es ausweicht? Mit diesen Fragen haben sich Forscher der Toulouse School of Economics in Frankreich beschäftigt und sie kommen zu dem Schluss: Die öffentliche Meinung wird bei der Klärung dieser Fragen eine entscheidende Rolle spielen.

Die Forscher haben in weiterer Folge versucht, die öffentliche Meinung einzuholen, in dem sie mehreren hundert Zeitarbeitern von Amazons Mechanical Turk verschiedene Szenarien vorgelegt haben. Diese ersten Ergebnisse sollen nun tatsächlich in die ethischen Algorithmen von autonomen Fahrzeugen miteinfließen.

Ergebnisse

Dabei waren die Ergebnisse durchaus vorhersehbar: Natürlich soll die Zahl der Todesopfer möglichst gering gehalten werden. Ergo: Das würde aber auch bedeuten, dass das selbstfahrende Auto in so einer brenzligen Situation eher den eigenen Fahrer umbringen würde als eine Menschengruppe.

Allerdings kam bei der Studie auch heraus, dass die Befragten selbst nicht glauben, dass die selbstfahrenden Autos tatsächlich so programmiert werden, dass sie ihren eigenen Fahrer umbringen. Und: Sie gehen von dem Wunsch aus, dass nicht sie selbst in einem autonom gesteuerten Auto sitzen, sondern nur andere Menschen.

Moralisches Dilemma

Hier beginnt freilich ein Dilemma: Die Menschen wollen zwar die Zahl der Todesopfer niedrig halten, aber selbst wollen sie nicht getötet werden, weil sie in einem autonomen Auto sitzen. Außerdem: Ändert es was, wenn am Straßenrand ein Kind steht? Oder im Auto eines sitzt? Und: Soll das wirklich die "öffentliche Meinung" entscheiden, oder sollen derartige Dinge doch lieber dem Zufall überlassen bleiben?

Die französischen Forscher weisen darauf hin, dass ihre Studie nur der Beginn gewesen sei, um dieses schwierige ethische Problem zu ergründen. Man müsse die ethische Komponente von Algorithmen allerdings sehr ernst nehmen, warnen die Forscher. „Wie wir wissen, sollen Millionen von Fahrzeugen rausgebracht werden, deshalb war es noch nie so wichtig, sich mit algorithmischer Moral zu beschäftigen.“

Kommentare