Google Lens: “Die Kamera ist der neue Browser”

Dieser Artikel ist älter als ein Jahr!

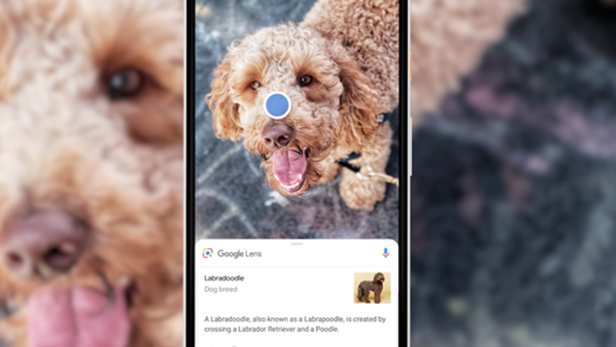

Vergangenes Jahr hat Google im Rahmen der I/O Lens vorgestellt. Die Funktion ist in Google Photos und im Assistant verfügbar. Die Software soll bei Suchanfragen helfen, die sich nur schwer in Worte fassen lassen, etwa: “Welche Pflanze ist das?” Stattdessen kann man einfach ein Foto davon machen und Lens sagt, was es ist.

Auf der diesjährigen I/O hat Google bekannt gegeben, dass Lens direkt in die Kamera-App von unterstützen Geräten integriert wird. Dazu zählen Smartphones von LG, Motorola, Xiaomi, Sony, Nokia und andere. Aparna Chennapragada leitet bei Google den Bereich visuelle Suche. “Die Kamera soll zum neuen Browser werden”, erklärte sie im Rahmen eines Roundtables bei der Google I/O.

Google hat angekündigt, die Funktionen von Lens auszubauen. Zuletzt konzentrierte man sich darauf, Text besser und sinnvoller erfassen zu können. Nutzer können etwa Geschriebenes abfotografieren und dann per Copy und Paste auf dem Handy weiterverwenden. Sinnvoll kann das etwa bei WLAN-Passwörtern sein. Lens soll gleichzeitig aber auch hilfreiche Informationen zu abfotografierten Text einblenden. Als Beispiel nennt Google hier eine Speisekarte in einem Restaurant. Wenn man ein bestimmtes Gericht nicht erkennt, liefert Lens automatisch ein Foto dazu, wenn man die Speisekarte abfotografiert.

Kontext erkennen

Die besondere Schwierigkeit hinter derartiger Technik sei es, den Kontext von Wörtern zu erkennen, erklärt Chennapragada. “Wenn die Bilderkennung eine E-Mail-Adresse mit der Endung ‘gmail.com’ registriert, kann es gut sein, dass die Texterkennung stattdessen ‘gmaii.com’ registriert”, so die Google-Managerin. Der Google-Algorithmus steuert hier allerdings gegen, da er weiß, dass “gmail.com" weit wahrscheinlicher ist als “gmaii.com".

“Das ist sehr ähnlich, wie unsere Web-Suche funktioniert”, so Chennapragada. Auch hier werden Tippfehler, die die Nutzer bei den Sucheingaben machen, automatisch korrigiert. Vergleichbar sei die Lens-Technik auch mit der Google-Spracherkennung. Auch dort gilt es, aus mehreren ähnlich klingenden Wörtern automatisch das richtige zu registrieren.

Passende Kleidung suchen

Google kündigte noch eine weitere neue Funktion für Lens an, die sich um Mode dreht. Nutzer können nun Kleidungsstücke fotografieren und fragen, welche ähnlichen Stücke es eventuell noch gibt. Google liefert dann automatisch Links zu Shops bzw. zu entsprechenden Stücken.

Laut Google soll Lens in Echtzeit funktionieren. Möglich sei dies nur durch die letzten Entwicklungen im Feld des Machine Learning.

Freigeschaltet werden sollen die neuen Funktion für die Pixel-Handys sowie für die der oben genannten Hersteller im Laufe der kommenden Tage. Nutzer anderer Smartphones müssen sich wohl noch deutlich länger gedulden.

Kommentare