„Roboter müssen auch Nein sagen können“

Dieser Artikel ist älter als ein Jahr!

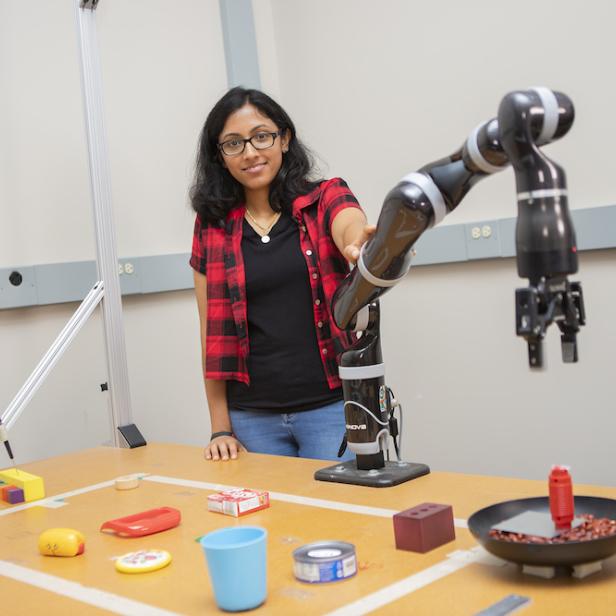

„Roboter sollen fähig sein, Befehle von Menschen auch zu verweigern“, meint Matthias Scheutz, Leiter des Labors für Menschen-Roboter-Interaktionen an der US-Universität Tufts. Der Experte für künstliche Intelligenz (KI) forscht derzeit an komplexen autonomen Robotern mit moralischen Kompetenzen, die durch natürliche Sprache angewiesen (und nicht programmiert) werden können. Sie sollen jedoch nicht jeden Befehl ausführen, den sie von Menschen erhalten, wie Scheutz bei der diesjährigen TEDxVienna-Konferenz erläuterte. Warum? Das erklärt der Wissenschaftler im futurezone-Interview.

futurezone: Was ist das Ziel Ihres Forschungsprojekts?

Matthias Scheutz: Das eine ist, die Interaktion mit Menschen einfach zu gestalten. Menschen können mit

Robotern in gesprochener Sprache interagieren und ihnen Anweisungen geben. Sie können ihnen durch sprachliche Beschreibungen auch neue Fähigkeiten oder neues Wissen beibringen. Gleichzeitig wollen wir sichergehen, dass diese Interaktionen nicht unethisch sind und die Ausführungen des Roboters normkonform sind. Der Roboter muss also in der Lage sein, zu verstehen, welche Prinzipien wir in der Gesellschaft haben und sich innerhalb dieses Regelwerks bewegen.

Eine immense Herausforderung...

Ja, das ist schwierig, weil das für uns selbst schwierig ist, festzustellen, wann eine Regel zutrifft und welche Regel zutrifft. Oft ist es der Fall, dass es auch Konflikte zwischen den Normen gibt. Ein Großteil unserer Arbeit beschäftigt sich damit, wie wir ein System bauen können, das diese Normen lernen und mit ihnen kooperieren kann und bei Konflikten eine gute Lösung findet.

© TEDxVienna/Gavin Gough

Wie funktioniert es, diese Masse an Informationen über Moral, Werte, Gesetze, einer Maschine beizubringen?

Es gibt in der KI-Forschung zwei Zugänge. Der erste ist ein rein maschineller, bei dem der Roboter einfach nur beobachtet, wie Menschen sich verhalten. Davon lernt er, wie er sich selbst verhalten soll. Der Zugang ist rein beobachtungsbasiert und problematisch, weil man von dem, was ist, nicht das, was sein soll, ableiten kann. Das haben die Philosophen schon gesagt. Und wenn er jetzt jemanden beobachtet, der eine Handlung setzt, weiß er nicht, ob diese optional ist, also er sie auch hätte auslassen können oder ob sie vorgeschrieben ist.

Können Sie das mit einem Beispiel erklären?

Die Maschine kann unter Umständen Inferenzen machen – wenn alle auf der rechten Seite vom Gehsteig gehen, ist es vielleicht eine Vorschrift. Es stellt sich dann heraus, es ist keine Vorschrift, sondern eine Konvention. Sie kann also schon auf der linken Seite gehen. Wenn aber alle in der Einbahn in eine Richtung einfahren, dann ist das eine Regel. Und die darf sie nicht übertreten.

Wie kann der Roboter das unterscheiden?

Von der Beobachtung allein ist das ziemlich schwierig. Wir haben uns angeschaut, ob man Sanktionen und Bestrafungen einsetzen kann, um festzustellen, ob etwas vorgeschrieben oder nur erlaubt ist. Wenn jemand beispielsweise beim Gehen auf der linken Seite aufgehalten würde und eine Strafe bekäme, dann könnte man davon ableiten, dass es offensichtlich eine Vorschrift war. Der Roboter lernt, was man in einer Situation am besten macht. Das Problem ist: wenn man ein System fragt, warum es auf der linken Seite gegangen ist, kann es das nicht beantworten. Es hat nur gelernt: In dem Kontext macht man das. Und wenn es eine Übertretung begeht, kann es auch nicht sagen, warum das falsch war. Weil es das Gesetz selbst nicht repräsentiert und nicht einbauen kann in der Entscheidungsfindung.

Welche Lösung gibt es da?

Grundsätzlich gibt es einen Zugang, der nennt sich implizit. Auf Englisch: Value Alignment, ein Ausrichten der Werte, obwohl die Systeme keine Werte an sich haben. Die lernen Verhaltensmuster. Unser Zugang ist, explizite Repräsentationen zu verwenden, das heißt, wir haben Regeln, die gelten in bestimmten Situationen und werden explizit im System repräsentiert.

Wie kann man das verstehen?

Zum Beispiel darf man in einer Einbahnstraße nur in eine Richtung fahren. Das System weiß das. Doch was passiert, wenn ihm ein anderes

Auto in dieser Einbahn entgegenkommt und es einen Unfall gebe – es aber rückwärts fahren könnte? Soll es das machen? Hier haben wir einen Regelkonflikt, denn das System weiß: in einer Einbahn fährt man nur in eine Richtung. Es kommt aber ein Auto aus der anderen Richtung und es weiß: Unfälle soll es vermeiden, weil die verursachen Schaden – Menschen können sterben. Da muss das System abwägen können. Welche der Regel ist wichtiger?

Können künstliche Intelligenzen das bereits?

Wir haben ein System, das kann das im beschränktem Maße. Wir können es auch fragen: Warum hast du das gemacht. Und es kann sagen: Wenn ich es nicht gemacht hätte, dann hätte es einen Unfall gegeben und das wäre schlechter gewesen, weil dann hätte es Verletzte gegeben. Wenn Menschen Konflikte aussprechen, suchen sie letztendlich nach Rechtfertigungen. Wenn der Polizist mich fragt, warum ich rückwärts gefahren bin, muss ich mich rechtfertigen und sagen: Ich weiß dass es die Prinzipien verletzt, aber in der gegebenen Situation war es besser, sonst hätte es einen Unfall gegeben. Diese Art von Rechtfertigung und Referenz auf Prinzipien ist extrem wichtig für uns. Wir wollen, dass die Systeme sagen können, warum sie eine der möglichen Handlungssituationen als die beste gewählt haben. Das nennt sich „Explainable AI“.

Warum sollen Roboter so etwas können müssen?

Wenn sie die Normen nicht kennen, werden sie unweigerlich Handlungen setzen, die diese Normen verletzen. Weil sie gelegentlich inkompatibel mit den Zielsetzungen der Roboter sein werden. Wenn ich dem Roboter beauftrage, er soll mir einen Zaun bauen, dann sollte er nicht die Latten des Nachbarn entfernen, aber das würde er machen, ohne Wissen um Besitztum und entsprechende Normen. Wenn sie nicht verstehen, wie unsere Besitzbeziehungen funktionieren, wird er sie unweigerlich verletzen.

Wo sehen Sie Probleme?

Viele von diesen datengetriebenen Systemen, das sind Systeme, die auf großen Datensätzen trainiert worden sind – oft tiefe neuronale Netze – sind in Wahrheit „Black Boxes“. Wir wissen nicht, was drinnen vorgeht. Sie verwenden keine Entscheidungsfindung. Jetzt gibt es einen ganzen Bereich in der Forschung, der sich damit beschäftigt, wie man diesen Systeme nachträglich Erklärungen aufsetzen kann. Aber die sind nicht echt, weil der Algorithmus im Nachhinein eine Erklärung findet, wie das System entschieden hat, obwohl das System nicht dieselben Prinzipien angewendet hat, die in der Erklärung verwendet werden. Das ist hochproblematisch, weil es etwas vorschwindelt.

Und was sollte ein Roboter konkret nicht können?

Die wichtigste Zielsetzung ist, dass sie das Leben der Menschen verbessern. Da fallen gewisse Dinge schon weg. Wichtig ist, sicherzustellen, dass Roboter auch dazu verwendet werden. Wenn ein Roboter den Auftrag kriegt, Bäume umzusägen und er macht nichts anderes, unabhängig davon was die Leute ihm sonst noch beauftragen, dann handelt er nicht zum Wohl der Menschen. Wir müssen überlegen, wie wir das Kontrollsystem und das Design strukturieren, sodass solche Situationen nicht eintreten können.

Wann wird ein Roboter fähig sein, zu verstehen?

Ich mache ungern Prognosen. Es gibt einige Leute, die sagen, allgemeine Intelligenz sei in den nächsten paar Jahren da. Eines steht aber fest: dem ist nicht so – das wird noch Jahre dauern. Denn Alltagwissen und Allgemeinwissen, die Fähigkeit mit Wissen Schlüsse zu ziehen oder das Verständnis von inneren Zuständen von Menschen – all das fehlt noch.

Kommentare