User entscheidet, ob Autopilot Kind oder Katze überfahren soll

Dieser Artikel ist älter als ein Jahr!

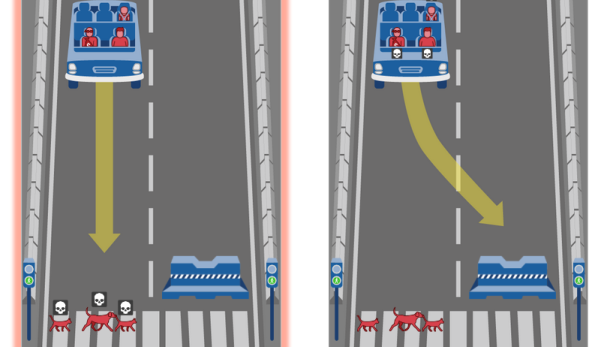

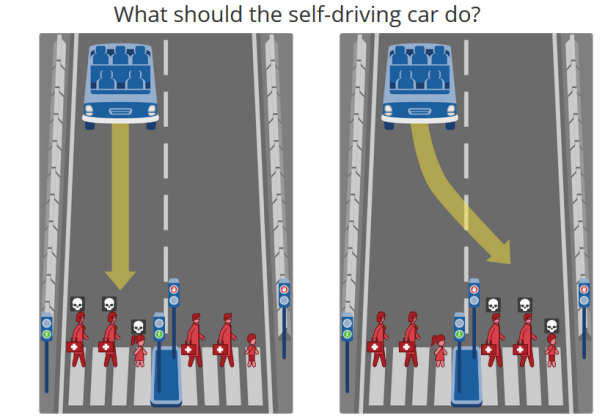

Soll ein selbstfahrendes Auto lieber die Insassen beschützen und einen Fußgänger überfahren oder einer Katze ausweichen und gegen eine Mauer fahren? Die “Moral Machine”, eine Webseite des Massachusetts Institute of Technology (MIT), richtet diese und ähnliche Fragen an die Allgemeinheit. Die Plattform soll Informationen darüber sammeln, wie Menschen derartige Entscheidungen treffen und wie sie Maschinen wahrnehmen, die mit ähnlichen Entscheidungen konfrontiert sind.

Je größer die Autonomie der Maschinen, desto mehr Entscheidungen müssen sie selbst treffen. Doch wie sollen Geräte ethische Urteile fällen, bei denen es um Menschenleben geht? Wissenschaftliche Studien beschäftigen sich derzeit intensiv mit der Thematik. Das MIT hat die Moral Machine ins Leben gerufen, um diesen Diskurs zu unterstützen. Mittels Umfrage werden Meinungen darüber abgefragt, wie Maschinen entscheiden sollen, wenn sie sich in einem moralischen Dilemma befinden.

© Moral Machine/Screenshot

Der Mensch als Orientierungshilfe

In der Befragung stehen sich immer zwei Szenarien gegenüber, es gilt, sich für eines zu entscheiden. Grafiken zeigen jeweils, wie sich das Auto verhält und was die Konsequenzen daraus sind. Am Ende sieht man eine Auswertung des Tests und einen Vergleich der Ergebnisse mit dem Durchschnittswert der anderen Teilnehmer. Wer besonders motiviert ist, kann auch eigene Szenarien entwickeln und diese an Freunde verschicken.

“Wenn man davon ausgeht, dass künstliche Intelligenz menschliche Fähigkeiten ersetzen soll, muss man dem Auto Ethik beibringen”, sagt Amitai Etzioni, ein Soziologe an der George Washington University, gegenüber der New York Times. “Ich plädiere für eine Partnerschaft zwischen Mensch und Maschine. Der Mensch sollte immer derjenige sein, der eine moralische Orientierungshilfe bietet.”

Kommentare