Was maschinelles Lernen und künstliche Intelligenz unterscheidet

Dieser Artikel ist älter als ein Jahr!

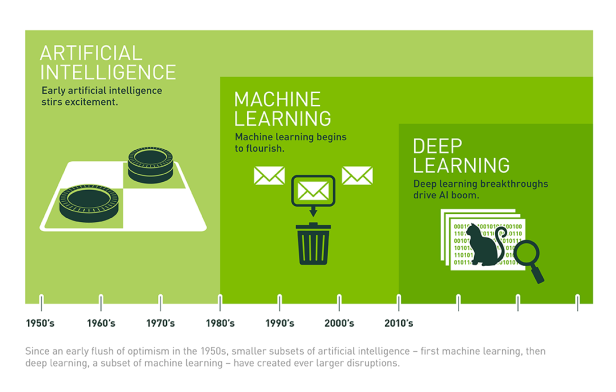

Künstliche Intelligenz (KI) ist mittlerweile fast überall zu finden. In unseren Hosentaschen, in selbstfahrenden Autos und schachspielenden Computern. Getrieben wird die Verbreitung von KI-Systemen durch Fortschritte im Bereich des maschinellen Lernens. Dieser Umstand hat dazu geführt, dass die beiden Begriffe häufig synonym verwendet werden. Das ist streng genommen aber falsch. Das maschinelle Lernen ist lediglich ein Teilgebiet des großen Gebiets der künstlichen Intelligenz.

Künstliche Intelligenz hat John McCarthy in den 1950er-Jahren als "sich mit Maschinen, die Aufgaben übernehmen können, die charakteristisch für menschliche Intelligenz sind" definiert. KI-Systeme sollen eigenständig Probleme lösen. In der einfachsten Form lässt sich das über feste Regeln erreichen, einen festgelegten Algorithmus. So lässt sich etwa mit sechs einfachen Befehlen eine KI programmieren, die im Spiel "Tic Tac Toe" unbesiegbar ist. Neben KIs, die solche strikt definierte Aufgaben lösen, fallen auch Systeme, die eine dem Menschen vergleichbare allgemeine Intelligenz demonstrieren, unter den Begriff. Diese "starken KIs" sind aus heutiger Sicht aber reine Science Fiction.

© Nvidia

Schwach aber nützlich

Aber auch "schwache KIs", die eben nur eine einzelne festgelegte Aufgabe oder eine begrenzte Klasse ähnlicher Probleme lösen können, sind heute meist wesentlich komplexer aufgebaut, als der oben beschriebene Tic-Tac-Toe-Automat. Hier kommt das maschinelle Lernen (ML) ins Spiel, das von Arthur Samuel als "die Fähigkeit zu lernen, ohne explizit programmiert worden zu sein" definiert wurde. Die Systeme, die Go-Profis vernaschen, Videospiele erlernen, Katzen erkennen oder Texte übersetzen, sind allesamt Beispiele für maschinelles Lernen.

Bei derartigen Systemen kommen keine Programmierbefehle oder vorgefertigte Algorithmen zum Einsatz. Stattdessen entwickeln die Systeme selbst den passenden Algorithmus, der das Lösen eines bestimmten Problems erlaubt. Das funktioniert ähnlich wie bei einem Galtonbrett. Die Daten, auf deren Basis das ML-System lernt, sind die Kugeln, die eingeworfen werden. Im Urzustand ergeben die Kugeln, die durchfallen unten eine Normalverteilung in die möglichen Antwortfächer.

© Wikimedia, CC BY SA, Rodrigo Argenton

Pfade

Ein ML-System kann die verschiedenen Pfade aber modifizieren, um ein gewünschtes Ergebnis zu bekommen. Das System wird trainiert, indem immer wieder Kugeln durchgeschickt werden, so lange, bis die Pfade so modifiziert sind, dass das richtige Ergebnis herauskommt. Wie die Gewichte dabei verändert werden, erschließt sich auch den Architekten der Systeme nicht, weshalb bei ML-Systemen oft von Black-Boxes gesprochen wird.

Im einfachsten Fall sind sowohl die Eingaben als auch die gewünschten Ergebnisse bekannt. Das System passt den Pfad dann solange an, bis der Input zum Output passt. Das passiert etwa bei Systemen, die Katzen erkennen können. Ihnen wird eine große Zahl von Bildern gefüttert, die entweder als Katze oder nicht als Katze beschriftet sind. Das System optimiert seinen Algorithmus dann so lange, bis gefütterte Bilder mit hoher Präzision klassifiziert werden können. Nach einer ausreichenden Trainingsphase kann das System dann für jedes Bild sagen, ob eine Katze darauf zu sehen ist oder nicht. Eine Unschärfe bleibt allerdings übrig, da es sich bei den Ergebnissen immer nur um Wahrscheinlichkeiten handeln kann. Diese Methode nennt man auch überwachtes Lernen.

Stock und Rübe

Zu dieser Kategorie gehört auch das bestärkende Lernen oder Reinforcement Learning, bei dem ein Algorithmus durch Plus- und Minuspunkten in die gewünschte Richtung gelenkt wird. Änderungen die das System in Richtung des gewünschten Ergebnisses liefern, werden sozusagen mit der Karotte belohnt, andere mit dem Stock gestraft. Damit können etwa simulierte menschliche 3D-Figuren im Computer das Gehen lernen, ohne dass sie wissen, wie ein echter Mensch sich fortbewegt.

Ein weiterer Begriff, der oft verwendet wird, ist das sogenannte Deep Learning. Dabei handelt es sich um eine Implementierung von maschinellem Lernen mit neuronalen Netzwerken. Diese sind Strukturen im menschlichen Gehirn nachempfunden und eignen sich besonders gut, um maschinelles Lernen umzusetzen. Sie bestehen aus Tausenden oder gar Millionen von untereinander dicht verknüpften künstlichen Neuronen. Jeder dieser Verbindungen ist ein Gewicht zugewiesen, das festlegt, wie wahrscheinlich die Weitergabe von Information auf diesem Kanal ist. Die Gewichte kann das System in der Trainingsphase dann je nach Zweck anpassen. Diese dicht verknüpfte Struktur, die in mehrere Schichten gegliedert ist - daher der Name Deep Learning - kann man sich wie eine weitaus kompliziertere Version eines Galtonbretts vorstellen.

Die KI-Systeme, die für Schlagzeilen sorgen, sind in den meisten Fällen das Ergebnis von neuronalen Netzwerken, die verschiedene Formen des überwachten Lernens einsetzen. Das gilt für Googles-Go-Automat genauso wie für die Katzenerkennungsmaschine und diverse Übersetzungs- oder Spracherkennungssoftware. Unüberwachtes Lernen gibt es ebenfalls. Solche Systeme haben keinen gewünschten Output zur Verfügung und finden lediglich Muster in unstrukturierten Daten. Hier steht die Forschung vergleichsweise aber noch am Anfang.

Kommentare