Wenn Computer uns „verstehen“

Dieser Artikel ist älter als ein Jahr!

Sebastian ist querschnittsgelähmt. Essen, schreiben oder gar anziehen ist für ihn körperlich nicht mehr möglich, geistig aber schon. Während seine Gliedmaßen nicht mehr kommunizieren können, spricht also sein Gehirn. Was es braucht, ist ein Computer, der seine Gedankenvorgänge lesen und in die Tat umsetzen kann.

Sebastian ist einer von weltweit 2,7 Millionen Menschen, die laut dem Branchenportal MiniMed querschnittsgelähmt sind – oft aus Folgen eines Unfalls. In Österreich sind es etwa 4000 Menschen. Meist ist die Arm- und Greiffunktion geschädigt. Was ihr Leben um ein Vielfaches vereinfachen kann, sind sogenannte Brain-Computer-Interfaces (BCI).

Versuchen reicht

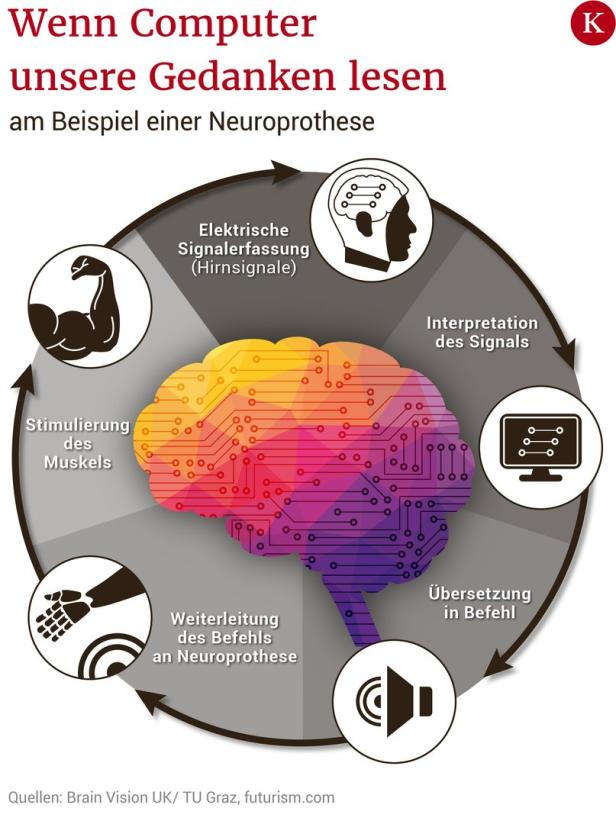

Eine Koryphäe auf diesem Gebiet ist Gernot R. Müller-Putz, Leiter des Instituts für Neurotechnologie und Medizintechnik an der TU Graz. Seit rund 20 Jahren forscht er an solchen Mensch-Maschinen-Schnittstellen. Die neuesten Erkenntnisse hat er unlängst im Rahmen der Konferenz NeuroIS Retreat in Wien vorgestellt. Und die sind bemerkenswert. Bereits bei der bloßen Vorstellung einer Bewegung werden bestimmte Hirnregionen aktiv. Mittels einer Elektroenzephalografie (EEG) wird die vorhandene Gehirnaktivität gemessen und mithilfe von Computern analysiert. Die erkannten Muster werden in Steuersignale umgewandelt und an eine Neuroprothese weitergeleitet.Diese wiederum stimuliert über elektrische Impulse die jeweiligen Gelenkmuskeln: die Hand greift.

Nun haben Tests gezeigt, dass allein der Versuch einer Handbewegung bei Querschnittsgelähmten erkannt wird. Das Gehirnmuster wird aktiviert, gemessen und mithilfe von maschinellem Lernen erkannt. „Wenn der Proband versucht, die Hand zu öffnen, diese sich aber nicht bewegt, erkennt das die Technologie kurz darauf und öffnet sie“, erklärt Müller-Putz der futurezone.

BCI-Übertragung

© Grafik: K.A. Solomon/Quelle: Brain Vision UK/ TU Graz/futurism.com

Von der Hand zum Arm

Nächstes Forschungsziel sei, den gesamten Arm zu steuern: „Das ist derzeit noch sehr schwierig“, erklärt der Experte. Klinische Tests sollen nun im Rahmen des EU-Projekts „MoreGrasp“ zeigen, ob Armbewegungen auch dekodiert werden können. „Schließlich versuchen wir, Fehlerpotenziale im Signal zu erkennen, um Bewegungskorrekturen zu machen“, sagt Müller-Putz weiter.

Kurzum: Wenn der Arm sich bewegt und einen Fehler macht, erkennt das der Proband und der Ausgangsfehler wird behoben. „Bewegungen im Fluss zu erkennen, ist derzeit aber noch sehr schwierig“, schildert der Spezialist.

Neue Anwendungen

„Die derzeitigen Herausforderungen sind, BCI-Techniken in neue Anwendungsfelder zu bringen“, ergänzt Gunther Krausz vom österreichischen Entwickler für Neurotechnologie g.tec. Geglückt ist dieses Bestreben beispielsweise mit „Recoverix“, ein Rehabilitationssystem für Schlaganfallpatienten. Diese BCI-Technologie wird ebenfalls benutzt, um Bewegungsvorstellungen zu trainieren.

Wenn sie vom Patienten richtig ausgeführt werden, werden die Gehirnströme gemessen und klassifiziert. Der Prozess ist ähnlich: Das System erkennt die Hirnaktivität, bewegt eine Avatar-Hand am Bildschirm und stimuliert zeitgleich elektrisch die jeweiligen Muskeln in der menschlichen Hand. „Das ist das direkteste und intensivste Biofeedback derzeit“, schildert Krausz.

"Reden" im Wachkoma

Die Forschung will aber auch jene Menschen erreichen, die gar nicht mehr kommunizieren können. So sollen sich künftig sogar Wachkoma-Patienten per BCI ausdrücken. Eine simple Kommunikation auf „Ja“– „Nein“-Basis ist laut Müller-Putz bereits eine große Errungenschaft. In einigen Fällen wurde dieses Ziel bereits erreicht. Krausz spricht von „MindBEAGLE“. Zunächst werden dem Patienten Töne über Kopfhörer vorgespielt.

Manchmal ist ein Ton anders, das Gehirn antwortet bei solch einem selten auftretenden Reiz mit einem bestimmten elektrischen Wert – die sogenannte p300-Komponente. Das System zeigt damit, ob eine Reaktion da ist.„Entsteht dieser p300-Wert, ist der Patient bei Bewusstsein“, so Krausz. In Folge wird er trainiert, sich auf bestimmte Reize zu konzentrieren, damit ein höherer p300-Wert entsteht – der Patient lernt, dass tiefe Töne zum Beispiel „Ja“ und hohe „Nein“ bedeuten. „Diese Anwendung ist noch schwierig, weil jeder Patient anders ist. Es gibt aber schon welche, die so kommunizieren können“, erklärt Krausz.

Ungestört arbeiten

Laut Müller-Putz kann man jedoch nicht von „gedankenlesenden Maschinen“ sprechen, wie sie gerne interpretiert werden: „Das Wort ,Gedanke’ ist zu allgemein – es sind vielmehr Gedankenvorgänge, die gemessen werden können.“ Ziel sei jedenfalls, BCI für die Allgemeinheit verfügbar und praktikabel zu machen. „Das ist mit ein Punkt, der das Feld bremst, weil BCI verlangen, sich die Elektroden und das Gel in die Haare zu geben beziehungsweise sich die Haare waschen zu müssen“, sagt er. Alleine in Bezug auf alltagstaugliches Design ist es noch ein weiter Schritt. Bis die Schnittstellen in der allgemeinen Komplexität funktionieren, dauert es also noch.

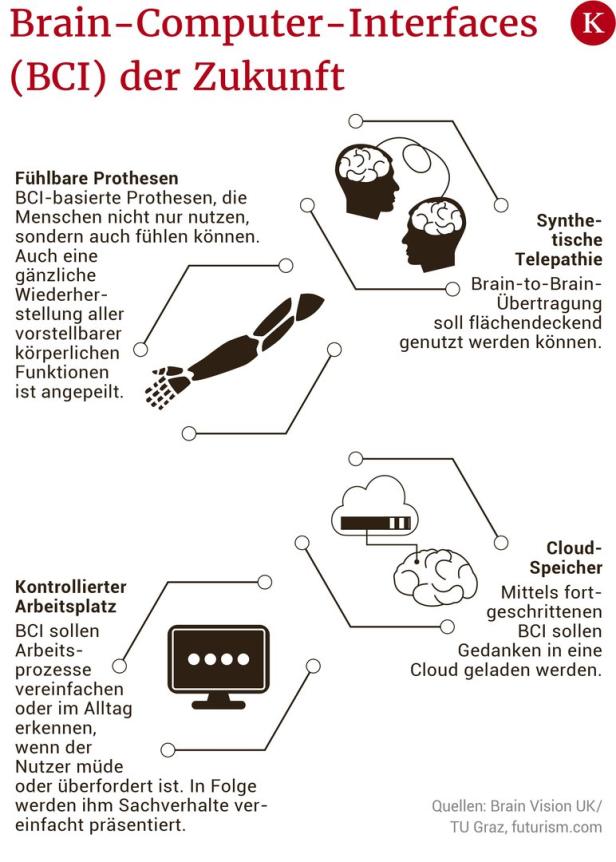

Außerhalb der Medizin könnten BCI unter anderem den Arbeitsplatz mitsteuern. Beispiel: Wenn jemand Ruhe zum Schreiben braucht, wird das Telefon automatisch stummgeschaltet. Auch anderweitig ergeben sich laut Müller-Putz Anwendungsmöglichkeiten. „Junge Leute verwenden im Unterricht heute ihre Computer. Beim Lernen, schauen sie vielfach darauf. Wenn die Informationen dann zu komplex werden, kann der Computer erkennen, dass die Person abschweift. Dann werden die Bildschirminhalte automatisch vereinfacht.“ Für viele sicher ein netter Gedanke.

© Grafik: K.A. Solomon/Quelle: Brain Vision UK/ TU Graz/futurism.com

Kommentare