ÖNB: Forschung zur Bewältigung der Datenflut

Dieser Artikel ist älter als ein Jahr!

"Wir müssen uns nicht mehr nur darum kümmern, Bücher aufzubewahren und Benutzern zugänglich zu machen, sondern auch Datenbestände zu sammeln, langfristig zu archivieren und für Nutzer der Zukunft bereitzustellen", sagt Max Kaiser, Leiter der Forschungs- und Entwicklungsabteilung der Österreichischen Nationalbibliothek (ÖNB). Die Sammlung und Aufbewahrung der digitalen Daten stelle die Bibliothekare vor große Herausforderungen. Ein Buch könne man sachgerecht lagern und nach Jahrhunderten noch für Nutzer ausheben. Das könne man mit digitalen Daten nicht, so Kaiser. "Man muss sich ständig mit den digitalen Daten beschäftigen, um sicherzustellen, dass man keinen Datenfriedhof produziert. Denn in 50 Jahren haben wir die Technologien nicht mehr, die wir heute haben, um diese Daten zugänglich zu machen."

Entwicklung von prototypischen Lösungen

Mit den Herausforderungen der digitalen Langzeitarchivierung und der Verarbeitung großer Datenmengen beschäftigt sich in der Nationalbibliothek die Abteilung Forschung und Entwicklung. Dort werden prototypische Lösungen erarbeitet, die - wenn sie sich bewähren - in den Regelbetrieb übergehen. Dabei arbeiten die Forscher der ÖNB mit europäischen Partnern zusammen.

Etwa im großangelegten EU-Projekt SCAPE, das vom Austrian Institute for Technology (AIT) geleitet wird und das sich mit der Entwicklung von Services zur digitalen Archivierung beschäftigt. Neben Bibliotheken und Universitäten aus mehreren europäischen Ländern sind dabei auch Technologiefirmen mit an Bord. Die ÖNB ist auch an der Alliance Permanent Access (APARSEN) beteiligt und Mitglied der Non-Profit-Organisation Open Planets Foundation, die zur digitalen Langzeitarchivierung forscht.

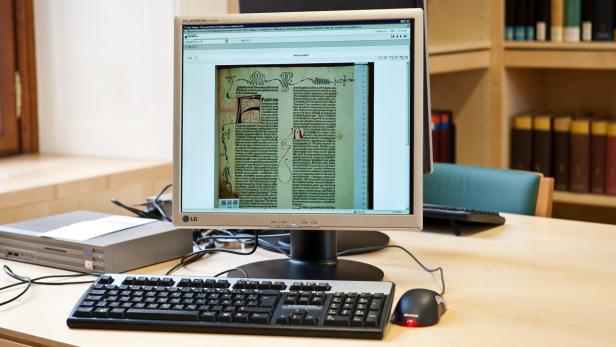

© Gilbert Novy

Datenmengen

Neben den Daten aus Digitalisierungsprojekten, darunter auch die Zusammenarbeit mit Google im Rahmen der "Austrian Books online", haben die Bibliothekare die Datenmengen aus der Webarchivierung zu bewältigen. Seit 2009 wurden bereits 1,2 Millionen Websites aus der .at-Domain oder Sites mit Österreichbezug gesammelt, die sich aus rund 1,1 Milliarden einzelner Dateien zusammensetzen. Allein im vergangenen Jahr sind die Bestände um 300.000 Websites gewachsen.

Datenanalyse im Server-Cluster

Im Rahmen des SCAPE-Projekts hat die ÖNB einen Server-Cluster auf Basis der Hadoop-Technologie aufgebaut. Solche Systeme kommen auch bei großen Playern im Bereich Big Data bei der Analyse großer Datenmengen zum Einsatz. In der Nationalbibliothek werden damit unter anderem die unzähligen Datenformate im Webarchiv analysiert. "Das ist Voraussetzungen dafür, um Strategien für die digitale Archivierung zu entwickeln", sagt Kaiser. "Mit dem Cluster können wir es sehr effizient erledigen, mit normalen Techniken würde das sehr lange dauern."

"Wenn wir wissen, wir haben Dateiformate, die in Zukunft nicht mehr unterstützt werden könnten, müssen wir handeln", sagt Sven Schlarb aus der Forschungs- und Entwicklungsabteilung der ÖNB: "Wir müssen dann Workflows entwickeln, mit denen diese Dateien in ein neues Format übersetzt werden können."

Qualitätssicherung

In dem Projekt wird auch an Tools zur Qualitätsanalyse in Großdigitalisierungsprojekten gearbeitet, die auch bei der Zusammenarbeit mit Google beim Projekt Austrian Books Online zum Einsatz kommen. "Wenn das Projekt zu Ende ist, werden wir 200 Millionen Seiten digitalisiert haben", sagt Kaiser. "Wir müssen Routinen entwicklen, wie die Qualität möglichst automatisiert überprüft und etwa doppelt digitalisierte Seite automatisch erkannt werden können."

Automatische Textanalyse

In dem Server-Cluster wird auch die Textindexierung der digitalisierten Werke durchgeführt. "Es werden nicht nur Bilder erzeugt, die Texte werden mithilfe von Texterkennungstechnologien (Anm.: OCR, Optische Zeichenerkennung) erkannt", sagt Kaiser. "Dadurch ist es erstmals möglich, die Bücher nach bestimmten Wörtern zu durchsuchen und die Texte automatisch zu analysieren. Das ist ein Quantensprung."

Davon soll künftig auch die Wissenschaft profitieren. In einer weiteren Ausbaustufe wolle man es Nutzern ermöglichen, "wirklich interessante Fragen" an die Texte zu stellen, kündigt Kaiser an. Über statistische Analysen würden sich Entwicklungen der Sprache über die Jahrhunderte hinweg erforschen lassen. Auch Beziehungen von Schriftstellern untereinander ließen sich damit aufzeigen.

"An den Anfängen"

Daneben sollen semantische Technologien dabei helfen, etwa Personennamen und Ortsnamen aus den Texten in einem Wissensgraphen miteinander in Beziehung zu setzen und auch mit externen Quellen zu verbinden. Beziehungen zwischen Daten sollen dann auch visualisiert werden können, so die Forscher der Nationalbibliothek. "Um diese Möglichkeiten anbieten zu können, ist die Infrastruktur zur Verarbeitung großer Datenmengen ein wesentlicher Punkt", sagt Schlarb. "Da sind wir an den Anfängen."

- „Wir denken in Ewigkeitskategorien“

Kommentare