Das Spiel ist aus: Maschine schlägt Go-Europameister

Dieser Artikel ist älter als ein Jahr!

Google-Forschern um Demis Hassabis ist es erstmals gelungen, ein Computersystem zu erschaffen, das einen Spitzenspieler im 2500 Jahre alten asiatischen Brettspiel Go schlagen kann. Googles “AlphaGo” hat den amtierenden Europameister Fan Hui vor Zeugen in fünf Spielen in Folge geschlagen. Das Duell fand im Oktober des vergangenen Jahres statt, die Forscher haben ihre Arbeit jetzt in der Fachzeitschrift “Nature” veröffentlicht. Der Sieg stellt einen unerwarteten Durchbruch im Bereich der künstlichen Intelligenz dar. Im Schach haben auch die besten Spieler schon länger keine Chance mehr gegen Computer. Bei Go waren sich führende Experten bislang einig, dass es noch etwa 10 Jahre dauern werde, bis eine Maschine erstmals einen Go-Meister schlagen könne. "Das ist wirklich schnell gegangen. Ein Durchbruch hat sich zuletzt allerdings schon abgezeichnet, auch wenn sich das im Nachhinein natürlich immer einfach sagt", erklärt Ernst Buchberger, Mitglied des Austrian Research Institute for Artificial Intelligence (OFAI) und Hobby-Go-Spieler.

Komplexes Spiel

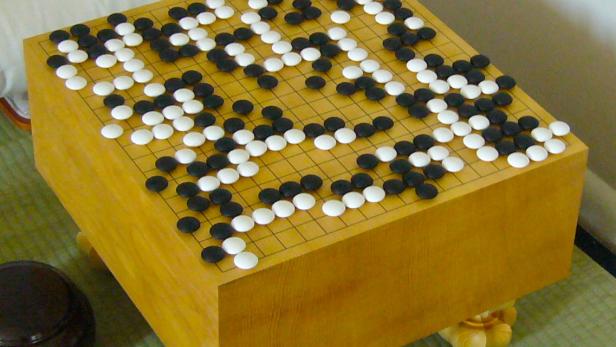

Die große Schwierigkeit für Go-spielende Software ist, dass die Anzahl der möglichen Züge in Go viel größer ist als bei Schach. Bei Go versuchen zwei Spieler, einer mit weißen und der andere mit schwarzen Steinen, möglichst große Gebiete des Spielgitters mit 19 x 19 Schnittpunkten für sich zu erobern. Das geht etwa, indem die vom Gegner gelegten Steine eingekreist und so "geschlagen" werden. Während es im Schach in einer Spielsituation durchschnittlich 35 mögliche Züge gibt, sind es bei Go 250. Für jede dieser Optionen gibt es für den nächsten Zug wieder 250 Möglichkeiten. Bei Schach kann durch Vorausberechnen aller möglichen Züge über mehrere Runden jeder Großmeister geschlagen werden.

Bei Go geht das nicht. Die Zahl der möglichen Konstellationen auf einem Brett (2.081681994 * 10^170) ist um ein Vielfaches größer als die geschätzte Zahl der Atome im beobachtbaren Universum(rund 10 hoch 80). Mit bloßer Rechenleistung stoßen Go-Systeme hier schnell an ihre Grenzen. "Die vielen Möglichkeiten bei Go führen zu einer kombinatorischen Explosion", sagt Buchberger. Google hat einen anderen Weg gefunden, um die besten Go-Spieler besiegen zu können. Die verwendete Software folgt nicht einfach strikt vorgegebenen Regeln, sondern erlernt das Spiel tatsächlich, fast so wie ein menschlicher Spieler. Als Basis wurde das System mit 30 Millionen Zügen von Profispielern gefüttert.

Computer lernt

Anhand dieser Grundlage lernt die Software, Go zu spielen. Das allein reicht aber noch nicht aus, um menschliche Profis zu schlagen, weil das System mit dieser Methode maximal gleich gut wie die Experten werden kann. Deshalb haben die Google-Forscher ihr System Millionen mal gegen leicht abgeänderte Versionen seiner selbst spielen lassen, um die Fähigkeiten weiter zu verbessern. So entwickelt das System selbstständig neue Spielzüge, um auch den besten Spielern gefährlich werden zu können. “Der wichtigste Aspekt an alldem ist, dass AlphaGo nicht nur ein spezialisiertes System ist, das vorgegebenen Regeln folgt. Stattdessen haben wir ein System gebaut, das lernt, wie man bei Go gewinnt”, sagt Demis Hassabis bei der Präsentation der Ergebnisse.

Im März soll AlphaGo in Südkorea in einem öffentlichen Duell gegen Lee Sedol antreten, der aktuell weltweit die zweitmeisten Titel in Go hält. Hassabis bezeichnet Sedol als “den Roger Federer des Go”. Ein Sieg gegen den Großmeister wäre wohl der endgültige Beweis für die Überlegenheit der Maschinen auf dem Go-Gitter. Einzelne Siege gegen Go-Profis haben auch andere Systeme schon geschafft, allerdings nur, wenn das Feld verkleinert wurde oder die Software einige Steine Vorsprung bekommen hat. Der Sieg von AlphaGo gegen den Europameister hingegen passierte unter Wettkampfbedingungen.

1200 CPUs

AlphaGo verwendet so genannte neuronale Netzwerke, um Go zu lernen. Diese Technik versucht, die Funktionsweise des menschlichen Gehirns nachzuahmen. "Bisher wurden sogenannte Monte-Carlo-Simulationen für Go-Software verwendet. Google hat die jetzt mit neuronalen Netzwerken kombiniert", sagt Buchberger. Für das Spiel gegen Fan Hui wurde die Software auf einem System mit 170 Grafikprozessoren und 1200 handelsüblichen CPUs ausgeführt. Diese Hardware wurde für das Training der Algorithmen und das eigentliche Duell eingesetzt. Für das Spiel gegen Sedol soll AlphaGo noch weiter verbessert werden. Die Herausforderung ist laut Experten noch deutlich größer als beim Antreten gegen den Europameister.

Kommentare