Deepfakes: "Dem Gesicht kann man nicht mehr vertrauen"

Dieser Artikel ist älter als ein Jahr!

Die Möglichkeiten neuer Technologien erkennt man am ehesten daran, wie sie von Kriminellen und Künstlern genutzt werden. Dieses Diktum des Science-Fiction-Autors William Gibson trifft auf das Generieren von Bildern mithilfe künstlicher Intelligenz punktgenau zu.

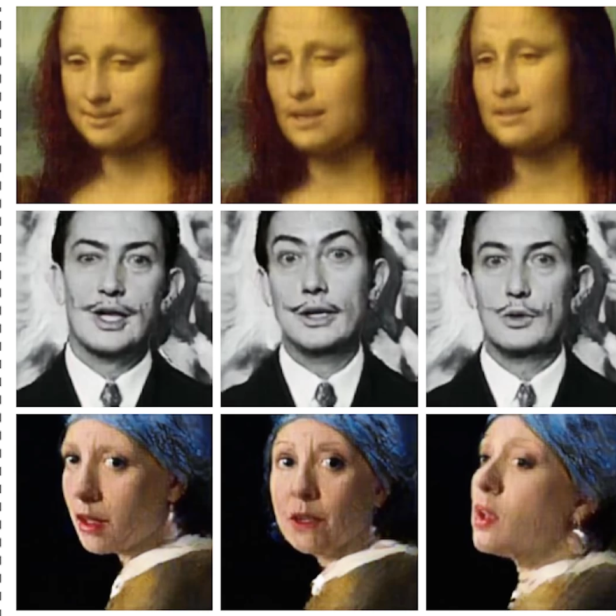

Solche künstlich generierten Bilder und Videos werden etwa in Hollywood eingesetzt, um verstorbene Schauspieler in aktuelle Filme zu montieren. Als sogenannte Deepfakes kommen sie aber auch für gefälschte Pornovideos mit Prominenten oder für Desinformationskampagnen und Betrug im Internet zum Einsatz.

Das niederländische Start-up Deeptrace arbeitet an Lösungen, wie solche Videos automatisiert erkannt werden können. "Eine Antivirus-Software für Videos", wie Giorgio Patrini, Gründer und wissenschaftlicher Leiter des Unternehmens, zur futurezone sagt.

Die futurezone hat Patrini im Jänner bei der Innovationskonferenz DLD in München getroffen und mit ihm über die Gefahren von Deepfakes und Strategien gegen gefälschte Bilder und Videos gesprochen.

Giorgio Patrini

© Dominik Gigler for DLD / Hubert

futurezone: Sie forschen zu Deepfakes und arbeiten an

Software, die sie erkennen kann. Wie groß ist das Problem?

Giorgio Patrini: 2017 waren gerade einmal eine Handvoll solcher Videos im Umlauf. Zuletzt haben wir über 17.000 gezählt. Die Anzahl der Videos ist in den vergangenen Jahren sehr stark gewachsen.

Welche Bereiche sind davon betroffen?

Die meisten Deepfake-Videos sind Pornos. In den vergangenen 18 Monaten haben wir in dem Bereich viele neue Aktivitäten gesehen. Manche ziehen das auch schon als Geschäft auf. Sie produzieren Videos, in denen Gesichter von Stars oder Leuten des öffentlichen Lebens ohne deren Wissen in pornografische Szenen hineinmontiert werden. Das hat sehr stark zu dem Wachstum beigetragen.

Diese Videos werden auf Pornoseiten veröffentlicht?

Es gibt bereits eigene kostenpflichtige Seiten dafür, einige werden auch auf Mainstream-Pornoseiten hochgeladen.

Wo kommen Deepfakes noch zum Einsatz?

Wir haben Fälle gesehen, wo sie zum Betrug in sozialen Medien, für Social Engineering und für Desinformationskampagnen eingesetzt wurden. Aber das steht erst am Anfang.

Wie kann man sich das vorstellen?

Es werden Fake-Accounts in Online-Netzwerken erstellt, bei denen die Profilbilder von künstlicher Intelligenz generiert wurden. Auf diese Weise posten dann Leute, die es gar nicht gibt und die nicht zurück verfolgt werden können, auf

Facebook oder anderen Netzwerken Kommentare. Oder es finden sich auf Linkedin Profile von Leuten, die vorgeben, für die Regierung zu arbeiten und versuchen anderen Leuten Informationen zu entlocken.

Wo stehen wir bei Deepfakes technologisch?

Derzeit ist die Frage, wie viele Bilder und Videos eingesetzt werden, um die künstliche Intelligenz zu trainieren und auf welche Rechenleistung man zurückgreifen kann. In kurzer Zeit lassen sich damit bereits sehr überzeugende Videos generieren. Wenn man sie in geringer Auflösung am Smartphone sieht, kann man davon schon getäuscht werden. Es gibt bereits sehr gute Software zur Manipulation von Lippenbewegungen, die auch von Leuten mit wenig technischer Expertise genutzt werden kann.

Auch bezüglich der Manipulation von Videos von Politikern gibt es Ängste und auch schon einige Beispiele. Wirklich überzeugende Fälle haben wir aber noch nicht gesehen. Warum?

Es ist schwer zu sagen, wann die Technologie auch für solche Videos genutzt werden wird. Man legt einem Politiker Worte in den Mund und verbreitet dann die Videos. Das wird früher oder später sicherlich passieren. Was wir aber schon davor sehen werden, ist ein genereller Schwund des Vertrauens.

Man wird das, was man sieht, nicht mehr glauben?

Ja, denn je mehr Leute über die Technologie und ihre Fähigkeiten Bescheid wissen, desto mehr werden wohl auch authentische Videos in Zweifel gezogen. Wenn etwa Politiker bei sexistischen oder rassistischen Äußerungen oder bei Lügen gefilmt wurden, können sie sagen, es ist ein Fake. Jeder wird das behaupten können, denn ein solches Video könnte potenziell auch gefälscht sein.

In Österreich gab es im vergangenen Jahr ein Video von Politikern, das die Regierung zu Fall gebracht hat. Das Ibiza-Video ...

Das ist mir nicht entgangen ...

Wie lange wird man noch mit Sicherheit sagen können, dass solche Videos authentisch sind?

Bei Deepfake-Videos, die heute im Umlauf sind, kennen wir die Methoden. Da können wir mit ziemlicher Sicherheit Manipulationen nachweisen. Wir verwenden dazu genauso künstliche Intelligenz und suchen nach Unstimmigkeiten auf der Pixelebene und auf der inhaltlichen Ebene. Aber das letzte Wort ist dabei noch nicht gesprochen.

Wie wird sich die Technologie weiterentwickeln?

Künftig werden Deepfakes mit ziemlicher Sicherheit auch in Echtzeit eingesetzt werden. Finanzielle Anreize gibt es genug. Es wird möglich sein, Bilder im Moment ihres Entstehens zu manipulieren. Sie können dann etwa in Videoanrufen vorgeben, dass sie ein Familienmitglied, ein Mitarbeiter oder der Bankberater sind. Das ist eine sehr machtvolle Methode, um zu bekommen was sie wollen, denn solchen Leuten wird in der Regel vertraut.

Wie sollen wir als Gesellschaft darauf reagieren?

Es geht auch um Bildung und Aufklärung. Die Technologie ist da und sie kann für fragwürdige Zwecke eingesetzt werden. Wir werden uns von der Vorstellung verabschieden müssen, dass Personen, die wir sehen oder am Telefon hören, diejenigen sind, von denen wir annehmen, dass sie sie sind. Gesichter oder Stimmen kann man in Zukunft nicht mehr vertrauen. Sie werden nicht genug sein, um Leute zweifelsfrei zu erkennen.

Welche Schutzmaßnahmen wird es geben?

Bisher hat man sich in der Cybersicherheit mit Software, Netzwerken oder Hardware beschäftigt, Audio und Video waren kein Thema. Auch weil es keine realistische Möglichkeit gab, sie zu kompromittieren. In Zukunft wird das anders sein. Cybersicherheitsfirmen werden Schutzmaßnahmen für solche Medien entwickeln, die durchaus mit Anti-Viren-Software verglichen werden können. Wenn Sie auf Facebook ein Video sehen und es kommt nicht von einer vertrauenswürdigen Quelle, dann werden Sie es mit einer solcher Software überprüfen.

Kommentare