Wie man DeepFake-Videos erkennt

Dieser Artikel ist älter als ein Jahr!

"Um ein Video zu verfälschen, werden bei DeepFakes im Grunde zwei verschiedene Bilder miteinander verschmolzen", erklärt Martin Steinebach, IT-Forensiker beim renommierten deutschen Fraunhofer-Institut im Gespräch mit der futurezone. "Da die beiden Bilddateien eine unterschiedliche Datenstruktur haben, ist es in der Forensik meist recht einfach, die Verfälschung nachzuweisen." Wenn sich etwa die Datenrate ändere, das Bild aber gleichbleibt, sei dies ein Hinweis darauf, dass hier im Nachhinein etwas verändert wurde, sagt IT-Gutachter Horst Eidenberger von der Technischen Universität Wien zur futurezone.

Man könne aber Videoclips tatsächlich so gut fälschen, dass die Manipulation nicht erkannt werden können, erklärt Eidenberger. "Wenn jemand sehr viel Arbeit in einen solchen Clip investiert, perfektes Ausgangsmaterial sowie einen Computer mit der nötigen Rechenleistung hat, dann ist es nahezu unmöglich, ein manipuliertes Video als solches zu erkennen", erklärt der deutsche IT-Forensiker.

Er vergleicht eine solche Machart aber mit Spezialeffekten bei Hollywood-Filmen, wo beispielsweise bereits verstorbene Schauspieler wieder in aktuellen Filmen auftauchen. Mit klassischen DeepFake-Videos, die mit einem Smartphone oder einem handelsüblichen Computer erstellt wurden und die meist in den sozialen Netzwerken landen, hat eine solch aufwendige Manipulation jedoch nicht viel gemein.

Wie kann man als einfacher Internet-Nutzer gefälschte Videos erkennen?

Grundsätzlich sollte man eine gute Portion Skepsis mitbringen, wenn man sich durch das Internet und soziale Netzwerke bewegt. Findet man ein Video, in dem etwa ein Politiker mit aufsehenerregenden Aussagen aufhorchen lässt, ist es ratsam, nach dem Video beziehungsweise den entsprechenden Aussagen auch anderswo zu suchen. Berichten renommierte Medien bereits darüber, kann man davon ausgehen, dass das Video nicht gefälscht wurde. Gibt es keine entsprechenden Berichte beziehungsweise lediglich auf fragwürdigen Blogs, gibt es wahrscheinlich einen guten Grund, die Echtheit des Videos anzuzweifeln.

Personen Blinzeln kaum

Die in DeepFake-Videos dargestellten Personen blinzeln kaum, da dies offenbar schwer zu fälschen ist. Das haben Forscher festgestellt und raten dazu, beim Erkennen von manipulierten Videos auf die Augenbewegungen der Personen zu achten. Hält etwa ein Politiker eine eigenartige Rede, blinzelt dabei aber nie bis kaum, könnte dies ein Hinweis darauf sein, dass das Video gefälscht wurde.

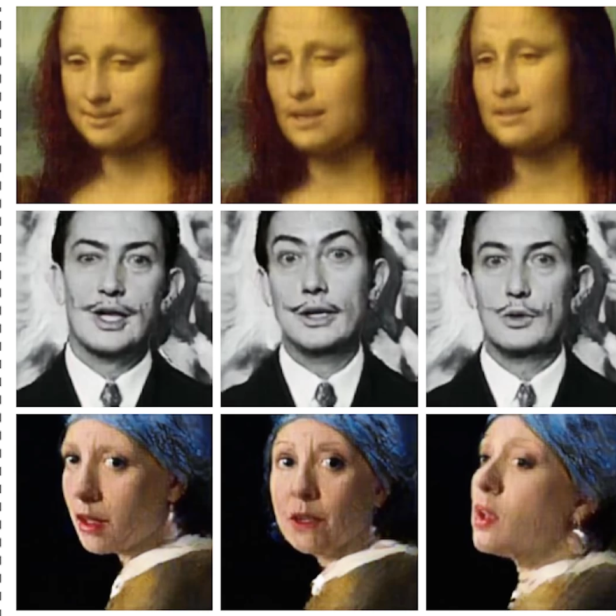

Unschärfe im Gesicht

Wenn das Gesicht der Person unscharf dargestellt wird, während alle anderen Teile des Bildes scharf sind, ist Misstrauen angebracht. Mit Unschärfe wird nämlich einerseits versucht der Schnittpunkt der hinzugefügten Bilder unkenntlich zu machen. Andererseits kann diese Unschärfe dadurch entstehen, dass die hinzugefügten Bilder, eine schwächere Auflösung haben, als das Originalmaterial.

Hautfarbe

Eine Herausforderung beim Erstellen von DeepFakes ist es, den exakten Farbton der Hautfarbe zu treffen. Sollte es farbliche Abweichungen im Gesicht der dargestellten Person geben, könnte dies darauf hindeuten, dass es sich um manipuliertes Videomaterial handelt.

Doppelte Augenbrauen

Sollte das Gesicht Eigenartigkeiten aufweisen, etwa vier Augenbrauen oder unscharfe Konturen, könnte dies ebenso ein Hinweis darauf sein, dass ein Videoclip im Nachhinein bearbeitet wurde.

Sonstige Ungereimtheiten

Beim Erkennen von DeepFakes ist besonderes Augenmerk darauf zu legen, wenn etwa das Gesicht einer Person für einen Moment durch eine Hand oder einen Gegenstand verdeckt wird. Hier tun sich DeepFake-Algorithmen schwer, die Situation täuschend echt aussehen zu lassen. Wenn das Bild in so einem Moment eigenartig ruckelt oder hin und her springt, ist dies ein deutlicher Hinweis auf eine Manipulation.

Kommentare