Wenn Computer Vorurteile haben

Dieser Artikel ist älter als ein Jahr!

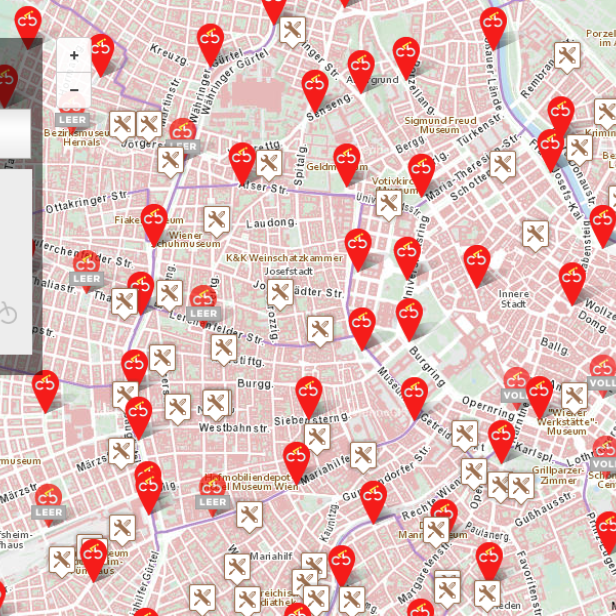

In Österreich setzt das Arbeitsmarktservice (AMS) ab Mitte 2020 Algorithmen ein, um die Arbeitsmarktchancen von Arbeitslosen zu berechnen. Doch können wir dem System bedenkenlos vertrauen? Carla Hustedt leitet das Projekt „Ethik der Algorithmen“ der Bertelsmann Stiftung in Deutschland. Sie forscht seit Jahren an den Auswirkungen von Computersystemen auf die Gesellschaft.

futurezone: Künstliche Intelligenz (KI) weckt viele Ängste: Etwa, dass lernende Algorithmen Menschen den Job kosten, oder dass sie zum Schaden der Bevölkerung eingesetzt werden. Was ist Ihr Forschungsfokus im Projekt Ethik der Algorithmen?

Carla Hustedt: Wir untersuchen den Einfluss algorithmischer Systeme auf die Gesellschaft, beispielsweise in Bereichen wie Bildung, Gesundheit,

Recruiting und dem öffentlichen Sektor. Unser Ziel ist es, dass damit die Chancen für das Gemeinwohl vorangetrieben und Risiken minimiert werden. Wir sensibilisieren die Gesellschaft für den Wandel, agieren als Brückenbauer und wollen auch Lösungsansätze bereitstellen.

Was sind Ihrer Meinung nach die größten Risiken?

Die größte Gefahr ist, dass ein falsches Verständnis der Fähigkeiten der Technologie besteht und Menschen denken, Algorithmen seien neutral. Algorithmische Systeme können uns zu einer chancengerechteren Gesellschaft verhelfen. Doch Algorithmen werden von Menschen gemacht und basieren auf Daten, die unsere Realität widerspiegeln. Sie können menschliche Vorurteile reproduzieren und so soziale Ungleichheit verstärken.

Der Diskurs zu dem Thema schwankt sehr stark zwischen Utopie und Dystopie. Damit wird Technologie zu etwas Magischem und wir vergessen, dass wir sie aktiv gestalten müssen. Dabei kommt es immer auf die Grautöne an.

Menschen glauben also einem

Computer mehr als Menschen?

Es gibt verhaltenswissenschaftliche Studien, die zeigen, dass Menschen Computern eher vertrauen als menschlichen Prognosen. Blindes Vertrauen ist problematisch, wenn Menschen mit Maschinen zusammenarbeiten und Entscheidungen auf der Basis von Computerberechnungen treffen sollen. Deshalb braucht es einen Kompetenzaufbau bei Personen, die algorithmische Systeme einsetzen. Ihnen muss klar kommuniziert werden, wie ein System arbeitet und was für Fehlerquoten es hat, damit sie es richtig einschätzen können.

In welchen Bereichen ist es besonders problematisch, wenn Maschinen sich irren?

Grundsätzlich in allen Bereichen, in denen über Teilhabe von Menschen entschieden wird. Außerdem kommt es darauf an, wie hoch die Reichweite eines Systems ist und ob Menschen sich der Bewertung durch den Algorithmus entziehen können. Bei Gesundheitsapps, die einem helfen sollen, Eigenprognosen zu treffen, bleibt es jedem selbst überlassen, ob er dieses Angebot nutzt. Wenn aber der Staat einen Algorithmus nutzt, um über die Vergabe von Sozialleistungen zu entscheiden, haben Menschen keine Wahl. Solche Einsatzbereiche bedürfen gesonderter Aufmerksamkeit.

Haben Sie ein Beispiel?

Beim Recruiting ist es so, dass Menschen mit ausländisch klingendem Nachnamen 50 Prozent höhere Chancen haben, bei Bewerbungen bei gleicher Qualifikation abgelehnt zu werden. In der Theorie können Systeme dabei helfen, diese Art von Diskriminierung sichtbar zu machen und abzubauen. Aber wenn sich Computer die Vorurteile von Menschen aneignen und dann in der Breite eingesetzt werden, kann das zu einem systematischen Ausschluss vieler Menschen aus dem Arbeitsmarkt führen. In Frankreich führte ein System zur Zuteilung von Studierenden auf Unis zu einem Ausschluss von sozial benachteiligten Bewerbern. Ein Problem, welches erst nach sechs Jahren bekannt wurde.

Wie kann man solche Probleme verhindern?

Es ist unter anderem essenziell, dass Berechnungen von Computerprogrammen nachvollziehbar gemacht werden. Betroffene Menschen müssen darüber Bescheid wissen, dass ein maschinelles System hinter einer Entscheidung steht und wie eine Entscheidung zustande gekommen ist. Wir fordern daher ein Vermummungsverbot für algorithmische Systeme. Man muss Betroffenen auch die Möglichkeit geben, sich gegen automatisierte Entscheidungen zu wehren.

Oft ist nicht klar, wer für eine Entscheidung verantwortlich gemacht werden kann.

Einfluss und Verantwortung wird oft verwechselt. Programmierer haben großen Einfluss auf die Gestaltung der Software-Systeme, aber sie sollten nicht unbedingt die Verantwortlichen sein. Die Entscheidung, welche Ziele ein System erfüllen soll, liegen nicht in den Händen einzelner Programmierer. Die liegt in der Führungsetage, die strategische Entscheidungen trifft. Doch gerade dort ist oft kein Verständnis dafür da, wie die Systeme funktionieren. Das kann dazu führen, dass Verantwortung abgeschoben wird auf deren Komplexität des Algorithmus. Verantwortlichkeiten müssen früh im Prozess festgelegt und transparent gemacht werden.

Ein Forscherteam der

ETH Zürich hat sich etwa 84 Dokumente mit ethischen Leitlinien von Unternehmen angesehen, die für KI festgelegt worden sind. Bringen solche etwas?

Natürlich ist das erst einmal positiv, weil dadurch ein Grundbewusstsein entsteht, aber es kommt, wie überall, auf die Details an. Wenn den Leitlinien die Substanz fehlt und sie vor allem aus Buzzwords bestehen, ist das ein Hindernis für ihre Umsetzung. Wir haben selbst die sogenannten „Algo.Rules“ entwickelt, die für alle Personen gelten, die am Entwicklungsprozess beteiligt sind. Programmierer und Designer ebenso wie Führungskräfte und die Personen, die die Systeme einsetzen. Hier haben wir auf Kriterien geachtet, die überprüfbar sind.

Brauchen wir neue Gesetze?

Es kommt darauf an. Neue Grundrechte brauchen wir nicht, sondern hier müssen wir die Durchsetzung der Bestehenden gewährleisten. Hierfür sind klare Regeln nötig, die weiter gehen als eine freiwillige Selbstverpflichtung von Unternehmen. Die Datenschutzgrundverordnung ist ein erster wichtiger Schritt, aber nicht ausreichend, weil digitale Assistenzsysteme beispielsweise nicht darunterfallen. Hier gibt es Nachbesserungsbedarf.

Diskriminierung ist im Zusammenhang mit

Computersystemen immer wieder ein großes Thema. Hilft es gegen Diskriminierung, wenn mehr Frauen an der Programmierung von Algorithmen beteiligt werden?

Wir brauchen auf jeden Fall mehr Diversität in der Tech-Branche. In großen Tech-Firmen ist der Anteil an weiblichen IT-Fachkräften unter 20 Prozent und 70 Prozent der Mitarbeiter sind weiß. Es gibt bereits viele unterschiedliche Beispiele, die verdeutlichen, was passiert, wenn weiße Männer als Default-Einstellung genutzt wird. Nehmen wir die Crash-Test-Dummys her: Über Jahrzehnte hatten Frauen höhere Chancen, bei Autounfällen zu sterben, weil nur Crash-Test-Dummys eingesetzt wurden, die mit Blick auf Größe und Gewicht Männern entsprachen. Das hat lange gedauert, bis es aufgefallen ist. Diversität alleine kann aber nicht die Lösung sein, sondern ist nur ein Teil davon.

Was für Lösungen gibt es noch?

Die Chancen und Probleme sind divers, so auch die Lösungen. Wir brauchen einen Kompetenzausbau auf allen Ebenen, die Stärkung von Kontrollinstitutionen, die Überarbeitung rechtlicher Rahmenbedingungen bis hin zu einer breiten gesellschaftlichen Debatte über den Einsatz von algorithmischen Systemen. Gerade der öffentliche Sektor ist ein sensibler Bereich, weil Menschen amtlichen Entscheidungen nicht entgehen können. Dort sind die Transparenzforderungen besonders hoch und ein Outsourcing der Systementwicklung an privatwirtschaftliche Organisationen kann der Umsetzung der Transparenzpflichten im Weg stehen. Es braucht hier auf jeden Fall unabhängige Prüforganisationen und Beschaffungsstandards, die Kontrolle ermöglichen.

Kommentare