Künstliche Intelligenz: „Die Angst ist oft unbegründet“

Dieser Artikel ist älter als ein Jahr!

„Soll man vor einer mathematischen Formel Angst haben? Wenn man die Matura macht, wahrscheinlich schon“, sagt der Informatiker Sepp Hochreiter, der vergangene Woche bei den Alpbacher Technologiegesprächen zu Gast war. Die gesellschaftliche Angst vor künstlicher Intelligenz (KI) sei aber oft unbegründet, erzählt er im Gespräch mit der futurezone.

Warum fürchten wir uns vor künstlicher

Intelligenz?

Sepp Hochreiter: Wir haben Angst vor Neuem und vor Sachen, die wir nicht verstehen und kontrollieren können. Was ich eigenartig finde, ist, dass die Menschen auf den falschen Platz schauen und nicht dorthin, wo es wirklich gefährlich ist. Für mich ist künstliche Intelligenz wie eine mathematische Formel. Wird sie komplexer, kann sie beispielsweise Gegenstände in Bildern erkennen. In einem solchen Fall sehe ich nicht, warum man Angst haben müsste.

Wann ist Angst begründet?

Wenn man sich eine Blase baut, indem man anhand von künstlicher Intelligenz nur noch Nachrichten konsumiert, die in unsere Denkrichtung gehen. Man hat Vorurteile, Vorlieben – und die werden so auch noch bestätigt. Gefährlich sind auch KI-Systeme, die zum Beispiel Informationen manipulieren und

Wahlen beeinflussen.

Kann man das erkennen?

Es gibt sehr viel Unsinn, der herumschwirrt und man weiß nicht, wo die Informationen herkommen. Ob etwas auf eine künstliche Intelligenz zurückgeht, kann der Mensch oft gar nicht mehr erkennen, weil die Methoden schon so präzise sind. Da braucht man wieder künstliche Intelligenz, die so etwas identifizieren kann.

Man will künstlicher Intelligenz auch Moral beibringen.

Moral und Ethik bei KI ist schwierig. Wenn man die Leute in

China fragt, ob es sie nicht beängstigt, wenn es in jeder Straßenlaterne eine Kamera gibt, sagen sie: „Nein, wir wollen das, da kann ich auch als Frau in der Nacht heimgehen, ohne Angst zu haben.“ Man könnte meinen, in China sind die Menschen darauf getrimmt, so zu denken. In Südkorea ist es aber ähnlich: die Menschen fühlen sich wohl, wenn es überall Kameras gibt. Für uns ist das ein Horrorszenario, eine totale Überwachung. Ethik und Moral sind lokal verschieden.

Was braucht es für die Akzeptanz von KI in

Europa?

Hier muss alles gesetzlich abgedeckt sein. Selbstfahrende Busse werden in Peking schon lange staatlich eingesetzt. Das funktioniert – die Menschen haben Vertrauen. In Europa diskutiert man über Gefahren und Gesetze. Aber wenn das Ding nie auf der Straße ist, werden die Leute auch nie Vertrauen dazu haben. Und dann werden diese Technologien immer komplizierter, sodass nur kleine Gruppen von Nerds sie bedienen können.

Was wäre eine Möglichkeit?

Die Technik muss menschlicher werden. Das Tippen mit dem Finger im Handy ist nicht menschlich. Man muss sich mit Maschinen unterhalten können.

Die EU-Kommission hat die neuen ethischen Leitlinien für „vertrauenswürdige KI“ vorgelegt? Wie realistisch sind sie?

Es gibt verschiedene Expertengremien, die oft gar nicht wissen, wie KI gebaut wird und wollen verschiedene Sachen einbauen. Bei uns lernen künstliche Intelligenzen. Da muss ein anderes Konzept her. Man muss mit ihnen reden, was man tun darf und was moralisch verwerflich ist. Genauso wie unsere Kinder müssen wir KI erziehen. Würde man etwas fest hineinprogrammieren, kann es nicht mehr erlernen, alles richtig zu machen.

Lernt man KI als Experte auch gern zu haben?

Man lernt bestimmte Ideen, wie eine Gleichung, gern zu haben. Bei dem Vergleich geht es eher um den Prozess des Erlernens. Aus Daten muss ich der KI auch Moral und Ethik reinfüttern. So wie ich ein Kind zu einem Kriminellen erziehen kann, kann ich ein selbstfahrendes Auto erziehen, bei Rot über die Ampel zu fahren.

Apropos: Selbstfahrende Autos wissen noch nicht wirklich, dass ein verwehtes Plastiksackerl ungefährlich ist. Wann glauben Sie, wird es soweit sein?

Das wird noch länger dauern. Eine KI, die viel von der Welt weiß und Sachen beeinflussen kann, mit Menschen reden und sogar Gegenstände bewegen kann, muss über physikalische Gesetze Bescheid wissen. Sie muss zudem soziale Belange kennen: Wenn sich zwei Personen am Straßenrand unterhalten, wissen wir, dass keine plötzlich auf die Straße hüpfen wird. Künstliche Intelligenz ist aber noch weit entfernt, über dieses Hintergrundwissen zu verfügen.

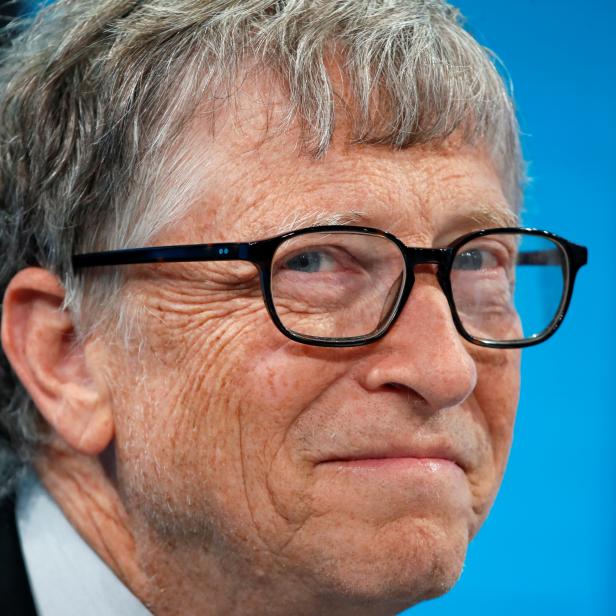

Zur Person

Der 1967 in Bayern geborene Sepp Hochreiter ist Leiter des Instituts für Machine Learning an der Johannes Keppler Universität (JKU) in Linz . Er hat gemeinsam mit seinem Kollegen Jürgen Schmidhuber im Jahr 1991 die Grundlage für KI-Systeme entwickelt. Diese „Long Short Term Memory“ (LSTM) ist als Sprachein- und ausgabe heute in jedem Smartphone eingebaut. Hochreiter forscht an einem Weltverständnis von künstlicher Intelligenz, das unterschiedliches Wissen verbinden kann.

Kommentare