Microsoft warnt vor Risiken bei Gesichtserkennung

Dieser Artikel ist älter als ein Jahr!

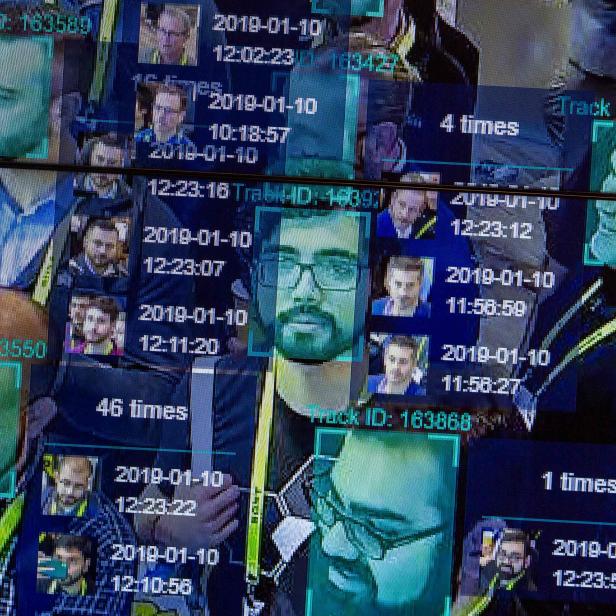

Mit Systemen zur Gesichtserkennung können IT-Unternehmen derzeit viel Geld verdienen. Das liegt unter anderem daran, dass Behörden und Regierungen großes Interesse daran haben. Aber: „Es geht nicht immer nur um Einnahmen. Menschen müssen geschützt werden.“ Tim O’Brien ist Generaldirektor für KI-Programme und Ethikchef bei Microsoft und befasst sich insbesondere mit Gesichtserkennungs-Technologien. Deren Einsatz verspricht grundsätzlich erhöhte Sicherheit und Effizienz. Sie können aber auch einen massiven Eingriff in die persönlichen Freiheiten und grundlegenden Menschenrechte bedeuten. Künstliche Intelligenz (KI) und Big Data brauchen daher neue Formen von Governance – ein wesentliches Thema bei den diesjährigen Alpbacher Technologiegesprächen.

Die Vorteile von Gesichtserkennungs-Software: Nicht nur können Smartphones oder Häuser durch das Abgleichen individueller biometrischen Daten sicher „entsperrt“, sondern unter anderem auch vermisste Personen oder Kriegsopfer rasch identifiziert werden, wie O’Brien erklärt. Die Kehrseite der Medaille: Gesichtserkennungs-Technologie kann zum Nachteil von Minderheiten werden. Das ist der Grund, warum nach den US-Bundesstaaten New Hampshire und Oregon seit einiger Zeit auch Kalifornien deren Einsatz durch Behörden verbietet.

Hoher Risikowert bei Dunkelhäutigen

Ein bekanntes Beispiel für unzulängliche Berechnungen liefert die Software "Compas", wie das US-Medium Pro Publica aufgedeckt hat. Diese ermittelt den Risikowert einer Person als Verbrecher, was Richtern die Urteilsentscheidung erleichtern soll. Ein hoher Risikowert bedeutet Gefängnis, ein niedriger Freigang auf Kaution. Das System ordnet dunkelhäutige Menschen tendenziell einem höheren Risikowert zu als Hellhäutige. Laut O’Brien wurde die Software mit Daten von richterlichen Entscheidungen trainiert und hat somit deren Vorurteile geerbt.

Das große Problem laut O'Brien: Der Mensch tendiert dazu, Technologien zu vertrauen. „Die Präsenz von automatisierten Tools kann den Menschen dazu verlocken, keine eigenen Entscheidungen mehr zu treffen und zu sagen: Ich mach einfach, was der Computer sagt. Selbst wenn ein Grenzschutzbeamter meint, eine Person sagt die Wahrheit, doch die Maschine sagt ‚Lügner‘, ist die Versuchung groß, dem Computer zu folgen. Und dann kann man dieser Person wirklich schaden“, sagt er im futurezone-Gespräch.

In einem weiteren, von der Bürgerrechtsorganisation ACLU durchgeführten Test, wurde einer von fünf kalifornischen Abgeordneten von Amazons „Rekognition“ fälschlicherweise als Verbrecher "erkannt". Die Software, die von US-amerikanischen Strafverfolgungsbehörden genutzt wird, glich die Bilder der Politiker mit einer öffentlich zugänglichen Datenbank für verurteilte Straftäter ab. Laut Amazon sind die Ergebnisse jedoch nicht aussagekräftig: Der Schwellenwert, den ACLU verwendet hatte, sei zu niedrig gewesen.

Um anzuschlagen, musste das System nur zu 80 Prozent sicher sein, dass es eine Übereinstimmung erkannt hat. Die futurezone hat berichtet. Dieser Wert sei nicht angemessen, um Personen sicher zu erkennen. Für den Einsatz bei Behörden empfehle das Unternehmen mindestens 95 Prozent. Doch auch eine fünf-prozentige Fehlerquote könnte einzelnen Personen die Freiheit oder gar das Leben kosten.

Microsoft-Ethikchef Tim O'Brien beim WeAreDevelopers AI Congress 2018

© WeAreDevelopers/felix peschko

Software liest Emotionen

Amazon geht sogar einen Schritt weiter: das Unternehmen hat unlängst verkündet, dass „Rekognition“ den emotionalen Zustand einem Gesichtsausdruck entnehmen kann. O'Brien zeigt Bedenken: „Einen Gesichtsausdruck herzunehmen, um einen emotionalen Zustand schlusszufolgern, sehe ich aufgrund dessen, wie diese Modelle trainiert werden, als problematischen Anspruch.“ Oft würden Forscher Schauspieler einstellen und beauftragen, unterschiedliche Mimiken vorzuzeigen. „Dann sagen menschliche Beobachter: Meine Auffassung über die Mimik dieser Person ist Ekel. Man trainiert ein Modell mithilfe einer menschlichen Wahrnehmung, aber nicht die tatsächliche Emotion des Untersuchungsgegenstandes“, so der Experte.

Auch Microsofts Software ist nicht vor Vorurteilen gefeit. Laut O'Brien ist es aber die Verantwortung eines jeden Unternehmens, Mängel und Schwächen transparent zu machen und in klarer, einfacher Sprache zu dokumentieren. „Es ist sehr interessant, welche Reaktionen wir erhalten, wenn wir mit Kunden oder Partnern teilen, wie viel wir nicht wissen und wohin uns das alles führt“, sagt er. Um das Vertrauen der Kunden zu gewinnen, müssten sie Worte mit Taten stützen. „Fehler sind ok, wenn wir daraus lernen.“

175 Vorurteile

Eine künstliche Intelligenz (KI), die die Basis von Gesichtserkennungs-Technologie ist, gänzlich ohne Vorurteile ist ihm zufolge allerdings kaum möglich. „Es wird immer ein Level an Vorurteilen geben.“ Laut Studien besitzt der Mensch im Schnitt 175 davon – über manche wissen wir bescheid, über andere nicht. O'Briens Lösung: Bewusstsein haben und blinde Flecken eliminieren. „Diese Datenmasse, die wir an einem Tag hinterlassen, bleibt an KI-Experten und Forschern hängen, um ein Datenset zu entwickeln und KI-Modell zu trainieren. Ich spreche von SMS, Filme die wir sehen, Musik die wir hören, E-Mails die wir verschicken, die Sprache, die wir bei unseren Voice Assistents anwenden – all diese digitale ,Abluft' wird von jemandem verwendet, um ein Modell zu trainieren. Also alleine zu wissen, dass so etwas existiert, ist der erste Schritt.“

O'Brien glaubt daran, dass man zukünftig solche Technologien gerechter machen kann: „Ich wäre nicht einmal in der Nähe dieses Business, wenn ich nicht daran glauben würde. Wir wären unverantwortlich, wenn wir nicht ehrlich wären und offen über Risiken sprechen würden. Nur dann kann man eine Zukunft kreieren, in der sich die Menschen wohl fühlen.“

Österreich

Während Gesichtserkennungs-Technologien in mehreren US-Bundesstaaten verboten wurden, soll sie von der österreichischen Polizei ab Dezember eingesetzt werden. Verdächtige sollen anhand der Software des Dresdner Unternehmens Cognitec Systems identifiziert werden, wie das Bundeskriminalamt der futurezone bestätigt hat.

Das Sicherheitspolizeigesetz ermöglicht dem Bundeskriminalamt den Zugriff auf sämtliche Videoüberwachung im öffentlichen Raum und von privaten Einrichtungen wie Tankstellen oder Banken, denen ein öffentlicher Versorgungsauftrag zukommt. Bei schweren Straftaten können Fotos aus den Überwachungskamerabildern generiert werden. Die Software vergleicht folglich bestimmte Merkmale aus dem Gesichtsfeld, die sogenannten biometrischen Daten, mit Bildern aus der Referenzdatenbank der Polizei. Die Technologie soll jedoch nur bei einem kleinen Prozentsatz der Straftaten eingesetzt werden. Die futurezone hat berichtet.

„Diese gesamten Technologien zur automatisierten Gesichtserkennung sind sehr bedenklich“, warnt Datenschutzexperte Christian Jeitler von quintessenz gegenüber futurezone. Die biometrischen Daten, die vermessen werden – beispielsweise wie weit die Wangenknochen oder Augen voneinander entfernt sind – seien höchst sensible Daten. Diese biometrischen Parameter würden erfasst, vermessen und parametrisiert, also mit der polizeieigenen Referenzdatenbank abgeglichen. Für Jeitler ein „extrem hoher Eingriff in die Grundrechte“.

Findet die Software einen Treffer, wird dieser von einem Menschen überprüft. Das ändert laut Jeitler aber nichts an der Situation, dass sensible biometrische Daten mit der Datenbank abgeglichen werden. Wie auch O’Brien ist er der Meinung, dass Menschen, die wenig Erfahrung mit solchen Technologien haben, dem Urteil des Computers oft mehr als dem eigenen.

Kommentare