Vorurteile bei KI: "Probleme oft schon in den Daten"

Dieser Artikel ist älter als ein Jahr!

Künstliche Intelligenz (KI) bietet zahlreiche neue Möglichkeiten, wirft gleichzeitig aber auch viele neue Fragen auf. Zu den größten Risiken zählt vielen Forschern zufolge, dass menschliche Vorurteile durch KI-Systeme reproduziert werden, wodurch soziale Ungleichheit auch verstärkt werden könnte. “Algorithmen werden von Menschen gemacht und basieren auf Daten, die unsere Realität widerspiegeln”, sagte etwa die Wissenschaftlerin Carla Hustedt im futurezone-Interview.

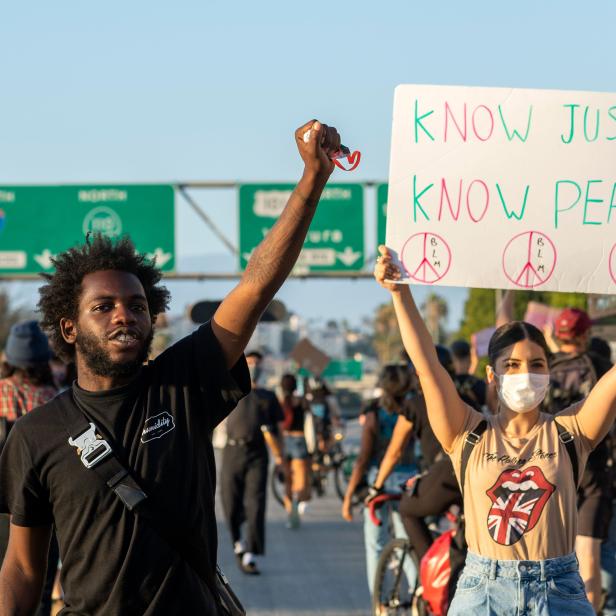

Die Gefahr ist nicht nur theoretisch, wie bereits an mehreren Beispielen zu sehen war. So musste etwa das Massachusetts Institute of Technology (MIT) einen Datensatz entfernen, der Künstlicher Intelligenz rassistische und frauenverachtende Begriffe beigebracht hat. Auch Microsoft hatte bereits mit Rassismus bei einem KI-System zu kämpfen. Und vor kurzem haben auch Linzer Forscher untersucht, wie Algorithmen dazu führen, dass Suchmaschinen - wie etwa Google - sexistisch verzerrte Inhalte liefern.

Bei Google beschäftigt man sich - nicht erst seit dem Erscheinen der Studie - intensiv mit dem Thema und hat entsprechende Programme zum Thema “Responsible AI” - also verantwortungsvoller KI - ins Leben gerufen. Auch ist ein zentraler Punkt von Googles Prinzipien für Künstliche Intelligenz, dass damit keine Vorurteile erzeugt oder verstärkt werden.

Einfallstore für Ungleichheiten

Anna Ukhanova forscht für Google am Thema Machine Learning und Künstliche Intelligenz. Der Erfolg von KI sei demnach direkt mit einem verantwortungsvollen Umgang verbunden, erklärt sie bei einem virtuellen Pressegespräch.

Sie weist darauf hin, dass es in der Vergangenheit immer wieder technische Entwicklungen gab, die Probleme hatten, auf die Bedürfnisse aller Menschen gleichermaßen einzugehen. So war es erst bis vor wenigen Jahren so, dass Frauen bei Autounfällen signifikant öfter verletzt wurden. Der Grund: Crashtest-Dummies und die entsprechenden Sicherheitsvorrichtungen in Autos waren auf eine männliche Statur ausgelegt.

“Unfairness kann bei einem KI-System an verschiedenen Punkten eindringen”, so Ukhanova. Bei KI fangen die Ungleichheiten oft bereits an ganz grundlegender Stelle an.

“Häufige sind die Vorurteile bereits in den Daten”, sagt Fernanda Viegas, eine von Googles führenden KI-Forschern. Grundlage von Machine Learning bzw. Künstlicher Intelligenz sind in der Regel große Datensätze, mit denen die Systeme “trainiert” werden. Diese Daten zu überprüfen, ist nicht einfach. “Wir sind nicht geschaffen, so große Mengen an Daten zu verarbeiten”, sagt Viegas. Aus diesem Grund brauche es Werkzeugen, um mit ihnen umzugehen und mögliche Ungleichheiten bereits früh vorzubeugen. “Wir sind dabei, immer mehr solche Tools zu entwickeln”, so Viegas.

Transparenz

Ein wichtiger anderer Schritt, der Ungleichheit zu begegnen, sei laut Ukhanova Transparenz. Oft sind es nur simple Designänderungen, die bereits einen großen Unterschied machen können. Als sehr simples Beispiel nennt sie Google Translate: Beim automatischen Übersetzer werden etwa geschlechtsneutrale Begriffe so übersetzt, dass in der Zielsprache sowohl die weibliche als auch die männliche Form ausgegeben werden.

Auch sei es wichtig, auch dem Endbenutzer zu zeigen, dass die Technologie ihre Limits hat und so gut es geht zu erklären, wie das System zu bestimmten Ergebnissen kommt.

Die Grenzen der KI

Laut Viegas ist die Debatte grundsätzlich eine schwierige. KI würde immer von extremen Standpunkten aus gesehen. “Entweder es wird als Technologie gesehen, die alles weiß und alle Probleme löst, oder als solche, die uns an den Abgrund führt”, so die Wissenschaftlerin.

Um vorwärts zu kommen, müsse man den Mittelweg sehen: “Reden wir über die tollen Dinge, die mit KI möglich sind, wie etwa das Erkennen von Krebs oder das Vorhersagen von Erdbeben. Gleichzeitig müssen wir aber auch davon sprechen, wo die Technologie versagt, was ihre Probleme sind und wo ihre Grenzen sind”, so die Google-Forscherin. “Nur so können wir es schaffen, dass die Menschen KI vertrauen.”

Kommentare