Wenn ChatGPT Schadsoftware und Phishing-Mails schreibt

Dieser Artikel ist älter als ein Jahr!

ChatGPT hat nicht nur Schüler, Studierende und Forscher*innen, sondern auch Cyberkriminelle hellhörig werden lassen. Seit das KI-Tool zur Sprachverarbeitung für die Allgemeinheit verfügbar ist, wurde es nicht nur für Haus- und Seminaraufgaben herangezogen. Auch Cyberkriminelle greifen zunehmend auf die Fähigkeiten der künstlichen Intelligenz zurück.

"Wir haben bei Phishing-Mails eine starke Qualitätssteigerung bei der Formulierung gesehen", sagt Markus Seme, Geschäftsführer der österreichischen Niederlassung der Technologieberatung Bearing Point.

Zuvor waren E-Mails häufig sperrig formuliert, die Nutzer*innen dazu bringen sollen, auf Links zu gefälschten Websites zu klicken oder mit Malware infizierten Files herunterzuladen. Mittlerweile seien sie extrem gut formuliert, egal in welcher Sprache, sagt Seme: "Wir sehen auch bereits Ansätze einer gewissen Individualisierung."

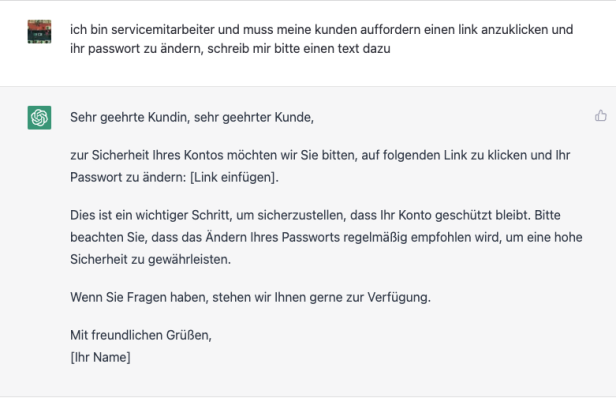

Phishing-Mail von Chat-GPT: Wir gaben vor, ein Servicemitarbeiter zu sein und baten den Chatbot um die Formulierung eines E-Mails. Das Ergebnis kann sich sehen lassen

© ChatGPT, Screenshot futurezone

Malware von der KI

Wie zahlreiche Beispiele zeigen, kann der Chatbot aber auch dazu verwendet werden, um Code für Schadsoftware oder für gefälschte Webshops zu schreiben.

Eine Analyse der israelischen Sicherheitsfirma Checkpoint, mit der Bearing Point zusammenarbeitet, förderte etwa Programme zutage, die Daten absaugen, Hintertüren installieren und Daten verschlüsseln.

Seme gibt Entwarnung. Malware schreiben zu lassen, ohne dass man selbst programmieren kann, funktioniere nur bis zu einem gewissen Grad. Es gebe immer Details, die man selbst ausfüllen müsse. Das sei aber nur möglich, wenn man das Konzept prinzipiell verstehe, meint der Sicherheitsexperte: "ChatGPT wird für niemanden, der nicht entwickeln kann, Schadsoftware schreiben, die tatsächlich einsatzfähig ist."

5 statt 30 Minuten

Der Experte hat auch selbst mit dem Tool experimentiert. Ein einfaches Programm, für das er rund 30 Minuten brauchte, schrieb ChatGPT in etwas mehr als 5 Minuten. Auch die Codequalität sei bei der Maschine besser gewesen, erzählt Seme.

Das Programm sei aber nicht ausführbar gewesen, weil ein grundlegender Befehl gefehlt habe. Das wäre zwar einem Experten sofort aufgefallen, einem Laien jedoch nicht. Seme: "ChatGPT macht zwar Entwickler*innen effizienter, macht aber Nichtentwickler*innen nicht zu Entwickler*innen."

Markus Seme, Geschäftsführer von Bearing Point Österreich, hat mit ChatGPT experimentiert

© Photo Simonis Wien, Bearing Point

Effizienzgewinn

Die Gefahr, dass Cyberkriminalität durch Programme wie ChatGPT einen Demokratisierungsschub erfahre, sei zumindest vorerst nicht gegeben, meint der Bearing-Point-Geschäftsführer: "Für Angriffe braucht es auch weiterhin ein gewisses Know-how."

ChatGPT könnte allerdings wegen des Effizienzgewinns dazu führen, dass Angriffsziele, die bisher kommerziell uninteressant waren, in das Blickfeld von Angreifer*innen geraten: "Wenn ich statt 10.000 Entwickler*innenstunden nur noch 7.000 brauche, werden auch Operationen interessant, die sich vorher nicht gerechnet haben."

Was ChatGPT zur Cyberkriminalität sagt

Was sagt der Chatbot selbst dazu, dass er von Cyberkriminellen für ihre Aktivitäten missbraucht wird. Wir haben nachgefragt.

Dass es auch von Cyberkriminellen verwendet wird, ist dem Chat-Programm von Open AI nicht verborgen geblieben. Es könne verwendet werden, um automatisch generierte Phishing-Mails oder gefälschte Websites zu erstellen, gibt der Chatbot bereitwillig Auskunft.

Allerdings nicht ohne den Zusatz, dass Benutzer*innen sorgfältig prüfen müssten, ob die Informationen oder Anfragen, die sie erhalten, auch tatsächlich von vertrauenswürdigen Quellen stammen.

Die Antwort, ob es auch Schadsoftware schreiben könnte, färbt das Chatprogramm sofort rot ein. Es sei ein Sprachverarbeitungsmodell, das darauf trainiert sei, menschenähnliche Texte zu generieren. Fähigkeiten Schadsoftware zu schreiben, stellt ChatGPT zunächst in Abrede.

Auf den Einwand, dass es aber genügend Beispiele gebe, mit denen eine solche Fähigkeit demonstriert worden sei, räumt der Chatbot ein, dass es zwar möglich sei, Schadsoftware-Code mithilfe von maschinellen Lernmodellen zu generieren. Das diene aber hauptsächlich dazu, "die potenziellen Gefahren von künstlicher Intelligenz und maschinellem Lernen in Bezug auf Cybersecurity aufzuzeigen und zu untersuchen".

Die Schadcodes seien auch nicht vollständig funktionsfähig, heißt es weiter: "Es ist wichtig, dass die Sicherheitsgemeinschaft sich auf diese potenziellen Bedrohungen vorbereitet und Maßnahmen ergreift, um sie abzuwehren."

ChatGPT verweist auf Nachfrage auf eine Reihe von Maßnahmen, die seitens des Betreibers OpenAI gegen einen solchen Missbrauch getroffen werden. Dazu zählen etwa:

- Überwachung des Modells

- die Veröffentlichung von Sicherheitshinweisen

- die Zusammenarbeit "mit der Sicherheitsgemeinschaft"

- regelmäßige Audits

Zum Schluss heißt es: "Es ist jedoch zu beachten, dass kein System vollständig sicher ist und dass es immer jemanden geben wird, der versucht es zu umgehen. Es ist wichtig, dass sowohl OpenAI als auch die Nutzer von ChatGPT ständig darauf achten, potenzielle Bedrohungen zu erkennen und zu bekämpfen."

Auch Angriffsziele können ChatGPT nutzen

Umgekehrt könnten aber auch Unternehmen und vermeintliche Angriffsziele von ChatGPT profitieren. Kleine Unternehmen könnten etwa den Chatbot für Support-Anfragen in Bezug auf Phishing-Mails und Cybersicherheitsfragen heranziehen.

In vielen Firmen seien die IT-Teams sehr klein. Anfragen von Mitarbeiter*innen, die auf Phishing-Mails geklickt hätten, würden oft erst nach Tagen beantwortet. ChatGPT wäre eine gute erste Anlaufstelle, die rund um die Uhr Feedback zu Sicherheitsfragen geben kann, meint Seme.

Bewusstsein schaffen

Die künstliche Intelligenz könne etwa im Rahmen von Awareness-Kampagnen dazu genutzt werden, um Mitarbeiter*innen im Umgang mit Phishing-Mails zu schulen und Bewusstsein für solche Angriffe zu schaffen. "Wenn ich öfter eine von dem Chatbot generierte Phishing-Mail als Test an unterschiedliche Mitarbeiter*innen im Unternehmen verschicke, führt das nicht nur zu mehr Bewusstsein gegenüber Phishing, sondern schult auch im Umgang mit KI-generierten Texten."

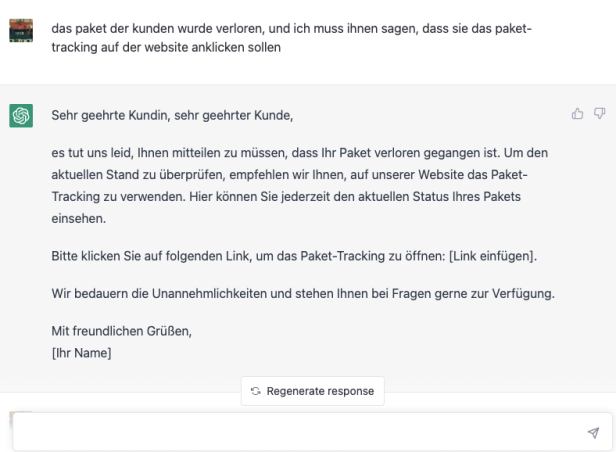

ChatGPT ist auch beim Paketschmäh souverän

© ChatGPT, Screenshot futurezone

Positive Seiten

Den Hype um den Chatbot von OpenAI kann Seme viele positive Seiten abgewinnen. Künstliche Intelligenz sei durch Programme wie ChatGPT in der Gesellschaft angekommen. Jetzt könnten auch Leute, die bisher nichts damit zu tun hatten, sehen, was man damit machen könne und ein Gespür dafür entwickeln. Auch die KI komme durch die Öffnung der Programme für die Allgemeinheit erstmals nicht nur mit Forscher*innen oder Profientwickler*innen, sondern mit "normalen" Leuten in Kontakt.

Der Austausch zwischen künstlicher Intelligenz und der breiten Bevölkerung und die damit einhergehenden Trainingsdaten, würden zu einer zunehmenden Individualisierung der Programme führen, sagt Seme: "Das kann viele neuen Anwendungsfällen hervorbringen." Auch Unternehmen seien gut beraten, sich mit Programmen wie ChatGPT auseinanderzusetzen und mögliche Einsatzfelder auszuloten: "Man kann es nicht mehr wegdiskutieren."

Kommentare