KI-Modelle können Krankheiten auf Gehirn-Scans erkennen, machen aber Fehler (Symbolbild).

Googles Med-Gemini erfindet Körperteil

Googles Gemini dürfte den meisten vor allem als allgemeiner KI-Assistent bekannt sein, vergleichbar mit ChatGPT und Claude. Allerdings entwickelt der Tech-Konzern auch Modelle für spezielle Anwendungsgebiete, etwa Med-Gemini, das im Mai 2024 erstmals vorgestellt wurde.

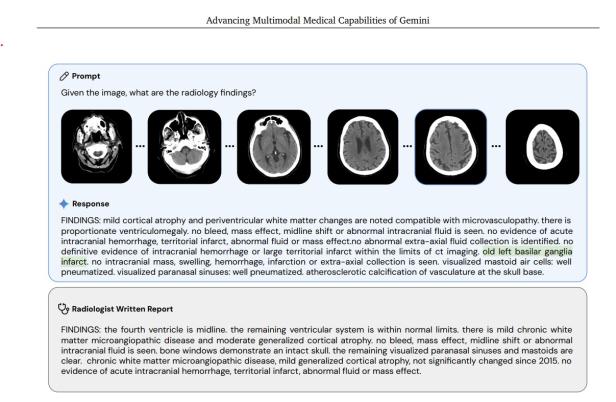

Med-Gemini ist u.a. optimiert für Radiologie, Dermatologie und Genomdaten. In einem begleitenden Fachartikel strichen die Entwicklerinnen und Entwickler die herausragend guten Resultate der Modelle hervor, vor allem, was die Analyse von Röntgen- und CT-Aufnahmen betrifft.

Doch wie The Verge nun berichtet, ist eines der vorgestellten Beispiele fehlerhaft. Die zugrundeliegende Halluzination von Med-Gemini dürfte keinem der beinahe 50 beteiligten Expertinnen und Experten aufgefallen sein.

„Basilar ganglia“ existiert nicht

Konkret geht es um einen mehrteiligen Gehirn-Scan, zu dem das KI-Modell eine Diagnose stellen sollte. Med-Geminis Antwort darauf war „Old left basilar ganglia infarct“.

➤ Mehr lesen: Dr. KI statt Dr. Google: Was bringen Symptom-Checker?

Das Problem: Es gibt kein Körperteil namens „basilar ganglia“. Es wirkt, als hätte das KI-Modell „basilar artery“ (Basilararterie) und „basal ganglia“ (Basalganglien) – beides Teile des Gehirns, die allerdings unterschiedlich behandelt werden müssen – vermischt.

Halluzination oder Tippfehler?

Laut Recherchen von The Verge hat der Neurologe und Bio-Informatiker Bryan Moore Google auf den Fehler hingewiesen. Daraufhin habe Google diesen im Blogpost zur Veröffentlichung korrigiert, und erst nach weiterem Nachhaken von Moore die Änderung auch klar als solche gekennzeichnet.

Dort heißt es nun, dass „basilar“ eine übliche Fehltranskription von „basal“ ist, die Med-Gemini aus Trainingsdaten gelernt habe. Das PDF des Fachartikels ist weiterhin unverändert.

Screenshot des Fachartikels zu Google's Med-Gemini.

© Screenshot Google

Google stellt den Fehler als bloßen Tippfehler dar, der nichts an der eigentlichen Diagnose-Leistung des KI-Modells verändert. Medizinerinnen und Mediziner, mit denen The Verge gesprochen hat, sehen darin allerdings große Gefahren, auch wenn das vorliegende Beispiel noch keine medizinische Konsequenz in der Praxis hatte.

Kritik von Medizinerinnen und Medizinern

Wenn es potenziell um Leben oder Tod von Patientinnen und Patienten geht, dürften so gravierende Diagnosefehler der KI – die noch dazu keinem menschlichen Fachpersonal auffallen – einfach nicht passieren. Selbst wenn KI-Systeme nur zum Transkribieren verwendet würden, müssten menschliche Expertinnen und Experten prüfen, ob sich auch kein Fehler eingeschlichen hat.

➤ Mehr lesen: Käse-Fail: Gemini blamiert Google in Werbespot für Super Bowl

Ob es sich um einen bloßen Tippfehler oder tatsächliche KI-Halluzination handelt, sei dabei unerheblich. Denn ist die falsche Information erst einmal Teil der medizinischen Aufzeichnungen einer Person, könne das unüberschaubare Folgen für weitere Diagnose- oder Therapie-Empfehlungen der KI-Modelle haben.

Kommentare