KI erstellt Phantombilder, Experten sind entsetzt

Dieser Artikel ist älter als ein Jahr!

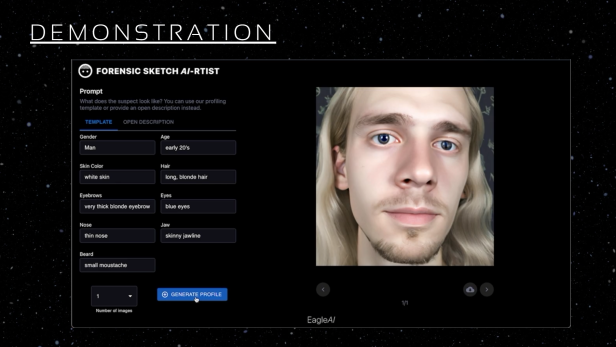

2 Entwickler haben im Rahmen eines Hackathons ein Programm entwickelt, das realistische Phantombilder generiert. Wie ihre Demo zeigt, soll das Programm dafür nur einfachen Zeug*innenaussagen benötigen.

Entwickelt wurde das „Forensic Sketch Program“ (Phantombildprogramm) auf Basis von DALL-E 2. Der KI-basierte Bildgenerator wurde vom Unternehmen OpenAI entwickelt, das auch für ChatGPT verantwortlich ist. Mit der neuen Software sollen Phantombilder zeitnah entstehen können. Im Vergleich dazu würde eine händische Zeichnung zwischen 2 und 3 Stunden in Anspruch nehmen, so die beiden Entwickler.

Testlauf bei Behörden geplant

Das Programm fragt nach Angaben zu Geschlecht, Hautfarbe, Augenbrauen, Nase, Bart, Alter, Haare, Augen und Kinn. Mit einem Klick auf „Profil generieren“ schafft die KI daraus ein superrealistisches Bild.

Gegenüber Motherboard erklärten die Entwickler, das Programm derzeit noch für den tatsächlichen Einsatz in Polizeistationen zu prüfen. Dafür hätten sie bereits die Behörden kontaktiert, um erste Test mit echten Daten durchführen zu können.

Rassistische Stereotype

Allerdings gibt es gegen dieses Vorhaben einige Einwände von Expert*innen. Eine KI in der Kriminalistik zu verwenden könnte dafür sorgen, dass schon existierende Vorurteile noch verstärkt würden. Das betrifft z.B. rassistische Vorurteile oder Geschlechterstereotypen, die es bereits jetzt in Zeug*innenaussagen geben würde.

Das Problem sei nicht, dass Phantombilder so viel Zeit in Anspruch nehmen würden, sondern dass sie sich auf Erinnerungen stützen, die von solchen Vorurteilen beeinflusst sind. KI könne diese sehr menschlichen Probleme nicht beheben, erklärt die Expertin Jennifer Lynch gegenüber Motherboard.

Beeinflussbare Erinnerung

Zudem sei es schwierig, aus einzelnen Merkmalen wie Hautfarbe, Augenfarbe und Alter tatsächlich auf ein gutes Phantombild zu kommen, erklärt sie. Menschen würden Gesichter als Ganzes wahrnehmen. Es könnte aber passieren, dass das KI-generierte Bild mit den richtigen Merkmalen eine ganz andere Person zeigt.

Dieses Bild könnte die tatsächliche Erinnerung der Menschen ersetzten, vor allem weil es sich eben nicht um eine Zeichnung, sondern ein sehr realistisches Bild handelt. Würden solche Bilder veröffentlicht, könnten sie rassistische Stereotype noch befeuern und Ermittlungen stark verlangsamen, sagt die Expertin.

Kritik an DALL-E

Die Plattform, DALL-E 2, steckt ohnehin schon voller Vorurteile. Das zeigte sich schnell nach der Veröffentlichung. So interpretierte das Programm „CEO“ ausschließlich als weiße Männer, „Pflegepersonal“ hingegen stets als weiblich (mehr dazu hier). "Gangster" zeigt hingegen dunkelhäutige Männer und Latinos. Auch wenn OpenAI daran arbeitet, solche Vorurteile aus den eigenen Programmen zu elemiminieren, gibt es dafür keine Sicherheit.

Die beiden Entwickler sagten zu Motherboard, sie müssten den Beschreibungen, die die Polizei selbst macht, vertrauen. Die Verantwortung, dass mit Phantombilder gewissenhaft umgegangen wird, liege bei den Polizeibeamt*innen. Ungereimtheiten bei den generierten Bildern müssten entweder manuell oder automatisch beseitigt werden.

Bereits seit Jahren warnt der UN-Ausschuss CERD vor den Gefahren vom KI-Einsatz bei der Polizei. Hier stehen vor allem Verbrechensprognosen und Gesichtserkennung im Vordergrund. Diese könnten ohnehin schon existierende Vorurteile verstärken, lautet auch ihr Einwand (mehr dazu hier).

Kommentare