Neues Tool "vergiftet" KI-Datensätze und macht sie unbrauchbar

Dieser Artikel ist älter als ein Jahr!

Mit einem neuen Tool soll es möglich sein, die Trainingsdaten von Künstlicher Intelligenz unbrauchbar zu machen. Mit "Nightshade" sollen sich Künstler*innen gegen KI-Modelle wie DALL-E oder Midjourney wehren können.

Die KIs wurden unter anderem mit den Bildern von Künstler*innen trainiert, deren Stil sie anschließend kopieren können. Mit dem neuen Tool kann die KI aber so stark verwirrt werden, dass sie gar keine brauchbaren Bilder mehr produziert. Tippt man einen Text ein, der nach Hunden verlangt, produziert sie Katzen, fragt man nach Autos bekommt man Kühe, heißt es bei MIT Technology Review.

➤ Mehr lesen: Ich habe 16 Bilder-KIs getestet, damit ihr es nicht tun müsst

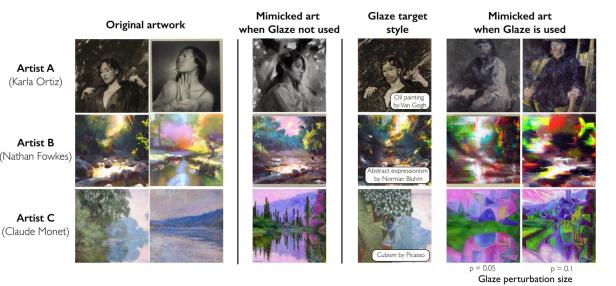

© Shan et. al., 2023.

Entwickelt wurde das Tool von einem Team um Ben Zhao von der University of Chicago. Sie entwickelten mit "Glaze" bereits ein Tool, das Künstler*innen zum Schutz ihrer Werke einsetzen können. Es verhindert, dass KI-Firmen die Arbeiten zum Training ihrer Sprachmodelle analysieren.

Schwachstelle von KI ausgenutzt

Beide Tools funktionieren dabei ähnlich. Sie verändern einzelne Pixel so, dass es für das menschliche Auge nicht wahrnehmbar ist. Künstliche Intelligenz liest die Bilder allerdings vollkommen anders und erkennt nicht, was darauf tatsächlich zu sehen ist.

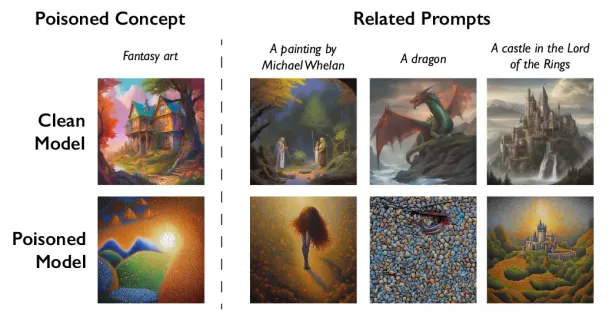

© Shan et. al., 2023.

Dabei wird eine Schwachstelle von KI-Modellen ausgenutzt. Auf der Suche nach neuen Trainingsdaten laden sie massenweise Inhalte aus dem Netz. Darunter sind auch die manipulierten Daten, die Verwirrung stiften sollen. Sie trainieren dem Modell dann etwa an, dass Bilder von Handtaschen eigentlich Toaster sind und Hüte eigentlich Kuchen.

➤ Mehr lesen: Dürfen KI-Generatoren meine Bilder zum Trainieren verwenden?

Bildgeneratoren werden unbrauchbar

Ein Test mit der letzten Version der KI von "Stable Diffusion" zeigt, dass nur 50 manipulierte Bilder notwendig waren, um die Bilder unbrauchbar zu machen. Mit 300 manipulierten Bildern kann die KI Katzen und Hunde nicht mehr unterscheiden.

© Shan et. al., 2023.

Nightshade soll dabei nicht nur den einfachen Begriff "Hund", sondern genauere Beschreibungen wie "Welpe", "Husky" oder "Wolf" mit beeinflussen. Auch Bilder in ähnlichen Genres sind betroffen. Schickt man der KI ein manipuliertes Fantasy-Bild von einem Drachen, wird sie auch mit einem Schloss im Herr-der-Ring-Universum Probleme haben.

Unterstützung für Künstler*innen

Nightshade soll in Glaze integriert werden. So können Künstler*innen selbst entscheiden, ob sie ihre Kunst schützen oder den Datensatz vergiften wollen. Das Programm wird als Open Source verfügbar sein. "Je mehr Menschen es verwenden und ihre eigene Version davon machen, desto stärker wird das Tool", sagt Zhao zu MIT Technology Review.

➤ Mehr lesen: Große Bildagentur verklagt KI-Bildgenerator

Um die großen KI-Modelle anzugreifen, benötigt es allerdings Tausende solcher manipulierter Bilder. Das Tool soll aber ein erster Schritt sein, einen Verteidigungsmechanismus gegen den Diebstahl von Kunst durch KI-Modelle zu schaffen.

Kommentare