Midjourney Papagai

KI-Bildgeneratoren: Was sie können und wie man sie verwendet

Dieser Artikel ist älter als ein Jahr!

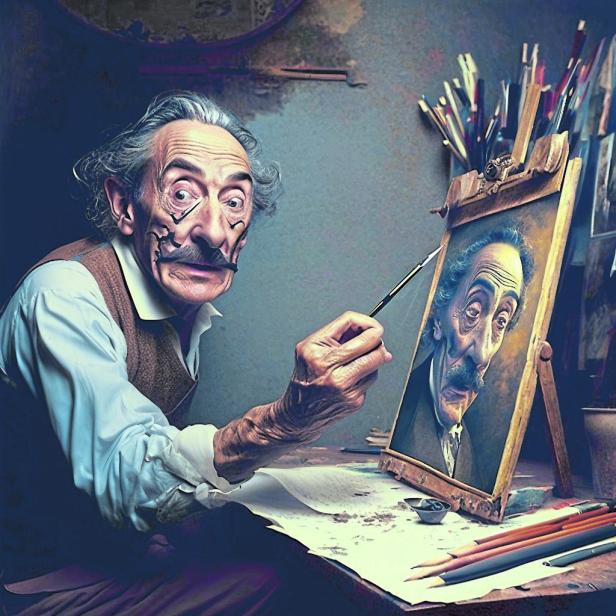

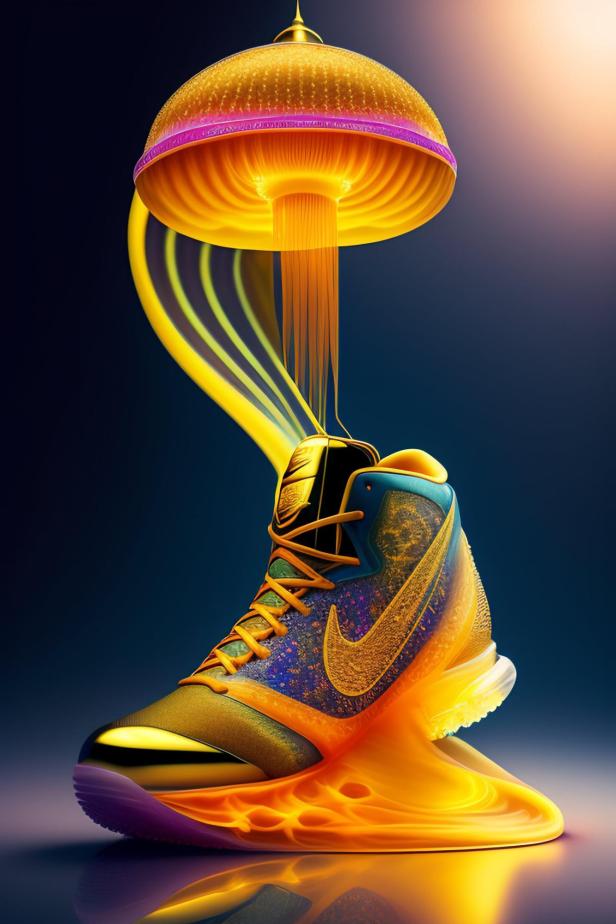

Ein bildhübsches, kindliches Gesicht einer rothaarigen Frau mit Papagei im Gesicht, das wie ein Foto aussieht. Ein berühmter Maler, der sich selbst malt. Ein Nike-Schuh mit Qualle. All diese Ideen lassen sich in wenigen Sekunden mit Bildgeneratoren im Netz erstellen. Die Bildgeneratoren mit den Namen Dall-E, Midjourney oder Stable Diffusion basieren dabei allesamt auf einer künstlichen Intelligenz (KI), die derart beeindruckende Bilder gestalten kann.

Neue Möglichkeiten

Auch völlig realistische Fotos in einem bestimmten Kunst-Stil sind möglich, ebenso wie Infografiken zu bestimmten Themen oder Webdesign-Ideen. Für viele Berufszweige könnten die Bildgeneratoren eine wichtige Ergänzung bei der Gestaltung sein.

Die neue Technologie, die gerade einen massiven Boom erlebt, kann etwa Grafiker*innen dabei helfen, neue Ideen für Logos oder Kunstwerke zu entwickeln, oder Architekt*innen bei der Gestaltung von Innenräumen helfen sowie Modedesigner*innen bei der Gestaltung von Mustern.

So funktionieren KI-Generatoren

Doch wie kommen die computergenerierten Bilder eigentlich zustande? Die meisten der besagten KI-Modelle verwenden dafür „neuronale Netze“. Diese neuronalen Netze wurden zuvor mit einer gigantischen Menge an bestehenden Bildern trainiert. Dabei wurden etwa tausende Bilder einer Katze in das Computersystem eingegeben. Die KI hat anhand dieser Fotos gelernt, was genau die Merkmale einer Katze sind, um sie im Anschluss nachzuahmen. Die meisten KI-Bildgeneratoren basieren auf mehreren, unterschiedlichen Datenbanken.

Viele dieser Bilder, mit denen die neuronalen Netze lernen, stammen aus dem Internet. Firmen, wie OpenAI suchen gezielt nach Bildern und dazugehörigen Textbeschreibungen, mit denen die Maschinen selbstständig lernen. Je besser die Bildbeschreibung, desto besser ist am Ende auch die Datenbank und damit auch die von der KI generierten Bilder.

Mit Midjourney kreiert: Salvador Dali malt sich selbst

© Midjourney.com

Ausprobieren leicht gemacht

Es macht daher Sinn, verschiedene Bildgeneratoren auszuprobieren, um den zu finden, der für den jeweiligen Einsatzzweck am besten geeignet ist. Die neuen KI-Bildgeneratoren sind nämlich nicht nur professionellen Anwender*innen vorbehalten. Im Netz kann sie jede*r kostenlos ausprobieren.

Einer der Bildgeneratoren, der kostenlos ausprobiert werden kann, heißt Dall-E. Er stammt von demselben Unternehmen wie der beliebte Chatbot ChatGPT, der Texte für einen schreibt. OpenAI hat den Bildgenerator als eine der ersten Firmen veröffentlicht, viele weitere Bildgeneratoren folgten. Neben Dall-E gibt es etwa auch noch Midjourney und Stable Diffusion.

Auf dem Weg zum Ausprobieren lauern nur noch organisatorische Hürden: Bei Dall-E und Stable Diffusion muss man sich jeweils einen eigenen Account erstellen, bei Midjourney ist ein Discord-Account Voraussetzung für die Nutzung. Bei Dall-E muss man leider auch seine Telefonnummer dafür angeben.

Dieses Bild wurde mit Stable Diffusion gemacht und zeigt einen Nike-Schuhe mit quallenartiger Verbindung zu einer Lampe

© Stable Diffusion

So werden aus kurzen Texten Bilder

Alle drei genannten KI-Bildgeneratoren verwandeln kurze Texteingaben in Bilder. Wer etwa „schwarze Katze, die auf dem Sofa sitzt“ eingibt, bekommt 4 Bilder einer solchen Darstellung angezeigt. Die Bilder, die die Generatoren ausspucken, sehen meistens glaubwürdig aus. Bei manchen Objekten ist zu sehen, dass diese nicht sauber ausgeführt worden sind. So könnten die Abgrenzungen der Katze vom Hintergrund undeutlich ausfallen, oder etwa die Schnurrhaare fehlen.

In der folgenden Darstellung haben wir folgenden Eingabe ausprobiert: „black cat sitting on a pink couch, color, living room background“.

Schwarze Katze

3 Tipps für die besten „prompts“

Je mehr Informationen man als sogenannten Befehl („prompt“) eingibt, desto genauere Ergebnisse bekommt man ausgespuckt. Der Begriff prompt kommt von Prompt Engineering. Als „prompt“ bezeichnen die Entwickler*innen der KI-Modelle das Texteingabefeld, um der KI Bilder zu entlocken. Damit man nicht ewig mit „prompts“ herumexperimentieren muss, oder enttäuscht wird, weil das Bild nicht den Erwartungen entspricht, geben wir euch hier ein paar Tipps:

- Generell empfiehlt es sich, alles, das man im Bild sehen möchte, möglichst genau und ausführlich zu beschreiben. Es können durchaus lange Phrasen sein, die man eingeben kann. Bei manchen Generatoren wie Stable Diffusion gibt es auch ein Eingabefeld, in dem man festlegen kann, was man *nicht* am Bild sehen möchte.

- In einen „prompt“ können neben einer langen, ausführlichen Beschreibung, was man sehen möchte, auch bestimmte Zusatzangaben gemacht werden. Man kann etwa mit einem Beistrich von der Hauptphrase getrennt Kunststile eingeben, wie Pop-Art oder Comic, oder aber man gibt die Namen von bekannten Künstler*innen ein, um Werke in deren Stil zu erhalten. Wer möglichst fotorealistische Motive erhalten möchte, kann auch Wörter wie „hyperrealistisch“ benutzen, um die KI darauf hinzuweisen, dass es erwünscht ist, dass das Bild möglichst echt aussieht. Der Fantasie sind keine Grenzen gesetzt.

- Wer sich nicht genau vorstellen kann, was man als prompt eingeben könnte, kann sich daran orientieren, was andere Menschen verwenden. Das geht etwa über die Suchmaschine „Lexica“. Dort können Einsteiger*innen sich durch die Bilder klicken. Wer KI-basiert Bilder erstellen möchte, findet hier viel Inspiration.

Wir haben etwa noch den prompt „elon musk sitting on a shiba inu dog, smoking a big spliff, hyperrealistic“ ausprobiert. Dall-E spuckte dabei kein Ergebnis aus, sodass wir den prompt auf „a rich guy sitting on a shiba inu dog, Smoking a big spliff, hyperrealistic“ geändert haben, um ein ähnliches Bild zu erhalten. Die Eingabe von prominenten Persönlichkeiten verstößt offenbar gegen die Nutzungsrechte von Dall-E.

Bekiffter Elon Musk und ein Shiba Inu

Nicht umsonst

Wer die Werkzeuge beruflich, häufig und in hoher Qualität oder Schnelligkeit nutzen möchte, muss dafür allerdings Geld in die Hand nehmen. Alle KI-Bildgeneratoren verlangen bestimmte Gebühren, wenn man sie regelmäßig nutzt. Das liegt unter anderem darin, dass es auch jedes Mal für die Firmen Rechenleistung - und damit auch Geld und Energie - kostet, wenn neue Bilder generiert werden.

Bei Dall-E kann man 50 Mal kostenlos ausprobieren, bei Midjourney sind es 20 und bei Stable Diffusion sind es 100, wobei immer 4 Bilder auf einmal generiert werden. Bei Dall-E kann man im Anschluss Credits dazu kaufen, bei Midjourney gibt es ein Abo-Modell, bei Stable Diffusion ebenfalls eine monatliche Mitgliedschaft.

Was ist sonst noch zu beachten?

Meist kann man die Bilder, die man per KI erstellt hat, privat nutzen, etwa auf der eigenen Webseite oder auf Instagram. Man sollte sich aber vorher die Allgemeinen Geschäftsbedingungen (AGB) der Bildgeneratoren durchlesen. Speziell dann, wenn man die Werke geschäftlich nutzen will. Ein Urheberrecht für KI-Bilder gibt es nicht, aber die jeweiligen Firmen hinter den Bildgeneratoren können Lizenzbedingungen für die Verwendung festlegen.

Rund um KI-Bilder gibt es rechtlich gesehen jedoch auch einige Grauzonen, die aber in erster Linie die Trainingsdaten und damit die Firmen hinter den KI-Bildgeneratoren betreffen. Da beim Trainieren möglicherweise auch Werke verwendet worden sind, die durch Lizenzen geschützt waren, oder Werke von Künstler*innen verwendet wurden, die dies explizit nicht erlaubt hatten, könnte es hier noch einige Gerichtsprozesse geben, um gewisse Dinge zu klären. Sowohl Getty Images als auch einige Künstler*innen haben bereits erste Klagen eingereicht.

Kommentare