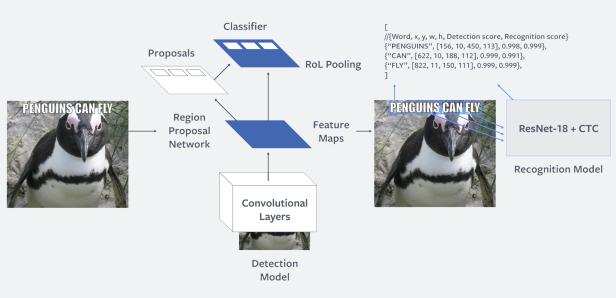

Es gibt bereits Systeme, die Waffen erkennen können, doch der Kontext fehlt meist - hier müssen Menschen nachhelfen

Wieso Terror-Livestreams im Internet kaum zu stoppen sind

Dieser Artikel ist älter als ein Jahr!

17 Minuten: So lange wurde der Terroranschlag in Neuseeland vergangenen Freitag auf Facebook Live übertragen. Bereits im Vorfeld kündigte der 28-jährige Attentäter (es gilt die Unschuldsvermutung) auf dem Imageboard 8chan an, dass er die Tat live streamen werde. Wenig später setzte der rechtsextreme Australier sein Vorhaben in die Tat um. Er ermordete zumindest 50 Menschen in zwei Moscheen in Christchurch. Das rechtsextreme Massaker warf zahlreiche Fragen auf, unter anderem auch nach der Rolle der sozialen Medien. Denn obwohl Facebook aus rechtlicher Perspektive den Inhalt schnell genug entfernte, zeigte das Internet, dass es nie vergisst. Das 17-Minuten-Video verbreitete sich rasant im Netz und ist auch heute noch, trotz Aufrufen der neuseeländischen Polizei, auf zahlreichen Portalen zu finden.

Ein Moderator für 150.000 Nutzer

„Ich verstehe nicht, wie dieses Video 17 Minuten lang gestreamt werden konnte“, sagte eine anonyme Quelle, die Einblick in Facebooks Lösch-Strategie hat, gegenüber Motherboard. Die US-Nachrichtenseite veröffentlichte die Richtlinien, nach denen Facebook-Moderatoren Inhalte überprüfen. Weltweit beschäftigt Facebook 15.000 Mitarbeiter, die fragwürdige Inhalte prüfen und bei Verstößen entfernen müssen. Während dies bereits bei Kommentaren, Bildern und Videos eine große Herausforderung darstellt, sind Live-Videos komplexer. „Livestreams sind noch etwas schwieriger, da man manchmal die Liveaufnahme im Auge behalten muss, während man sich eine frühere Szene davon ansieht. Das geht oftmals nicht mit Ton“, sagt die anonyme Quelle.

15.000 Moderatoren gegen mehr als 2,3 Milliarden Nutzer – jeder Moderator müsste laufend die Inhalte von mehr als 150.000 Nutzern im Auge behalten. Doch Facebook-CEO Mark Zuckerberg wünscht sich ohnedies, dass diese Aufgabe künftig nicht mehr von Menschen übernommen wird. In seinen Anhörungen vor dem US-Senat und Kongress betonte er stets, künstliche Intelligenz werde alle Probleme des Internet-Konzerns lösen: Auch jene von Livestreams.

"Praktisch nicht einsetzbar"

Experten bezweifeln jedoch, dass die Verbreitung solchen Materials, wie beim Anschlag in Christchurch, durch KI verhindert hätten werden können. „Die Erkennung von Waffen ist sehr schwer, denn optisch ist eine echte Waffe von einer Attrappe nur schwer unterscheidbar“, sagt Martin Kampel, Senior Scientist am Computer Vision Lab der TU Wien. „Durch die vielen Fehlalarme ist das praktisch nicht einsetzbar.“ Kampel forscht bereits seit zwei Jahrzehnten an der maschinengestützten Erkennung von Bildern und Videos. „Man muss zwischen der Erkennung von Objekten und Verhaltensmustern unterscheiden. Letzteres ist aufgrund der hohen Variabilität im menschlichen Verhalten deutlich komplexer. Die Zahl der menschlichen Verhaltensmuster ist nahezu unendlich.“

Ein Facebook-System kann mittlerweile automatisiert beleidigende Memes erkennen

Bereits Objekterkennung, bei dem beispielsweise eine Katze oder ein Stoppschild verlässlich aus verschiedenen Perspektiven erkannt werden soll, stellt eine gewisse Herausforderung dar. „Man muss zunächst eine Trainingsdatenbank aufbauen, die aus tausenden Aufnahmen besteht. Mit diesem Bilddatensatz trainiert man dann ein Modell, das Wege finden muss, etwas möglichst zuverlässig zu erkennen“, erklärt Kampel. Wenn diese Trainingsdaten nicht umfangreich genug sind, steigt die Fehlerrate des Algorithmus. Während die Objekterkennung für Bereiche wie autonomes Fahren, beispielsweise zur Erkennung von Verkehrsschildern und Passanten, besonders wichtig ist, wäre es für die Filter von Facebook aber nur ein Puzzlestein von vielen. Denn eine Waffe ist nicht nur in problematischen Inhalten zu sehen, sondern auch in unbedenklichen Beiträgen, wie Nachrichtenclips oder Filmtrailern.

Verhalten schwer erkennbar

Daher hofft man vor allem auf die Verhaltensanalyse. „Bei der Verhaltensanalyse versucht man, eine Szene zu verstehen und diese semantisch zu interpretieren, beispielsweise um zu erkennen, ob zwei Personen miteinander raufen“, sagt Kampel. „Das Verhalten der Menschen ist sehr variabel. Zwei Menschen, die in einer U-Bahn raufen, könnten nur sehr schwer von einem Liebespaar unterscheidbar sein. Da gibt es oftmals Fehlalarme.“ Die hohe Komplexität erhöht auch den Rechenbedarf ungemein, weswegen Facebook selbst an eigenen Chips arbeitet, die ausschließlich derartige Berechnungen durchführen sollen.

Das Grundproblem der fehlenden Daten löse man damit aber dennoch nicht, so Kampel: „Es gibt nicht so viele Aufnahmen von Menschen, die gestürzt sind, oder Unfallsituationen, die man zum Training dieser Datenmodelle nutzen könnte. Vor allem Gewaltszenen sind oftmals sehr individuell und schwer als solche erkennbar.“ Dennoch hätten Konzerne wie Facebook, Google oder Amazon, einen deutlichen Vorteil gegenüber Universitäten und Forschungsstätten, an spezifischen Anwendungen arbeiten. Diese IT-Konzerne haben nicht nur mehr Budget, sondern auch viel mehr Daten.

Menschliches Versagen

In gewissen Bereichen konnte Facebook bereits Erfolge vermelden. So werden laut Zuckerberg bereits 99 Prozent aller terroristischen Inhalte automatisch erkannt und vor der Veröffentlichung gelöscht. Neue KI-Tools sollen zudem beleidigende Memes und Rachepornos automatisch erkennen und entfernen. Auch bei der Erkennung von gewalttätigen und expliziten Inhalten wird Facebook nach eigenen Angaben besser: Wurden Ende 2017 erst 71,6 Prozent der fragwürdigen Inhalte automatisch erkannt, waren es ein Jahr später bereits 98,6 Prozent.

Dennoch wird Facebook trotz hoher Investitionen in KI-Technologien noch eine Weile auf menschliche Moderatoren angewiesen bleiben. Das ist dem US-Konzern offenbar selbst bewusst, der vor allem im Kampf gegen Fake News verstärkt mit lokalen Organisationen zusammenarbeitet, die fragwürdige Inhalte markieren.

Auf die bisherigen Mittel – hoffen, dass Nutzer fragwürdige Inhalte melden – darf man sich offenbar nicht verlassen. Die Liveübertragung des Anschlags von Christchurch hatte laut Facebook „weniger als 200 Zuschauer“, doch kein einziger davon meldete es. Erst zwölf Minuten nach dem Ende des Livestreams und 4000 Aufrufe später meldete es ein Nutzer. Da war es aber bereits über das ganze Netz verstreut.

Kommentare