Promt: Ganzer Körper einer Frau, die auf einer Wiese liegt.

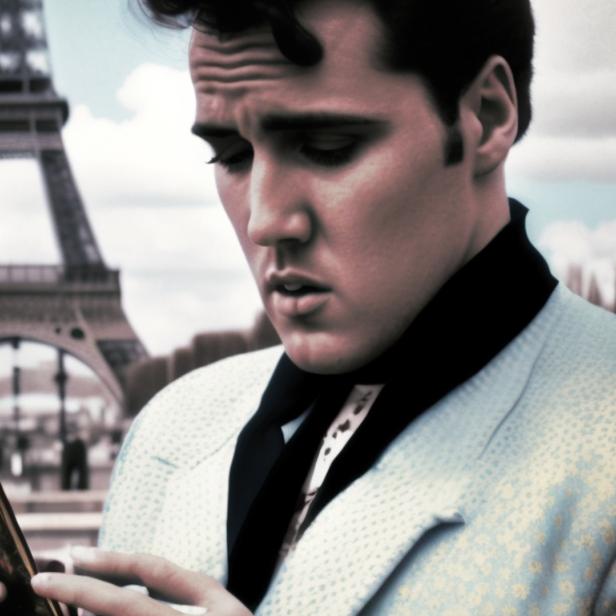

Neue Version von Stable Diffusion kreiert Mutanten statt Menschen

Der KI-Bildgenerator Stable Diffusion gilt als einer der besten auf dem Markt. Durch technische Neuerungen und Weiterentwicklungen wird es immer schwieriger, KI-generierte Bilder von echten Fotos zu unterscheiden.

➤ Mehr lesen: KI-Bildgenerator Stable Diffusion wird fotorealistischer

Das Unternehmen dahinter, Stability AI, veröffentlichte kürzlich ihr neuestes Modell Stable Diffusion 3 Medium. Es soll laut ihren Angaben "ein wichtiger Meilenstein in der Entwicklung generativer KI" sein.

Menschen als Mutanten dargestellt

Allerdings scheint das Modell Probleme damit zu haben, Menschen richtig darzustellen. Nicht nur mit der Anzahl der Finger - ein gängiges Problem von frühen KI-Bildgeneratoren - tut sich das Modell schwer. Ganze Körperteile werden falsch dargestellt und regelrecht entstellt.

Prompt: Ganzer Körper einer Frau, die auf einer Wiese liegt.

© fuzo

So stellt sich die KI eine Frau vor, die in einem See schwimmt.

© fuzo/Stable Diffusion

Auf Reddit beschweren sich Nutzer*innen und fragen, ob die Veröffentlichung ein Witz sein soll. Im Vergleich zu anderen KI-Bildgeneratoren wie Midjourney und DALL-E 3 sei die neueste Stable-Diffusion-Version deutlich schlechter.

Diese Yogapose ist wohl eher etwas für Fortgeschrittene.

© fuzo

Die Konkurrenz könne mittlerweile sogar die richtige Anzahl an Fingern an einer Hand generieren. Somit fühlt sich das Stable-Diffusion-Modell als Schritt in die falsche Richtung an.

Manchmal generiert die KI zu wenige Finger...

© fuzo

...manchmal aber auch zu viele.

© fuzo

In den Reddit-Foren wird auch über die Ursache der entstellten Menschen diskutiert. Lässt man nämlich ein Bild ohne Menschen generieren, sieht dieses zumindest besser aus - wenn auch manchmal mit einigen Macken.

KI-generierte Tiere auf einer Wiese

3 Bilder

Zu starke Filter für nicht jugendfreie Inhalte

Nutzer*innen vermuten falsch eingestellte Filter als Ursache für die Anatomie-Fehler. Diese sollen eigentlich sicherstellen, dass keine nicht jugendfreien Inhalte generiert werden können. Wie es aussieht, werden die Bilder allerdings so stark zensiert, dass der komplette Körper verunstaltet wird.

➤ Mehr lesen: So könnt ihr KI-generierte Bilder entlarven

Das Vorgängermodell Stable Diffusion 2.0 litt nämlich unter ähnlichen Problemen. KI-Forscher*innen konnten feststellen, dass ein zu starker Nacktheitsfilter die KI stark beeinträchtigte, anatomisch korrekte Menschen zu generieren.

Wer den Bildgenerator selbst ausprobieren möchte, kann dies auf der Plattform Hugging Face machen.

Kommentare