Ist Elvis doch nicht tot?

So könnt ihr KI-generierte Bilder entlarven

Dieser Artikel ist älter als ein Jahr!

Ein Bild sagt mehr als tausend Worte. Ein gefälschtes Bild erzählt jedoch eine falsche Geschichte. Das können harmlose Scherze sein, wie ein Papst, der einen modischen Daunenmantel trägt. Das können aber auch hetzerische Erzählungen sein, wie eine Gruppe mutmaßlicher Ausländer, die einen Tumult anzettelt (siehe Faktenkasten).

All diese Bilder können innerhalb von Sekunden mit künstlicher Intelligenz (KI) erstellt werden. Bildergeneratoren wie „Dall-E“, „Midjourney“ oder „Stable Diffusion“ benötigen nur eine Textbeschreibung. „Der erste Hype mit den modischen Bildern des Papstes oder der angeblichen Verhaftung von Donald Trump ist abgeklungen“, sagt Andre Wolf von der Faktencheck-Plattform Mimikama zur futurezone. Es seien bereits Gewöhnungseffekte eingetreten: Menschen wüssten nun, dass solche generierten Bilder möglich sind und seien schon achtsamer geworden.

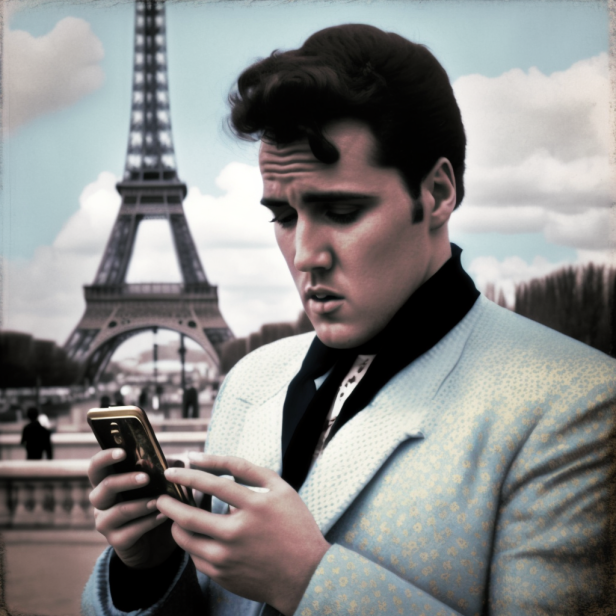

Das Bild von Elvis Presley wurde mit Midjourney erstellt und dient als Beispielbild.

© Midjourney

Die futurezone zeigt (anhand des obigen Beispielbildes), woran man Fotos erkennen kann, die mit einem KI-Programm erstellt wurden.

Auf Details und kleine Fehler achten

Wichtig ist, sich das Bild genau anzusehen. Gibt es irgendwelche Mängel? Vielleicht sind Teile des Bildes verschwommen, die eigentlich scharf sein sollten. Oder es treten Schatten an Stellen auf, wo eigentlich keine sein dürften.

Gesichtsmerkmale unter die Lupe nehmen

Ein guter Tipp, um falsche Bilder zu erkennen, ist, sich Gesichter genauer anzusehen. Menschen fällt es nämlich besonders leicht, abweichende Gesichtsmerkmale festzustellen. Wenn man etwa das Gefühl hat, dass bestimmte Gesichtsproportionen nicht passen, könnte es sich um ein KI-generiertes Bild handeln.

Auffällige Merkmale sind auch Falten. Häufig sind sie zu weich oder zu stark eingezeichnet. Die Stirn des falschen Elvis Presley wäre etwa ein Beispiel, wo die Falten eher Gräben ähneln. Falls vorhanden, lohnt sich auch ein Blick auf Brillen, die oft verzerrt dargestellt werden.

Bildgeneratoren haben Probleme mit Händen

Hände sind bekannt dafür, sich nur schwierig korrekt generieren zu lassen. Oft reicht es, die Finger abzuzählen. Beim KI-generierten Elvis fällt beim genaueren Hinsehen sofort auf, dass seine linke Hand nicht natürlich sein kann.

Die Schwierigkeiten liegen darin, dass die künstliche Intelligenz das Konzept einer Hand – 5 Finger, Daumen an der Seite – nicht kennt. Sie kennt nur die Abbildungen von Millionen Händen in Fotos von Menschen aus einer Datenbank. Und wenn auf diesen Fotos die Hände nicht vollständig zu sehen sind, etwa aufgrund des Blickwinkels, hat für die KI eine Hand womöglich manchmal nur vier Finger oder einen Daumen, der genauso lang wie ein Zeigefinger ist.

Mode-Papst und festgenommener Donald Trump

Der falsche Franziskus verbreitete sich Ende März rasant im Internet. Einen Papst in modischem Daunenmantel hat so noch nie jemand gesehen. Das Foto wurde so natürlich nie gemacht, es entstammt einer Software, die aus Text Bilder generiert. Das Papst-Bild ist verblüffend realistisch und nur bei genauerer Betrachtung sieht man, dass etwa die Halskette unvollständig oder die Brille verformt ist.

Etwa eine Woche zuvor sorgten Bilder von der vermeintlichen Verhaftung Donald Trumps für Aufregung. Wer genau hinsah, merkte jedoch, dass Trumps rechte Hand „verschmiert“ war – ein klassisches Anzeigen für ein KI-generiertes Foto. Das Gesicht Trumps sah für ein KI-generiertes Bild allerdings täuschend echt aus. Experten vermuten, dass das Foto entsprechend von einem Menschen nachbearbeitet wurde.

Ebenfalls Ende März teilte der deutsche AfD-Politiker Norbert Kleinwächter ein Foto voller schreiender Männer, betitelten es mit „Nein zu noch mehr Flüchtlingen“. Das Bild wurde so allerdings nie gemacht, es stammte von der Software Midjourney.

Aus Wörtern wird ein Buchstabensalat

Ein Merkmal, bei dem Bildgeneratoren fast immer danebenliegen, ist Schrift. Auch hier weiß die Software weder, dass einzelne Buchstaben ein Wort ergeben, noch was dieses Wort bedeutet. Bei der Darstellung von Schrift entsteht so oft ein Buchstabensalat, der nichts mit normaler Sprache zu tun hat.

Gesamten Kontext des Bildes beachten

Bildgenerierende Software entwickelt sich mit einer beeindruckenden Geschwindigkeit weiter. In Zukunft könnten Fehler nicht mehr so leicht erkennbar sein. „Fehler werden ausgemerzt“, erklärt Wolf. Deshalb wird der Kontext der Bilder immer wichtiger. „Es ist immer wichtig, in welche Geschichten diese Bilder eingebettet werden“, meint der Faktenchecker weiter.

Wie wahrscheinlich ist es etwa, dass der „King of Rock & Roll“ ein Smartphone dabei hatte? Eine kurze Internetsuche verrät, dass Elvis Presley 1977 gestorben ist. „Von solchen offensichtlichen Falschmeldungen geht keine große Gefahr aus, sie lassen sich leicht widerlegen“, sagt Wolf. Vielleicht mögen sie in einigen WhatsApp- oder Telegram-Gruppen geteilt werden, darüber hinaus schaffen sie es aber nicht.

Besonders schwer zu erkennen sind aber sogenannte Hybridfälschungen. Damit sind Fake News gemeint, in denen zumindest ein kleiner Teil Wahrheit liegt. Als Basis dient dabei meist ein realer Anlass. Am 20. März tauchten etwa Fotos auf, in denen der ehemalige US-Präsident Donald Trump von Polizeibeamten verhaftet wird. Da er tatsächlich zu diesem Zeitpunkt im Fokus der Justiz stand, schien das zumindest plausibel. Die Fälscher*innen nutzten zudem einen Trick: Sie veröffentlichten gleich mehrere Fotos der vermeintlichen Verhaftung. Dadurch wirkte es, als wären etliche Fotograf*innen dabei gewesen.

Vertrauenswürdige Medien nutzen

Wenn man sich nicht sicher ist, ob ein Bild oder Text den Tatsachen entspricht, lohnt es sich, auf vertrauenswürdige Medien zurückzugreifen. Eine einfache Google-Suche reicht bei viralen Bildern oft aus, um einschätzen zu können, ob es sich um ein gefälschtes, oder um ein echtes Bild handelt.

Quelle des Bildes finden

Findet man dennoch nichts dazu, lohnt es sich, der Quelle des Bildes auf den Grund zu gehen. Am einfachsten funktioniert das mit “umgekehrten Bildersuchen”, wie sie etwa in der Google-Bildersuche oder in Google Lens eingebettet sind. Taucht das Foto etwa im Subreddit Midjourney auf, ist die Chance ziemlich hoch, dass es mit dem KI-Bildgenerator Midjourney erstellt wurde.

Wie man die umgekerhte Bildersuche nutzt, könnt ihr hier nachlesen:

Kommentare