Fraunhofer Austria bringt Licht in die "Black Box" Künstlicher Intelligenz

KI-Chatbots scheinen auf alles eine eloquente Antwort geben zu können. Ob diese Antwort dann auch den Tatsachen entspricht, ist eine andere Frage. Sogenannte Large Language Models (LLM), die hinter diesen Chatbots stecken, neigen nämlich nicht selten an Halluzinationen. Sie sehen Verbindungen, wo gar keine sind. Warum diese Verbindungen gezogen werden, ist nicht wirklich klar - LLMs stellen eine “Black Box” für ihre Nutzer dar.

Forscher von Fraunhofer Austria wollen Licht in diese Black Box bringen. Dabei nutzen sie eine Technik, mit der die Antworten in Kombination mit externen Quellen verbessert werden sollen. Bei dieser Retrieval-Augmented Generation (RAG) genannten Technik wird ein LLM beispielsweise mit Dokumenten gefüttert, die spezifisches Wissen liefern. Das können unternehmensinterne Bestelllisten sein, oder Maschinenhandbücher für die Wartung von Produktionsmaschinen.

Wenn ein Problem mit einer Maschine besteht, kann man den Chatbot fragen, worum es sich handeln und wie man es reparieren könnte. “Der Chatbot kann mir dabei auch sagen, dass bestimmte Informationen nicht verfügbar sind”, sagt René Berndt vom Fraunhofer Austria Center für Data Driven Design. Herkömmliche KI-Chatbots neigen in solchen Fällen dazu, einfach Aussagen zu erfinden, die sich richtig anhören.

Aufwändiges Training unnötig

LLMs werden nämlich mit einem gewaltigen Datensatz trainiert, “bei ChatGPT ist der in etwa so groß wie alle Texte in der Nationalbibliothek in Wien”, sagt Berndt. Aus diesen Daten leitet das Modell statistische Zusammenhänge ab, welches Wort wohl am wahrscheinlichsten auf das vorherige folgt. Um neues Wissen zum Modell hinzuzufügen, muss es mit noch mehr Datensätzen gefüttert und trainiert werden, das Modell wird immer größer.

Bei RAG kann man das Wissen ohne neues Training erweitern, indem man einfach entsprechende Dokumente hinzufügt. Zudem muss das verwendete LLM nicht sehr fortgeschritten sein, “ein etwas besserer Laptop reicht aus, um das lokal am Computer zu verwenden”, sagt Berndt. Dadurch ist die Verwendung auch datenschutzrechtlich kein Problem. Zudem wird bei der Technologie die Wahrscheinlichkeit von Halluzinationen deutlich verringert.

Wissensgraphen machen RAG besser

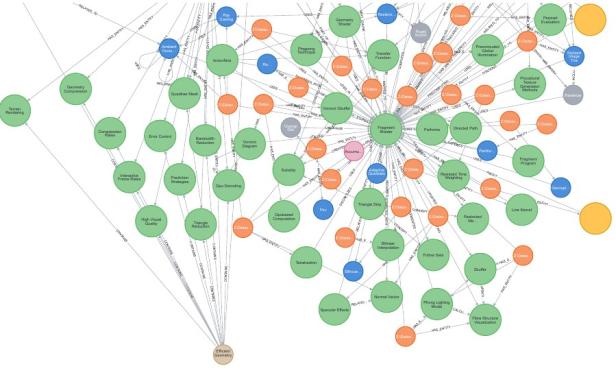

Doch auch durch die RAG-Technik ist der Chatbot nicht davor gefreit, Fehler zu machen. In den Dokumenten könnten etwa selbst Unstimmigkeiten auftreten. Um das zu verhindern, haben die Experten von Fraunhofer Austria Wissensgraphen eingesetzt. Das sind Strukturen, die Zusammenhänge zwischen Informationen graphisch zeigen. So kann zwischen den Punkten “Österreich” und “Christian Stocker” zum Beispiel eine Linie mit der Beschriftung “Bundeskanzler” verlaufen.

Ein Beispiel eines solchen Wissensgraphen.

© Fraunhofer Austria

“Die Black Box wird hier durchsichtig”, sagt Berndt. Und das Spezielle dabei: Die Verbindungen zwischen den einzelnen Punkten lassen sich auch händisch entfernen oder ergänzen. So kann man bei falschen Ausgaben des Chatbots gezielt nachkorrigieren.

Erfolgreiche Pilotphase

In einem Pilot-Projekt, das vom Bundesministerium für Wirtschaft, Energie und Tourismus gefördert wurde, wurde das LLM mit 14.000 Fachartikeln der European Association for Computer Graphics (Eurographics) gefüttert. Mit Erfolg: “Die Kombination mit Wissensgraphen funktioniert besser als ein unassistierter RAG-Algorithmus”, sagt Berndt.

Dennoch ist wichtig, dass auch die Nutzer des Chatbots über entsprechendes Fachwissen verfügen, um eventuelle Fehler ausbessern zu können. In Zukunft ist es denkbar, ein solches Large Language Model auch in anderen Bibliotheken zu implementieren.

Diese Serie erscheint in redaktioneller Unabhängigkeit mit finanzieller Unterstützung des Bundesministeriums für Wirtschaft, Energie und Tourismus.

Kommentare