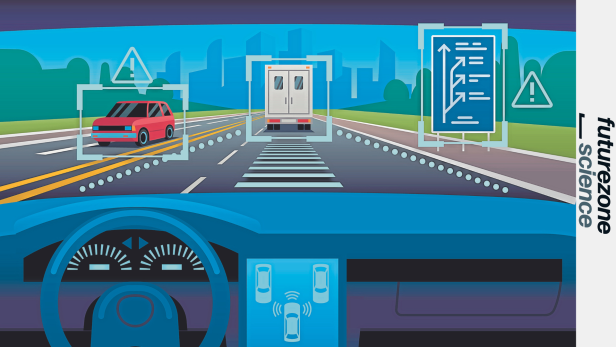

KI-Modelle werden mit Bild- und Videodaten trainiert. So lernt etwa eine Software für autonomes Fahren aus einer Vielzahl an Situationen beim Autofahren. Probleme ergeben sich, wenn etwas passiert, das sie noch nicht kennt. Auch kann eine solche Software nicht argumentieren, warum sie sich auf bestimmte Art und Weise verhalten hat.

Blick in die „Blackbox“: KI soll erklären, was sie tut

Dieser Artikel ist älter als ein Jahr!

Künstliche Intelligenz (KI) wird in Zukunft immer mehr Entscheidungen für und über uns treffen. Oft werden wir diese kaum bemerken – im Alltag werden sie uns unterstützen und entlasten. Diese Entscheidungen können sich allerdings auch stark auf unser Leben auswirken: Etwa wenn ein selbstfahrendes Auto in einer Unfallsituation entscheiden muss, wessen Leben es rettet und wer sterben muss.

Blackbox beeinflusst unsere Leben immer mehr

Auch in weniger dramatischen Situationen kann eine KI Entscheidungen fällen, die unser Leben beeinflussen - wenn sie etwa einen bestimmten Karriereweg empfiehlt oder unsere Kreditfähigkeit überprüft. „Es ist schwierig, die Entscheidungsprozesse von solchen KI-Modellen zu verstehen“, erklärt Francesco Locatello. Oft ist KI für uns Menschen eine Blackbox. Wie sie genau zu einem Ergebnis gekommen ist, ist nicht nachvollziehbar.

➤ Mehr lesen: KI wird 60 Prozent aller Jobs beeinflussen

Locatello forscht seit Dezember 2023 am Institute of Science and Technology Austria (ISTA) in Klosterneuburg daran, wie man KI-Systeme transparenter und besser machen könnte. Zuvor arbeitete der italienische Forscher u. a. bei Google Brain (jetzt Google DeepMind) und Amazon Web Services.

Der gebürtige Italiener Francesco Locatello forscht am ISTA in Klosterneuburg zu "kausaler KI".

© ISTA

Keine Argumente, viel Statistik

Ein neues Gesetz der EU sieht vor, dass KI-basierte Entscheidungen in Zukunft möglichst nachvollziehbar sein sollen. Idealerweise würde uns ein solches Programm erklären, wie eine bestimmte Entscheidung zustande kam. „Wenn ein KI-System eine Entscheidung fällt, erklärt es sehr oft nicht, welcher Prozess zu dieser Entscheidung geführt hat. Etwa, wenn es mir einen Kredit verweigert. Aber ich will den Kredit ja noch immer – wenn es also einen guten Grund dafür geben sollte, warum ich kein guter Kandidat für einen Kredit bin, würde ich den gerne kennen“, erklärt Locatello. „Vielleicht würde ich mich gerne erneut bewerben und etwas dafür tun, dass es das nächste Mal klappt. Wenn diese Anwendungen einem nicht erlauben, die Gründe hinter der Entscheidung zu erfahren, sind sie meiner Ansicht nach nicht gut“, sagt der Computerwissenschafter.

➤ Mehr lesen: Ob wir wollen oder nicht: Künstliche Intelligenz geht uns alle an

Das Problem ist, dass die meisten KI-Modelle das derzeit nicht können. Das liegt an der Art, wie sie zu ihrem „Wissen“ gelangen. KI-Modelle arbeiten mit Korrelationen, die sie in gigantischen Datenmengen aufspüren. So funktioniert etwa ChatGPT. „Dieses Modell wurde womöglich mit dem gesamten Internet trainiert. Auf gewisse Art enthält es schon das komplette Wissen der Menschheit“, erklärt Locatello. Die KI sucht in diesem Informationsschatz dann nach statistischen Zusammenhängen und spuckt als Ergebnis aus, was am wahrscheinlichsten ist.

Alles Statistik?

Korrelation

beschreibt das Verhältnis, wie stark Dinge zusammenhängen. Es gibt z. B. eine statistische Korrelation zwischen Eisessen und Ertrinken. Je mehr Eis gegessen wird (etwa im Sommer), desto mehr Menschen ertrinken.

Kausalität

heißt, dass eine Sache zur anderen führt. Es liegt eine direkte Ursache-Wirkungs-Beziehung vor. Menschen ertrinken, weil sie bei Sommerhitze schwimmen gehen. Eisessen ist allerdings nicht der Grund dafür.

KI kennt keine Strand-Kühe

Schwer tue sie sich hingegen mit Dingen, die sie noch nicht kennt, mit ganz Neuem. „Ein typisches Problem ist, dass ein KI-System bei Bildern wirklich versteht, was in einer dargestellten Szene oder auch in der echten Welt tatsächlich passiert“, erklärt Locatello. Die KI nehme oft nur oberflächliche Muster wahr, die sie beim Analysieren von Information findet.

➤ Mehr lesen: Dürfen KI-Generatoren meine Bilder zum Trainieren verwenden?

Locatello erklärt das anhand mit folgendem Beispiel: Kühe sind auf Fotos sehr häufig zusammen mit Gras abgebildet. Wenn wir Menschen plötzlich eine Kuh am Strand sehen, erkennen wir diese immer noch als Kuh, weil wir wissen, dass diese auch am Stand vorkommen kann. KI-Modellen fehlt derzeit allerdings ein wirkliches Verständnis davon, was eine Kuh eigentlich ist. „Die Folge davon kann sein, dass diese Systeme lernen, dass es Kühe nur auf Gras gibt“, erklärt Locatello.

Typische Darstellung einer Kuh: Das Tier befindet sich auf einer Wiese, ihrem natürlichen Lebensraum. Aus einer Vielzahl solcher Bilder lernt Künstliche Intelligenz was eine Kuh ist.

© Getty Images/iStockphoto/Flying broccoli/iStockphoto

Kausale KI soll schlussfolgern

Bei selbstfahrenden Autos sei es etwa wichtig, dass solche Fehler nicht passieren. Sie müssen „robust“ sein, wie das in der Fachsprache heißt und verstehen, dass Fußgänger im Fasching als Gorilla verkleidet sein können. „Teilweise lässt sich das Problem dadurch beheben, dass man mehr Daten sammelt. Irgendwann hat man der KI dann so ziemlich alles gezeigt, was passieren könnte“, sagt Locatello.

➤ Mehr lesen: Wütender Mob zündet selbstfahrendes Auto an

Das machen viele Expert*innen, die KI-Modelle trainieren. Locatello geht einen anderen Weg. Er forscht an einer Art von KI, die schlussfolgern kann – an einer „kausalen KI“. Dadurch soll die Computer-Intelligenz unserer noch ähnlicher werden. „Sie könnte mir dann mitteilen, warum mein Kredit abgelehnt wurde: Welche Eigenschaften von mir dazu geführt haben, dass ich einen Kredit nicht bekommen habe. Manche kann ich vielleicht nicht beeinflussen, andere vielleicht schon“, sagt er.

© WAS JETZT SCHULE

Kommentare