Roboterpsychologin Martina Mara lehrt an der Johannes Kepler Universität Linz.

“Bitte, liebes ChatGPT”: Warum wir zur KI so höflich sind

Dieser Artikel ist älter als ein Jahr!

Die meisten, die schon einmal einen KI-Chatbot wie ChatGPT, Googles Gemini oder Microsofts Copilot benutzt haben, werden das Verhaltensmuster kennen: Wenn wir der Künstlichen Intelligenz Anweisungen geben (Prompts schreiben) sind wir in den Formulierungen häufig ausgesprochen höflich, sagen “Bitte”, “Danke” und "Entschuldigung" - sprechen also mit einer Maschine wie mit einem Menschen. Und das, obwohl wir wissen, dass wir mit einer Maschine sprechen.

Warum aber ist das so? Könnten wir die Floskeln nicht einfach weglassen und birgt das vermenschlichte Interagieren mit Computerprogrammen vielleicht sogar Gefahren für uns?

Martina Mara, Professorin für Psychologie der Künstlichen Intelligenz und Robotik an der Johannes Kepler Universität Linz (JKU), erklärt das Phänomen und erläutert, wovor wir in Sachen KI auf der Hut sein sollten und welche Sorgen eher unnötig sind.

futurezone: Wieso sind wir so höflich zu ChatGPT?

Martina Mara: Es ist zuerst einmal natürlich, dass, wenn Dialoge, Gespräche und Muster der Mensch-Mensch-Kommunikation ähneln, das Gegenüber also so spricht wie ein Mensch und wir so begrüßt werden wie von einem Menschen, wir auch so reden, wie wir es aus ähnlichen Situationen (von Menschen, Anm.) kennen. Das führt uns direkt zum Thema Anthropomorphismus.

Was bedeutet das?

Es ist grundsätzlich so, dass wir Menschen zum sogenannten Anthropomorphismus neigen. Das ist eine Grundtendenz, die die meisten von uns verbindet. Das heißt, dass wir auch in nicht-menschlichen Objekten und Konzepten - etwa “Das Wetter ist launisch”, “Der Staubsaugerroboter ist müde”, “ChatGPT ignoriert mich” - menschliche Eigenschaften, Motivationen, Gefühlslagen, eigene Wünsche und Persönlichkeit wahrnehmen. Diese Grundtendenz ist bei uns Menschen sehr breit vorhanden und erfolgt ganz automatisch, weil wir das, was in unserer Umwelt passiert, mit einer “sozialen Brille” interpretieren. Wir können kaum anders.

Und das, obwohl wir ja grundsätzlich wissen, dass es sich um Maschinen oder Gegenstände handelt.

Wenn zum Beispiel ein Staubsaugerroboter mit uns im Wohnzimmer herumfährt, interpretieren wir das oft automatisch als “zu uns herkommen” oder “von uns wegfahren” - also immer in Relation zu uns, obwohl das in dem Fall ja vollkommen egal ist. Das ist uns grundsätzlich gegeben. Aber es gibt auch Faktoren - das sehen wir auch in der Forschung - die die Tendenz zum Anthropomorphismus zusätzlich verstärken können.

Welche Dinge wären das?

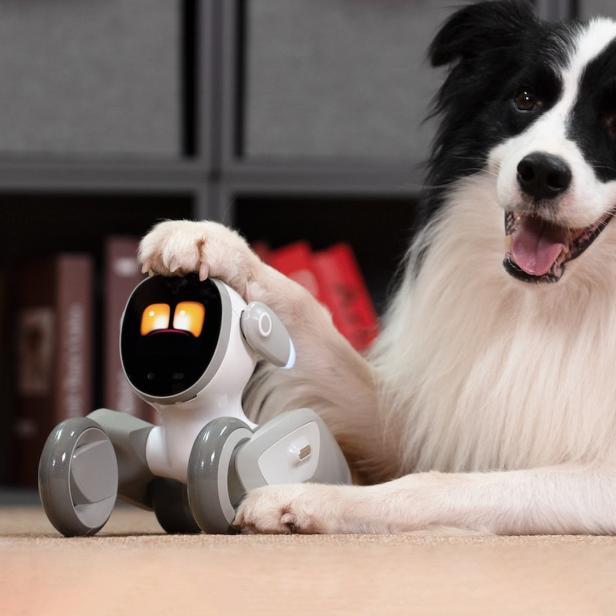

Im Fall von ChatGPT ist das etwa, wie schon angesprochen, der Umstand, dass natürliche Sprache verwendet wird, also das Gegenüber, in dem Fall die Maschine, sehr starke soziale Hinweisreize verwendet. Das ist natürlich auch überhaupt keine Magie, sondern ChatGPT “spricht” so, weil es vorher mit Daten und Texten gefüttert wurde, die Menschen geschrieben haben. Noch stärker wird die Tendenz zum Anthropomorphismus, wenn, wie jetzt ja auch bei vielen Generative-AI-Programmen, menschenähnliche Stimmen hinzukommen. Das erzeugt einen zusätzlichen Trigger. Viele KI-Apps haben sogar zusätzlich eine visuelle Repräsentanz, wo man sich das Aussehen der Künstlichen Intelligenz, mit der man spricht, selbst designen kann. Je menschenähnlicher Designfaktoren im Verhalten, im Sprechen und im Aussehen der Maschine eingesetzt werden, desto stärker wird der Anthropomorphismus zusätzlich angeregt.

Neigen manche Menschen generell stärker dazu als andere, gibt es da Unterschiede?

Was wir auch in der Forschung sehen: Wenn Menschen sich einsamer fühlen, dann geht damit auch häufig ein Bedürfnis nach sozialer Verbundenheit einher. Dann kann es zum Beispiel auch stärker passieren, dass man in einer Maschine ein soziales Gegenüber wahrnimmt. Wir haben den Zusammenhang zwischen Einsamkeit und Anthropomorphismus kürzlich im Ars Electronica Center in Linz mit einem Industrieroboterarm untersucht, der an sich überhaupt nicht menschenähnlich aussieht. Dabei hat sich klar gezeigt, dass Menschen, die angegeben haben, dass sie sich gerade eher einsam fühlen, auch im Roboter ein stärkeres soziales Bedürfnis wahrgenommen haben. Die haben dann öfter Aussagen zugestimmt wie “Der Roboter möchte mit mir in Kontakt treten” oder “Der Roboter hat soziale Bedürfnisse” und haben dann auch häufiger zum Roboter hingegriffen, um Kontakt aufzunehmen. Und letztlich sehen wir auch, dass Menschen, die weniger darüber Bescheid wissen, wie KI funktioniert, ebenfalls stärker zum Anthropomorphismus neigen.

Kann das alles am Ende reale negative Folgen für die Psyche haben? Müssen wir besorgt sein?

Ich sehe schon einige mögliche kritische Konsequenzen - wenn mehrere Punkte zusammenkommen, also man weniger über KI Bescheid weiß und ein höheres Bedürfnis nach Sozialkontakt hat. Dann fällt man sozusagen leichter in diese Simulation hinein. Je weniger Leute über KI wissen, desto stärker vermenschlichen sie ein Large Language Model wie ChatGPT. Und je mehr sie es vermenschlichen, desto eher denken sie auch, dass so eine KI moralische Fürsorge verdient. Infolgedessen landet man vermehrt bei diesen Höflichkeitstendenzen. In einer unserer Studien gaben Menschen, die sich mit KI weniger gut auskannten, zum Beispiel deutlich öfter an, dass ein Language Model Rechte zu seinem eigenen Schutz haben sollte, oder man auf seine “Wünsche” Rücksicht nehmen sollte, etwa, wenn es “sagt”, nicht ausgeschaltet werden zu wollen. Das alles sehe ich kritisch, weil wir doch im Bereich der Menschenrechte noch genug zu tun haben. Da muss man sich nicht um Rechte von Maschinen kümmern.

Sind die Programme denn so gestaltet, dass es einen Einfluss auf die Qualität der Ergebnisse hat, wie höflich man mit ihnen kommuniziert?

Ich kann mir schon vorstellen, dass einen Einfluss hat, weil es der Systematik dieser Programme entsprechen würde, die auf menschlicher Kommunikation basieren und diese erlernt haben. Es würde ja auch der Mensch-zu-Mensch-Logik entsprechen, dass man mehr oder vielleicht sogar bessere Informationen erhält, wenn man höflich fragt. Insofern würde ich das zumindest nicht ausschließen. Ich bin wie gesagt grundsätzlich kein großer Fan von stark vermenschlichten Maschinendesigns – wenn man aber schon den Weg des Anthropomorphismus einschlägt, könnte das “Bitte” und “Danke” aber auch positive Effekte haben.

Inwiefern?

Weil man in der Forschung davon ausgeht, dass die Muster, die wir in der Interaktion mit Maschinen lernen, wiederum Auswirkungen auf unsere Kommunikation mit realen Menschen haben. Aus dieser Perspektive würde ich Höflichsein zur KI nicht ganz ablehnen wollen. Das ist im Nebenaspekt auch ein Thema in Bezug auf Gender-Stereotype, wie man es etwa in der Debatte um weibliche KI-Stimmen kennt.

Das alles hat ja letztlich auch mit Emotionen zu tun. Ist es denn realistisch - das Szenario wird von manchen befürchtet, von anderen vielleicht auch herbeigesehnt - dass Maschinen irgendwann Emotionen haben werden?

Da muss man klar unterscheiden zwischen simulierten Emotionen und echten Emotionen. Simulierte Emotionen, das ist relativ einfach. Dass man einen Roboter lächeln lässt oder grimmig drein schauen, das kann man leicht umsetzen. Man kennt es auch aus Animationsfilmen, die das gut machen, und dass das dann bei uns als Emotion ankommt. Aber, dass ChatGPT oder Kaffeemaschine einmal echte Emotionen haben, das halte ich für Science Fiction. Es ist auch nicht so, dass mich ChatGPT aus eigenem Wunsch oder Antrieb von sich aus “anchattet”. Vor solchen Szenarien müssen wir uns eher keine Sorgen machen.

Vor anderen schon?

Ich sehe schon eine Gefahr. Wirklich relevant und wichtig ist ja die Auswahl des Lern- und Datenfutters für diese KI-Programme. Es ist eine unglaubliche Macht damit verbunden, zu kuratieren, auszusuchen und zu bestimmen, was diese Systeme erlernen. Dass das momentan in den Händen einiger weniger globaler Player liegt, das ist schon Anlass zur Sorge.

Kommentare