Bei der Google-Bildersuche tauchen immer mehr KI-Fotos auf.

Immer mehr KI-Bilder bei Google: So erkennt man sie

Dieser Artikel ist älter als ein Jahr!

Wer im Oktober 2024 auf Google nach Bildern sucht, stößt dabei auf viele Fotos, die von KI generiert wurden. Optisch sind diese immer schwieriger von echten Fotos unterscheidbar.

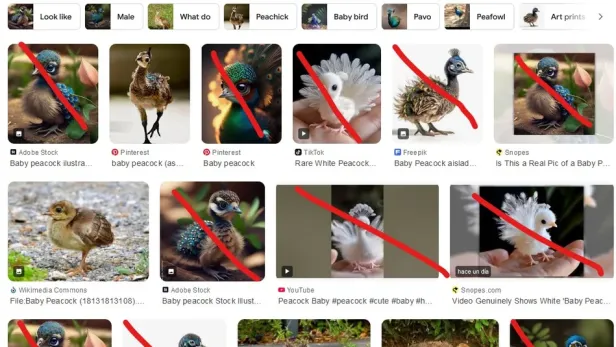

Wie groß die KI-Bilderschwemme mittlerweile ist, zeigt exemplarisch ein auf der Plattform Reddit geposteter Screenshot der Google-Ergebnisseite für „Baby Peacock“ (Babypfau). Zwar ist das Problem seit längerem bekannt, auf Reddit löste der Screenshot nun jedoch eine Massendiskussion aus.

➤ Mehr lesen: 10 kostenlose KI-Bildgeneratoren im Vergleichstest

Reichlich KI-Bilder findet bei Google auch, wer nach dem deutschen Pendant „Babypfau“ sucht. Irgendwie erkennt man zwar, dass an den fotorealistischen Bildern etwas faul ist – zumal es sich bei diesen "Fotos" oft um KI-Produkte handelt, die von älteren Generationen von KI-Bilderstellungssoftware, wie etwa Stable Diffusion oder Midjourney, erstellt wurden. Wer die Ergebnisse schnell überfliegt, bemerkt das aber kaum. Es gibt bereits neuere und bessere KI-Modelle, die Bilder ausspucken, die man mit bloßem Auge nicht mehr von echten Fotos unterscheiden kann.

"Bis vor kurzem waren Bilder eigentlich der ultimative Beweis. Schreiben konnte man vieles, aber wenn man ein Bild zeigen konnte, dann musste es stimmen. Das Bild war früher nur mit hohem technischen Aufwand zu manipulieren. Von dieser Idee sollte man sich verabschieden. Jetzt kann im Grunde jeder Bilder fälschen", sagt Aljoscha Burchardt, Principal Researcher des Deutschen Forschungszentrums für Künstliche Intelligenz.

"Bilder faken ging auch früher schon. Diese Tools sind jetzt sehr einfach zu bedienen. Das Ganze wurde gewissermaßen demokratisiert und durch die technischen Möglichkeiten potenziert", erklärt Marco Huber, Experte für Bild- und Signalverarbeitung beim Fraunhofer-Institut in Stuttgart.

Gefälschte Politikerfotos schüren Misstrauen

Fotos, die für echt gehalten werden, obwohl sie es nicht sind, können ernste Folgen haben. Sie können falsche politische Tatsachen schaffen und für Propaganda missbraucht werden, wenn sie in Massen auf sozialen Netzwerken, wie Facebook oder Telegram, geteilt werden.

Falsche Hurrikan-Opfer

Nachdem der Hurrikan Helene eine Spur der Verwüstung hinterlassen hatte, teilten viele Anhänger der Republikaner ein bestimmtes Foto. Sie behaupteten, es würde zeigen, wie sehr die Biden-Administration bei der Krisenbewältigung versagt hatte. Das herzzerreißende Foto zeigt ein kleines, weinendes Mädchen in einem Boot sitzend, mit einem Welpen in der Hand. Auch dieses Bild ist eine Fälschung.

Auch im Nahostkonflikt machen solche Propaganda-Bilder die Runde. Sogar Geschichtsfälschung wird zu einem immer größeren Problem, wie in letzter Zeit mehrere Medien berichteten. "KI hat einen Tsunami gefälschter Geschichte verursacht, insbesondere im Bereich der Bilder", sagte etwa die niederländische Historikerin Jo Hedwig Teeuwisse kürzlich gegenüber der Nachrichtenagentur AFP.

Betrüger nutzen KI für gefälschte Produkte

KI-Bilder können aber auch Einzelpersonen wirtschaftlich schädigen. Dubiose Websites verkauften z. B. Samen für „Katzenaugenblumen“ und zeigten gleich, wie die fertige Blume aussehen sollte. Es waren aber auch hier KI-generierte Fälschungen. Wer sich von solchen Angeboten täuschen lässt, gibt im besten Fall Geld für ein Produkt aus, das nie ankommt. Im schlimmsten Fall riskiert er, dass seine Kreditkartendaten gestohlen werden.

Die vermeintlichen Katzenaugenblumen.

© Screenshot

Immer weniger sichtbare Hinweise

Mit bloßem Auge ist es schon jetzt teilweise sehr schwierig, KI-generierte Bilder von echten Fotos zu unterscheiden – vor allem, wenn man nicht ganz genau hinschaut. Während bisher oft Details wie Finger, Haarsträhnen oder Schriften im Foto KI-erstellte Bilder preisgaben, beherrschen die KI-Modelle auch solche Details immer besser.

"Natürlich werden die Bilder immer besser. Aber es gibt immer noch Details, die auffällig sind. Finger sind nach wie vor ein gutes Indiz", erklärt Huber vom Fraunhofer-Institut. Als Beispiel nennt er eine KI-Influencerin, die in Deutschland Werbung für Tourismus macht. "Sie ist erst ein paar Tage alt, aber selbst da sieht man: Sie hält einen Kaffeebecher in der Hand und hat dabei nur 3 Finger. Worauf man auch immer sehr gut achten sollte, sind die Augen. Nach wie vor ist es ein Problem, dass die Pupillen nicht ganz rund sind, oder dass Lichtreflexe nicht symmetrisch sind."

Andere Hinweise, die KI-Fotos derzeit entlarven, sind außergewöhnliche oder unnatürliche Details und Texturen, die unrealistisch wirken. Hinweise auf ein KI-Bild können auch unscharfe Bereiche geben und Schatten, die nicht zur Perspektive des Bildes passen. Auch eine Anordnung von Objekten im Bild, die unnatürlich oder seltsam wirkt, kann KI-Produkte verraten.

"Die Technik entwickelt sich rasant weiter. Wie lange diese Tipps noch gelten, hängt davon ab, welche Tools die Leute künftig benutzen", erklärt Burchardt. Für die KI-Bilder von Gratis-Generatoren seien sie immer noch zu einem gewissen Grad gültig. Bei leistungsstärkeren KI-Tools brauche es härtere Geschütze zum Entlarven. Auch Huber rechnet mit einer rasanten Entwicklung: "Man kann davon ausgehen, dass die KI-Werke in den nächsten 12 bis 18 Monaten noch einmal signifikant besser wird", sagt er.

"Wir werden uns kurz- bis mittelfristig darauf einstellen müssen, dass wir mit diesen Tricks Bilder nicht mehr entlarven können werden", so der KI-Experte. Er erwartet zwar, dass KI-Bilder künftig besser gekennzeichnet werden - noch sei es aber nicht so weit. "Jetzt ist die gefährliche Zeit. In 2 Jahren werden wir uns alle dran gewöhnt haben", erklärt Burchardt.

Fake-Detektoren gegen KI-Fotos

Wer seinen Augen und Verstand nicht ganz traut, kann Online-Tools wie Deepware Scanner und Sensity AI zu Hilfe nehmen. Allerdings sind diese Tools oft kostenpflichtig und nicht immer zuverlässig. Ein kostenloses Werkzeug gibt es beispielsweise von Hugging Face.

Auch das deutsche Zentrum für Künstliche Intelligenz entwickelt derzeit ein solches Tool namens News Polycraft, das selbst perfekte Fälschungen erkennen soll. "Wir versuchen auch in perfekten Bildern Muster zu erkennen, die möglicherweise darauf hindeuten, dass sie automatisch generiert sind", erklärt Burchardt. Dieses Tool ist aber in erster Linie für das Erkennen von Fake News gedacht und wird deshalb in Zusammenarbeit mit Medien und Journalisten entwickelt.

Huber hält diese Fake-Detektoren nur für begrenzt geeignet: "Es ist leider wie bei Räuber und Gendarm, wo der Gendarm immer dem Räuber hinterherläuft. Es ist kein gleiches Wettrennen", so der KI-Experte: "Diese Programme können funktionieren, aber es gibt genug Studien, die zeigen, dass sie eigentlich nicht wirklich verlässlich sind."

Kontext, Kontext, Kontext!

Auch wenn gewisse Inhalte - wie raffinierte politische Propaganda - wahrscheinlich auch in Zukunft von Profis überprüft werden müssen, seien gleichzeitig die User zum Nachdenken aufgefordert. Man könne sich etwa fragen, ob ein bestimmtes Bild ein typisches Narrativ bediene: "Etwa: Ein migrantisch aussehender Mann wird abends vor einer Kneipe einer Frau gegenüber übergriffig", so Borchardt.

Dann müsse man sich fragen, ob das Bild auch schon woanders vorgekommen ist. Bei historischen Bildern würde sich eine Rückwärtssuche anbieten: "Man kann bei Google einfach mal gucken, ob man ähnliche Bilder findet, wo möglicherweise die Szene anders dargestellt ist", so der KI-Experte. Dann gelte es, zu überprüfen, wo das Bild herkommt. Hier empfiehlt er zu schauen, ob das auch in seriösen Medien oder im öffentlich rechtlichen Rundfunk aufgegriffen wurde.

Am wichtigsten sei das kurze Innehalten: "Lass dich nicht sofort in die Story reinziehen", sagt Burchardt. Ein Beispiel: "Du findest plötzlich Nacktfotos von Marilyn Monroe und Cary Grant. Dann musst du erstmal kurz durchatmen und überlegen. Eigentlich hätte man das schon wissen müssen und das wäre schon längst bekannt gewesen. Es ist sehr unwahrscheinlich, dass solche Fotos nach 70 Jahren plötzlich auftauchen", so Burchardt.

Google will KI-Inhalte besser kennzeichnen

Auch die Tech-Unternehmen, die für die KI-Tools verantwortlich sind, wollen künftig mehr Verantwortung für diese Bilder übernehmen. Google, Amazon, Microsoft, Adobe, OpenAI und Intel unterstützen etwa die Coalition for Content Provenance and Authenticity - eine Initiative, die Fälschungen und Desinformation mit KI-Inhalten bekämpfen will.

Google will in den kommenden Monaten seine Suchergebnisse besser kennzeichnen und die User wissen lassen, woher ein Bild kommt. In einem ersten Schritt will das Unternehmen in seiner Galerie-App Google Fotos einen Hinweis einblenden, wenn ein Bild mit einer KI von Google bearbeitet wurde. Außerdem soll ein eigener „AI Info“-Bereich in den Bild-Details angezeigt werden.

Bis wir überall vor KI-Darstellungen gewarnt werden, dürfte es allerdings noch dauern. Am wichtigsten ist es daher, den eigenen Kopf zu gebrauchen.

Kommentare