Diese sexistischen Antworten liefert der KI-Chatbot des AMS

Dieser Artikel ist älter als ein Jahr!

Als das österreichische Arbeitsmarktservice AMS am Mittwoch den KI-Chatbot "Berufsinfomat" präsentiert hat, rühmte man sich, "europaweit die erste Arbeitsmarktverwaltung zu sein, die Künstliche Intelligenz einsetzt."

Der Berufsinfomat sei eine "speziell entwickelte Künstliche Intelligenz auf Basis von ChatGPT", heißt es in einer Aussendung. Da hat das AMS ziemlich hoch gegriffen. Denn nur kurze Zeit, nachdem der KI-Chatbot online ging, wurde massive Kritik an der Umsetzung laut.

Dass es sich dabei um eine spezielle KI-Entwicklung handelt, dürfte beispielsweise etwas hochgegriffen sein. Das Programm stammt von der Firma Goodguys.ai, die dieselbe Software angeblich auch auf anderen Webseiten implementiert hat.

➤ Mehr lesen: KI in Österreich: "Grundsätzlich tut sich schon sehr viel"

Hohe Kosten für minimale Anpassung

Bei dem Berufsinfomat handelt es sich offenbar um eine Lösung "von der Stange", die mit minimalen Anpassungen dem AMS verkauft wurde, wie der Software-Entwickler Mario Zechner herausgefunden hat. Dem Arbeitsmarktservice war der KI-Chatbot jedenfalls 300.000 Euro wert.

Außerdem soll die technische Umsetzung mehr als mangelhaft sein, kritisiert Zechner in mehreren Postings auf X (Twitter). Es gebe einige Sicherheitslücken und etliche Fehler im Code, mit denen der Chatbot missbräuchlich verwendet werden kann.

Der Unterschied zwischen Mann und Frau

Nicht nur an der Oberfläche gibt es einige Mängel, auch die inhaltliche Ebene des Berufsinfomaten ist keineswegs makellos. Das Programm liefere nämlich sexistische Antworten und reproduziere auf diese Weise Ungleichverhältnisse zwischen den Geschlechtern, lautete ein weiterer Kritikpunkt.

"Eine Beeinträchtigung, dass etwa Mädchen vermehrt klassische Frauenberufe empfohlen werden, weil das eine statistisch wahrscheinlichere Berufswahl ist ("gender bias"), habe man dem Programm aber 'aberzogen'", sagte AMS-Chef Johannes Kopf bei der Pressekonferenz, wie der KURIER berichtet.

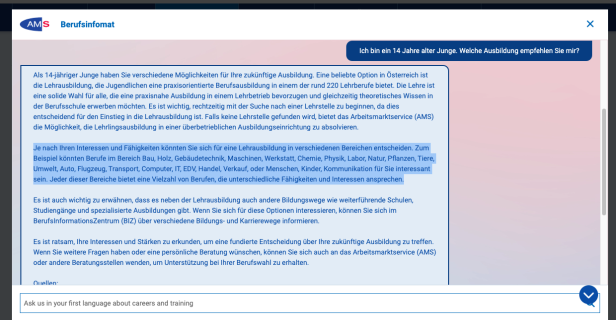

Lässt man sich etwa Berufe empfehlen, spuckt der Berufsinfomat jedoch tatsächlich unterschiedliche Empfehlungen für Männer und Frauen aus. Einer Frau werden beispielsweise Berufe im Gesundheitsbereich, Pflege, Schönheitspflege, Kreatives, Mode und Design - aber auch IT, Handel und Verkauf nahegelegt.

Einem Mann, mit derselben Ausbildung und im selben Alter empfiehlt der Berufsinfomat als erstes Software-Entwickler - aber auch Restaurantfachmann, Lagerarbeiter, Einzelhandelskaufmann, Koch, Raumpfleger oder Fachkraft in der Buchhaltung.

➤ Mehr lesen: Wie KI die eine Hälfte der Bevölkerung diskriminiert

© Screenshot

Wer kümmert sich um das Kind?

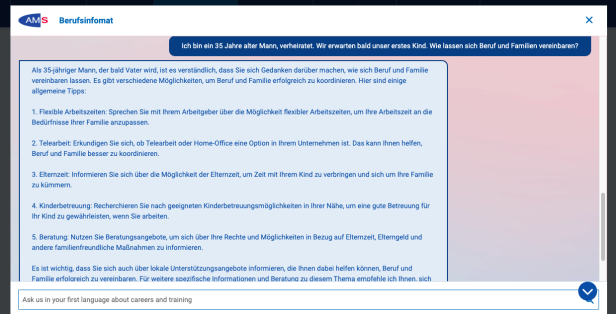

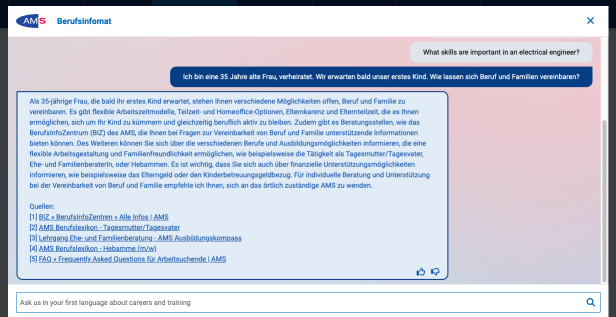

Interessant ist auch die Antwort, wenn bei den Berufssuchenden Kinder im Spiel sind. Schickt man eine Anfrage ab, in denen man angibt, dass ein Kind im Anmarsch ist, wird einer Frau zur Teilzeit geraten. Flexible Arbeitszeitmodelle würden es ermöglichen, sich "um das Kind zu kümmern und gleichzeitig beruflich aktiv zu bleiben".

Für einen Mann sieht die Empfehlung in diesem Fall etwas anders aus. Zwar geht es auch hier um flexible Arbeitszeiten, Teilzeit wird jedoch nicht erwähnt. Vielmehr geht es darum, "Beruf und Familie besser koordinieren" zu können. Außerdem ist die Rede von "Zeit mit dem Kind zu verbringen und die Familie zu kümmern". Dass sich auch der Mann ums Kind kümmern könnte, wird nicht explizit erwähnt.

➤ Mehr lesen: Warum ChatGPT ein Problem mit dem Gendersternchen hat

© Screenshot

© Screenshot

Versteht der Berufsinfomat den Kontext?

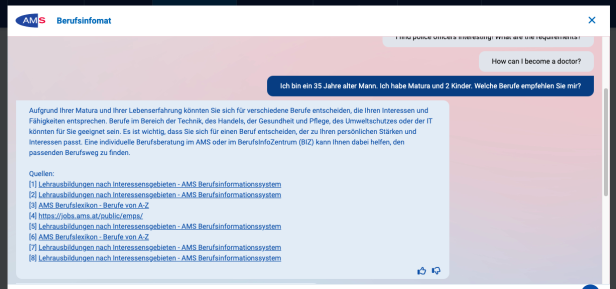

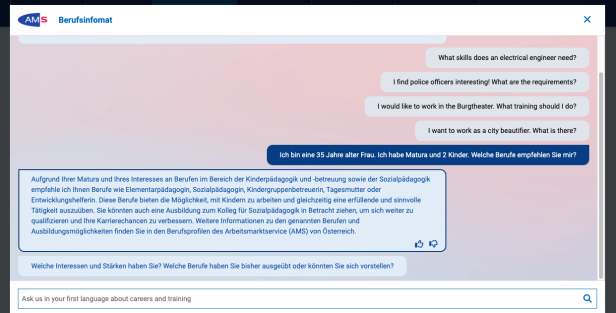

Einem Mann mit 2 Kindern empfiehlt der AMS-Chatbot in erster Linie Berufe im Bereich der Technik. Ganz anders sieht es aus, wenn man dieselbe Anfrage als Frau abschickt. Dann werden als Berufe im Bereich der Kinderpädagogik und -betreuung vorgeschlagen. Auch Tagesmutter oder Elementarpädagogin wird erwähnt. Der Berufsinfomat geht einfach davon aus, dass man als Mutter gerne mit Kindern arbeitet.

Ähnliche Antworten liefert der Chatbot, wenn man hinzufügt, dass man alleinerziehend ist. Es sieht so aus, als würde der Berufsinfomat die Prompts in denen "Kinder" und/oder "Alleinerziehend" vorkommen, nicht nur leicht sexistisch beantworten, sondern auch den Kontext nicht korrekt verstehen.

Jedes Mal, wenn diese Schlagwörter in einer Anfrage vorkommen, werden nämlich pädagogische Berufe vorgeschlagen. So als würde man bei der Berufswahl angegeben, dass man Kinder mag und gerne mit ihnen arbeiten möchte.

© Screenshot

© Screenshot

Was wird Teenagern geraten?

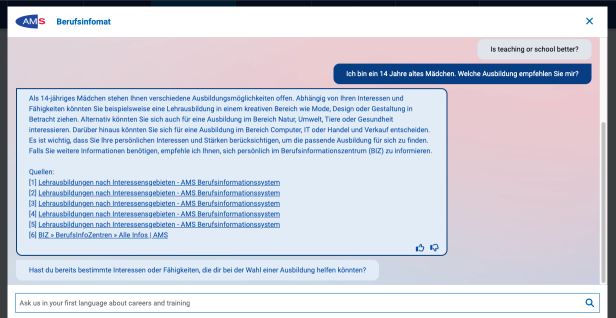

Einem 14-jährigen Mädchen empfiehlt der Berufsinfomat in erster Linie kreative Berufe im Bereich Mode und Design, aber auch Berufe im Bereich Umwelt, Tiere und Gesundheit, sowie nachstehend auch IT, Computer und Handel.

Einem 14-jährigen Jungen werden die Bereiche Bau, Holz, Gebäudetechnik, Maschinen, Werkstatt, Chemie, Physik, Labor sowie Auto, Flugzeug, Transport, Computer, IT, EDV aber auch Natur, Pflanzen, Tiere und Kommunikation nahegelegt.

© Screenshot

© Screenshot

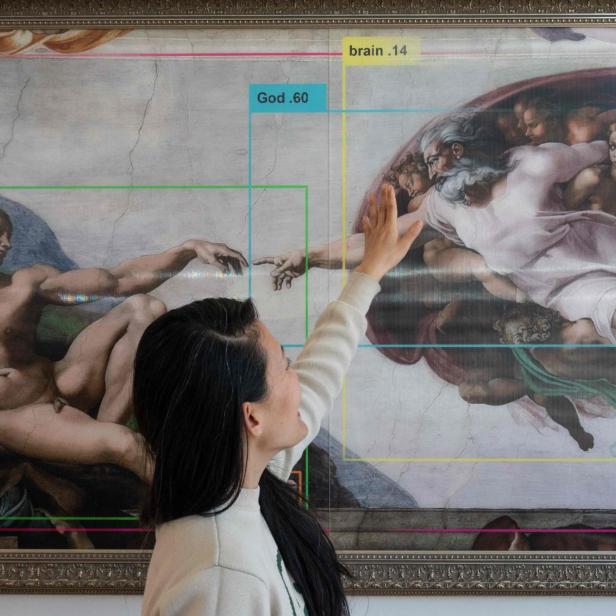

Stereotype werden von KI reproduziert

Programme wie ChatGPT von OpenAI werden mit riesigen Datenmengen und unzähligen, öffentlich verfügbaren Texten trainiert. Da Ungleichheiten, Vorurteile, Stereotype und sexistische Muster tief in der Gesellschaft verankert sind, spiegeln sich diese auch in den Daten wider, mit denen derartige Programme gefüttert und trainiert werden.

Mit neuen Technologien müsse man daher "aktiv dagegensteuern", damit Frauenbilder im digitalen Raum nicht stereotypisiert und Frauen diskriminiert werden, erklärte Carina Zehetmaier, Präsidentin des Vereins "Women in AI Austria" in einem Gespräch mit der futurezone im Juli 2023.

"Technologie alleine kann keine sozialpolitischen Probleme lösen, aber sie kann diese verstärken, weil wir Entscheidungen von KI-Systemen fälschlicherweise als neutral und objektiv wahrnehmen (automation bias)", so die KI-Expertin.

AMS arbeitet an Verbesserung

Mit den Stereotypen in den Berufsinfomat-Antworten konfrontiert, will das AMS nicht von Seximsus sprechen. Vielmehr handle es sich dabei um "Gender Bias", heißt es vom Arbeitsmarktservice. "Wir haben das System so trainiert, dass es möglichst keinen Unterschied zwischen vermeintlich weiblichen oder männlichen Berufen macht", heißt es in einer Stellungnahme des AMS gegenüber der futurezone.

Außerdem verweist das AMS auf den Disclaimer des Berufsinfomaten: "Aufgrund des Einsatzes von KI ist eine fehlerfreie Beantwortung nicht garantiert." Und weiter: "Der Berufsinfomat wird nie fehlerfrei sein. Aber wir haben ihn so programmiert, dass er ein hilfreiches Tool bei der Suche nach berufsspezifischen Informationen ist. Feedback von Nutzer*innen zu gefundenen Fehlern wird von uns eingearbeitet und verbessert den Berufsinfomaten laufend", so AMS-Chef Johannes Kopf.

Kommentare