Apple baut Inhaltswarnungen in iOS 18 ein

Überarbeiteter Kinderschutz: iPhone erkennt automatisch Nacktbilder

Dieser Artikel ist älter als ein Jahr!

Apple macht einen ersten Schritt zur Umsetzung seiner geplanten "Kommunikationssicherheit" für Kinder. Mit iOS 18.2 sollen Nacktbilder automatisch ausgeblendet oder geblurred werden, heißt es auf der Supportseite.

Dafür wird Machine Learning genutzt. Das wird direkt auf iPhone, iPad, Mac oder der Apple Watch verarbeitet. Wird ein Nacktbild oder ein entsprechendes Video erkannt, wird es unkenntlich gemacht. Dabei werden Apps wie Messages, AirDrop, Kontakte und FaceTime-Video-Nachrichten geprüft.

➤ Mehr lesen: 10 versteckte iOS-18-Funktionen, die Apple nicht erwähnt hat

Nacktbilder werden automatisch erkannt uns ausgeblendet

© Apple

Warnungen erklären Situation und bieten Hilfe

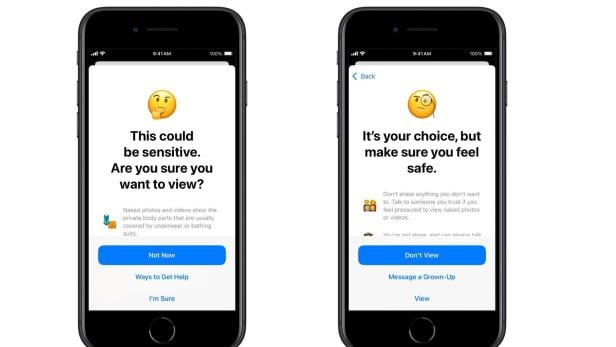

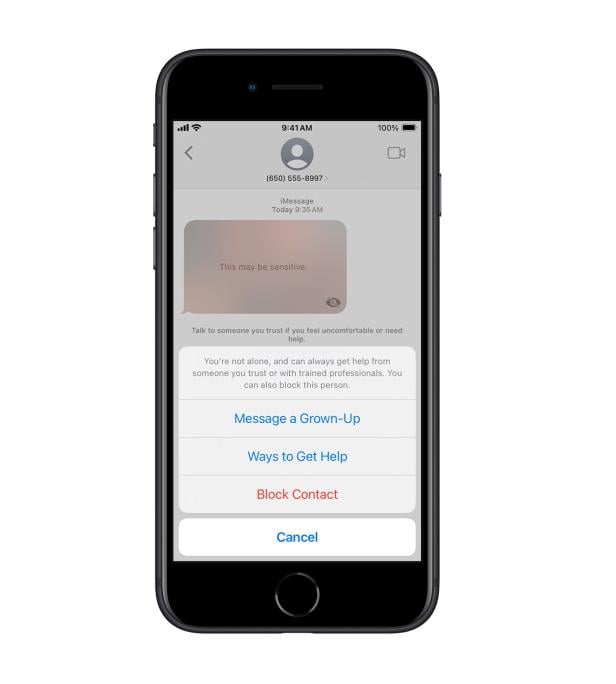

Will ein Kind ein Nacktbild oder -video ansehen, etwa in der Foto-App, erscheint eine entsprechende Warnung. Auch wenn ein Kind versucht, sensitive Inhalte zu teilen - auch bei Drittanbieter-Apps - wird eine Warnung angezeigt. Darin klärt Apple auch auf, warum die Inhalte problematisch sein könnten.

Die Kinder können jeweils eine Nachricht an Erwachsene senden und erfahren, wie sie Hilfe bekommen, wenn sie sich unwohl fühlen. Das Kind wird auch ermutig, dass es in Ordnung ist, wenn sie die Inhalte nicht sehen wollen oder eine Konversation verlassen wollen.

➤ Mehr lesen: iOS 18 ist da: Diese neuen iPhone-Features solltet ihr euch ansehen

Wenn Kinder unter 13 sensible Inhalte ansehen oder versenden wollen, ist die Eingabe des Screen-Time-Passcodes nötig. Dadurch soll sichergestellt werden, dass Erwachsene sehen, was die Kinder teilen bzw. ansehen.

Funktionen kommen erst nach Australien

Die neuen Funktionen werden zunächst bei iOS 18, iPadOS 18, macOS Sequoia und visionOS 2 eingeführt. Zuerst werden die neuen Funktionen in Australien ausgerollt, sollen aber nach und nach in weiteren Regionen verfügbar sein.

Neue Kinderschutzgesetze in Australien sehen vor, dass große Techfimen u.a. Kindesmissbrauch nachgehen. Das gilt allerdings nur, wenn es "technisch machbar" ist, um weiterhin Ende-zu-Ende-Verschlüsselung zu garantieren, schreibt The Guardian.

➤ Mehr lesen: Apple will nicht mehr Fotos der User scannen, um Kinderpornos zu finden

2022 hatte Apple versucht, iCloud-Inhalte stärker auf Fotos und Videos, die sexualisierten Kindesmissbrauch zeigen, zu scannen. Aufgrund von Einwänden in Bezug auf Privatsphäre verwarf Apple diese Pläne wieder.

Kommentare