KI-Chatbots laufen mittlerweile auch schon rein am Handy.

Die besten lokalen KI-Chatbots für iOS und Android

Nicht erst seit dem Hype um DeepSeek wird das Thema Privatsphäre rund um KI-Chatbots diskutiert. Während viele Nutzerinnen und Nutzer den Anbietern blind vertrauen, können andere nur schwer mit der Datenverarbeitung leben.

Neben der Privatsphäre sind auch Zensur, Kosten und Offline-Verfügbarkeit ein Thema, das viele Chatbots mit sich herumschleppen. Dank einer großen Auswahl an frei verfügbaren Large-Language-Models (LLM) ist das eigenständige Betreiben eines privaten Chatbots in Kombination mit lokalen KI-Apps ein regelrechtes Kinderspiel.

Wir stellen euch diese lokalen AI-Apps vor:

- Fullmoon: iOS

- Private LLM: iOS

- Private AI: Android

- PocketPal: iOS und Android

- Apollo AI: iOS

Lokale AI-Apps in Bildern

8 Bilder

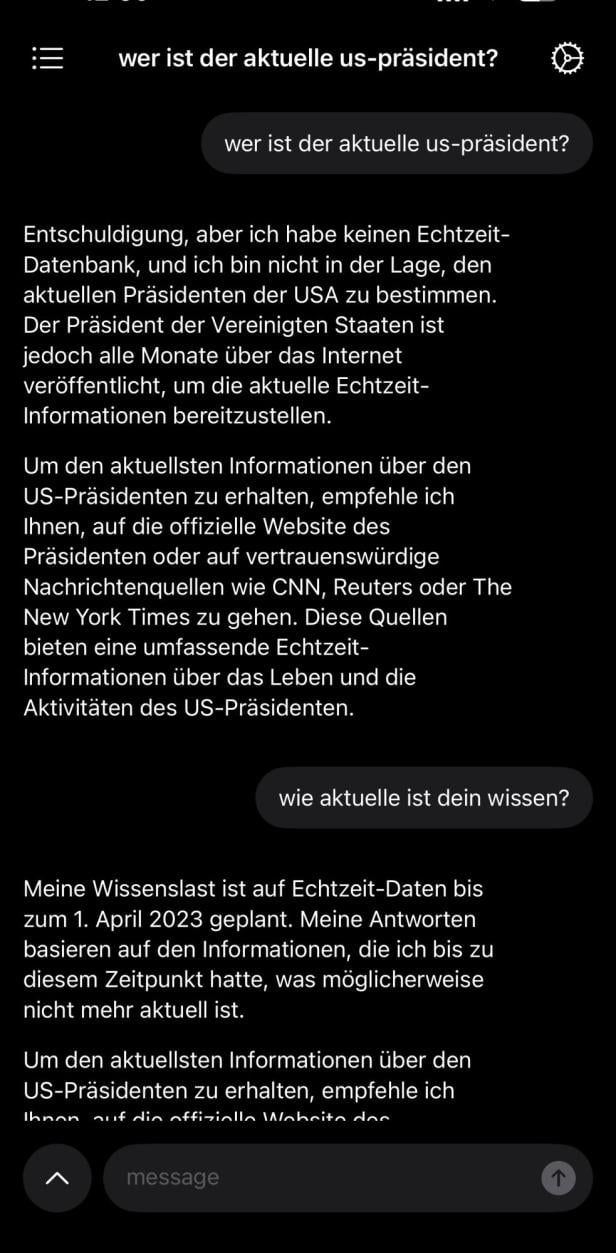

Fullmoon

Schnell und ohne viel Schnickschnack versorgt uns Fullmoon mit der Möglichkeit, einen privaten und lokalen Chatbot zu nutzen. Die kostenlose und quelloffene Anwendung kommt nach dem ersten Start direkt zum Punkt und fragt uns nach dem gewünschten Modell, das wir einsetzen möchten. Das kleinste Modell, Llama-3.2-1b, bringt knapp 800 Megabyte auf die Waage, Deepseek-R1-distill-qwen-1.5 als größtes Modell fast 2 Gigabyte.

Daneben stehen uns außerdem die 4B-Variante von Deepseek R1 und 3B-Variante von Llama-3.2 zur Verfügung. Nach dem Download unseres gewünschten Modells können wir direkt loslegen. Die Wahl der Sprache bringt je nach Modell Antworten unterschiedlicher Qualität, grundsätzlich ist Deutsch aber kein Problem. Die Aktualität der Informationen ist beim kleinsten Modell aber beispielsweise auf April 2023 beschränkt.

Fullmoon erlaubt uns, mehrere Threads anzulegen und diese beliebig fortzusetzen. In den Einstellungen können wir neben haptischem Feedback und der Optik auch den System-Prompt für unseren Chatbot einstellen. Standardmäßig ist dieser auf „sei ein hilfreicher Assistent“ gesetzt.

Fullmoon ist kostenlos für iOS erhältlich.

Private LLM

Die wohl größte Auswahl an lokalen Modellen hat Private LLM zu bieten. Starten wir die App zum ersten Mal, haben wir mehr als 60 Modelle zur Auswahl. Darunter etwa Llama 2 und 3.1, Phi-2 3B oder seit neuestem Modelle auf Basis von Deepseek R1 Distill. Die Modelle variieren dabei stark im Umfang, wobei die kleinsten bei knapp einem Gigabyte liegen.

Haben wir uns für ein Modell entschieden und den Download abgeschlossen, kann das Chatten bereits beginnen. Auch bei Private LLM kann grundsätzlich mit verschiedenen Sprachen gearbeitet werden. Wie gut das funktioniert ist aber auch hier, genauso wie die Aktualität des Wissens, vom gewählten Modell abhängig. Während einige Modelle neben Englisch auch Deutsch verstehen, sind andere nur auf Chinesisch und Englisch eingestellt.

Haben wir mehrere Modelle installierte, können wir direkt im Chat-Fenster das Modell wechseln, um unterschiedlichen Input einzuholen.

Private LLM ist um 5,99 Euro für iOS erhältlich.

Private AI

Auch bei Private AI haben wir dir Möglichkeit, unterschiedliche Modelle lokal einzusetzen. Beim ersten Start der App lädt Private AI automatisch das Modell Gemma 2 2B herunter, durch Tippen auf das „Switch“ können wir aber ganz bequem zwischen den angebotenen Modellen wechseln. Zur Auswahl stehen hier knapp 25 Modelle, die zwischen 0,8 und 8 Gigabyte groß sind.

Darunter Llama 3.2 1B, Qwen 2.5 7B, Mistral 7B oder Orca Mini V3 7B. Außerdem können wir eigene GGUF-Dateien einspeisen, um zusätzliche Modelle nachzuladen. Möchten wir mit dem Chatbot plaudern, müssen wir zuerst einen System-Prompt hinterlegen. In Private AI wird dies als „Act as“ bezeichnet, also wie die KI agieren soll.

Nach Auswahl dieses Prompts kann dann der eigentliche Chat losgehen. Sprache, Detailgrad und Wissensstand sind auch hier abhängig vom gewählten Modell. Möchten wir, dass Private AI in einer bestimmten Sprache antwortet, sollten wir das bereits im System-Prompt festlegen oder müssen sonst während des Chats explizit nachfragen.

In Sachen Einstellungen ist die App sonst recht zurückhaltend. Chats können nicht gespeichert bzw. wiederhergestellt werden. Während in der kostenlosen Version einige kleinere Modelle enthalten sind, kann der gesamte Umfang per In-App-Kauf um 10,99 Euro freigeschaltet werden.

Private AI ist kostenlos für Android erhältlich.

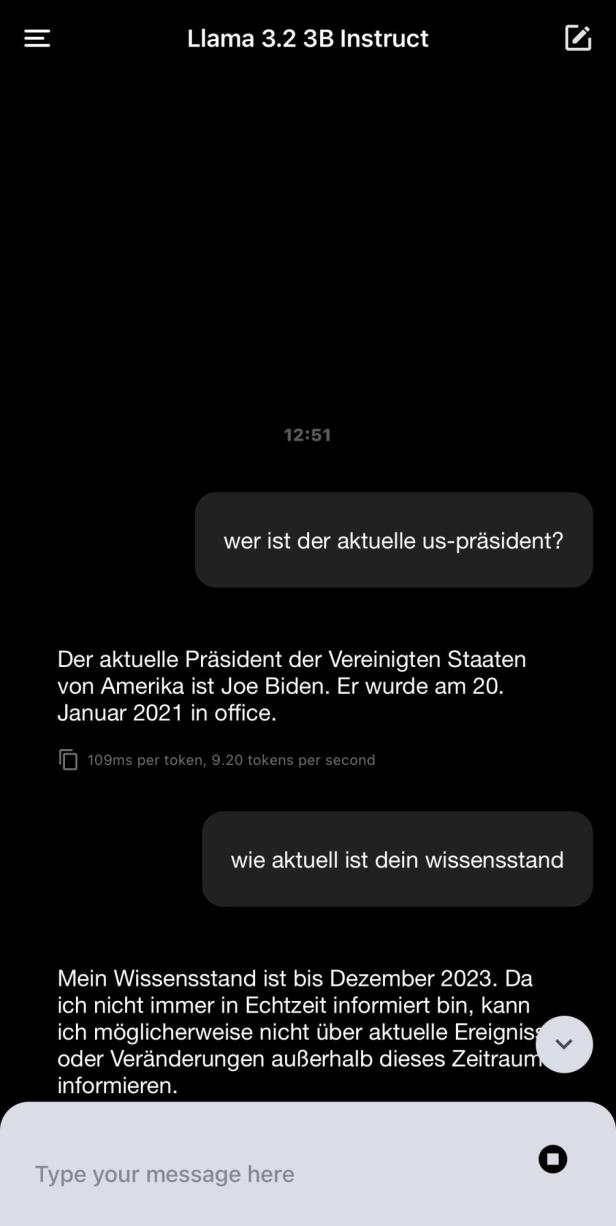

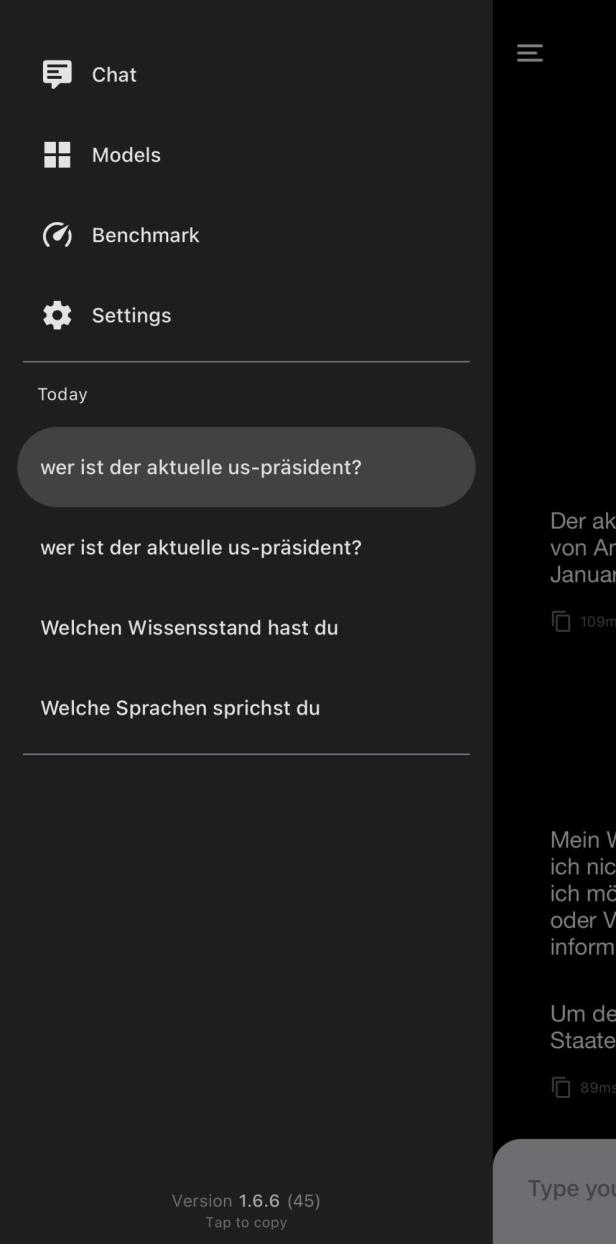

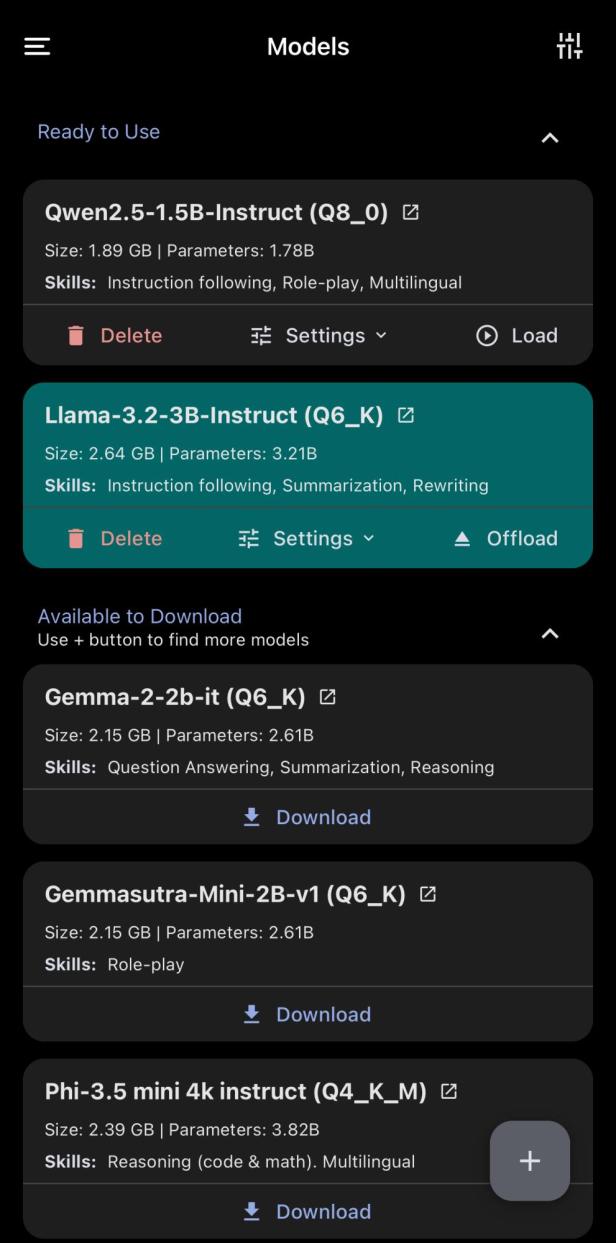

PocketPal

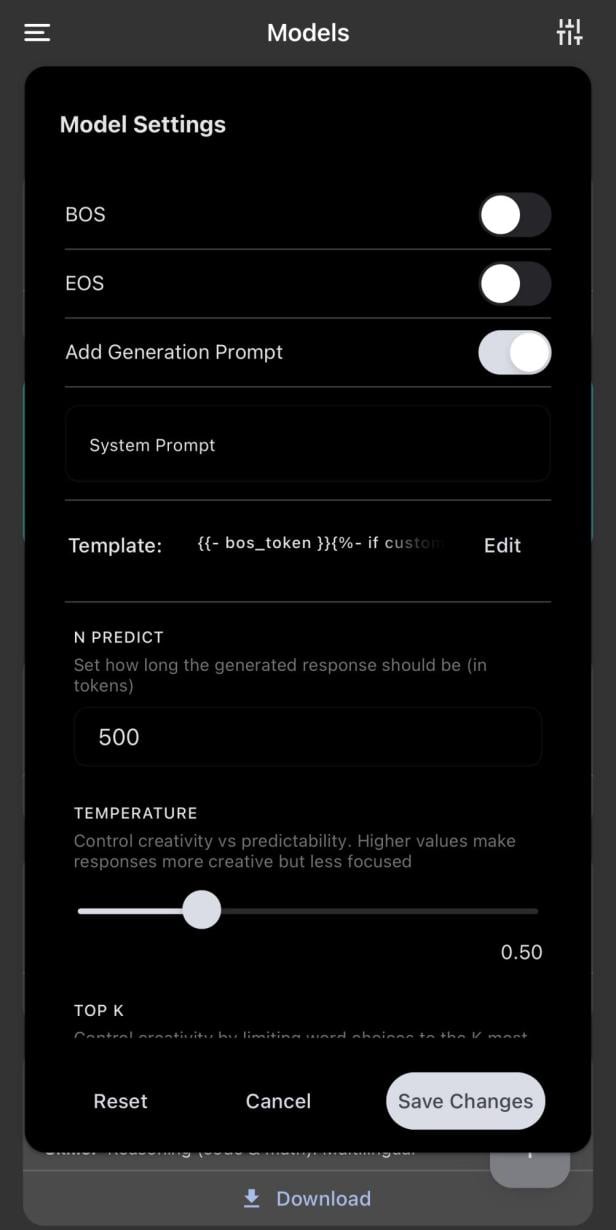

Eine der wohl beeindruckendsten Local-KI-Apps ist PocketPal. Die quelloffene Anwendung bietet umfangreiche Möglichkeiten, von der Auswahl des Modells bis zum Fine-Tuning. Starten wir mit PocketPal, gilt es zuallererst Modelle herunterzuladen. Standardmäßig stehen hier acht Modelle zum Download bereit, darunter Gemma 2 2b, Phi-3.5 mini und Llama 3.2-1b.

Für all jene, die mit den Modellnamen nichts anfangen können, zeigt PocketPal Schlagworte zu den Fähigkeiten der einzelnen Modelle, etwa „Zusammenfassung“, „Role-Play“ oder „Mehrsprachig“. Möchten wir noch mehr Auswahl, können obendrein Modelle von der Webseite HuggingFace und auch per lokaler Datei hinzugefügt werden. Haben wir ein Modell heruntergeladenen und gewählt, können wir uns noch in die Modelleinstellungen stürzen. Neben einem gewünschten System-Prompt gibt es hier viele Zusatzoptionen, die vor allem für Profis interessant sind.

Über den Reiter „Chat“ können wir dann mit dem gerade geladenen Modell plaudern. Sämtliche Chats mit PocketPal werden gespeichert und können jederzeit fortgesetzt werden. Neben den individuellen Modelleinstellungen können wir außerdem App-weite Settings anpassen. Darunter etwa die Kontext-Größe, die GPU-Last und die Nutzung von Hardwarebeschleunigern wie Apple Metal.

Apollo AI

Einen Mix aus privater und lokaler AI erhalten wir bei Apollo AI. Die App hat sich auf die Anbindung von möglichst vielen Modellen spezialisiert, während die Privatsphäre im Vordergrund steht. Möchten wir mit Apollo AI durchstarten, haben wir mehrere Möglichkeiten. Wer ein eigenes LLM zu Hause, etwa auf einem Server oder PC betreibt, kann sich per Apollo AI mit diesem verbinden.

Zudem wird die Nutzung von OpenRouter unterstützt, einer Plattform, die Zugriff auf zahlreiche Modelle bietet. Option Nummer 3 ist die Nutzung von lokalen Modellen, die Apollo AI seit einigen Wochen vermehrt hinzufügt. Genutzt werden können hier Varianten von Qwen, Phi oder auch Llama, wobei die Modelle und ihr Umfang derzeit laufend aktualisiert werden.

Haben wir eines der Modelle geladen, können wir direkt mit dem Chat beginnen. Während Apollo AI einen System-Prompt nutzt, können wir diesen auf Wunsch anpassen. Prompt und Modell lassen sich obendrein pro Chat festlegen und können jederzeit durch Tippen auf den Titel verändert werden. Hat ein Chat besonderen Wert für uns, können wir diesen zudem exportieren.

Apollo AI ist um 6,99 Euro für iOS erhältlich.

Kommentare