Riesen-Hype um DeepSeek: Was steckt dahinter?

Fragt man DeepSeek selbst, was es so besonders macht, erzählt es von ausgewogenen Antworten, Kontextverständnis und natürlicher Sprachverarbeitung. Von anderen KI-Modellen hebe es sich ab, weil es aktuell, multifunktional und vertrauenswürdig sei. Nach der großen Revolution klingt das eigentlich nicht und trotzdem stellt das KI-Sprachmodell aus China gerade die gesamte Tech-Industrie auf den Kopf. Warum?

In den letzten Jahren hat sich die US-Techbranche zu einer Wohlfühl-Oase des KI-Hypes entwickelt. ChatGPT von OpenAI, Gemini von Google und LLaMA von Meta machten das Wettrennen um die Vorherrschaft unter sich aus. Die Nachrichten über neue Rechenzentren von der Größe Manhattans, Milliardeninvestitionen und dem Bau von Atomkraftwerken eigens zum Zweck, den wachsenden Strombedarf durch KI zu decken, wurden in kürzester Zeit Normalität.

➤ Mehr lesen: Stargate: USA wollen 500 Milliarden Dollar in KI-Projekt stecken

Nvidia verliert 600 Milliarden Dollar

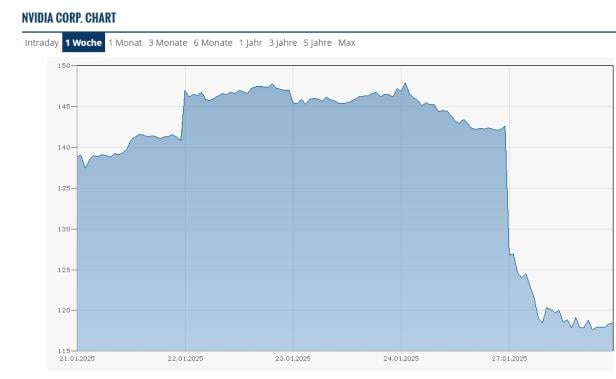

Kein Wunder also, dass das plötzliche Auftauchen der Konkurrenz aus China Chaos auslöste. Nvidia, dessen Grafikkarten viele KI-Modelle trainieren, verlor an der Börse über Nacht fast 600 Milliarden Dollar (575,9 Milliarden Euro). Das ist ein Verlust von 17 Prozent für das zuvor wertvollste Unternehmen der Welt. Siemens Energy sackte gleich um 20 Prozent ab. Auch Oracle, Microsoft und AMD verzeichneten Verluste.

Die Nvidia-Aktie stürzte ab

© Finanzen.at Screenshot

➤ Mehr lesen: Microsoft und OpenAI bauen KI-Rechenzentrum für 100 Milliarden Dollar

Der Grund für diese Reaktion ist, dass DeepSeek behauptet, mit einem Bruchteil des finanziellen Aufwands und geringerer Rechenleistung ein vergleichbares Ergebnis zu erzielen wie die teure Konkurrenz. Eigene Angaben zufolge wurden gerade einmal 5,4 Millionen Euro investiert, während die Konkurrenz Hunderte Milliarden für das Training ihrer Modelle ausgibt.

Weniger GPUs, weniger Parameter, weniger Stromverbrauch

Trainiert wurde DeepSeek laut eigenen Angaben mit 2.048 H800-GPUs von Nvidia, insgesamt 10.000 GPUs zur Verfügung gestanden haben. Schätzungen gehen davon aus, dass es bei GPT-4 10.000 bis 25.000 GPUs waren. Laut Elon Musk wurde seine Grok-KI mit 100.000 GPUs trainiert und die Zahl soll für das nächste Modell noch verdoppelt werden.

➤ Mehr lesen: Elon Musk will X-Chatbot mit eigenem Supercomputer verbessern

Laut Github verwendet DeepSeek V3 671 Milliarden Parameter. Gemini verwendet Hunderte Milliarden und GPT-4 über eine Milliarde Parameter. Mehr Parameter bedeuten auch mehr Datenverarbeitung und damit einen höheren Energieverbrauch.

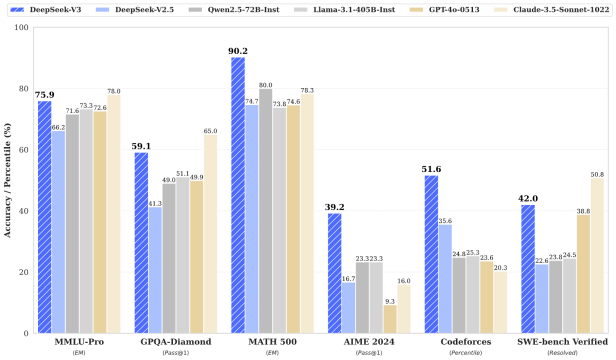

DeepSeek schlägt im eigenen Benchmark-Test die Konkurrenz

© Github / DeepSeek

Das klingt nach keinem so großen Unterschied, der Ansatz von DeepSeek sieht aber eine sogenannte Mixture-of-Experts (MoE)-Architektur vor. Das bedeutet, je nach Prompt werden „Experten“ aktiv, die die spezifische Anfrage bearbeiten. Dadurch wird immer nur eine Teilmenge der Parameter aktiviert, genauer 37 Milliarden pro Token. Vereinfacht kann man sagen, dass ein Token hier einem Wort in einem Prompt entspricht.

Laut DeepSeek werden für ihr aktuelles Modell V3 schätzungsweise weniger als eine Gigawattstunde Strom benötigt, während es bei den anderen mehrere GWh sind. Für den CO2-Fußabdruck heißt das, für das Training produzieren die US-Modelle Hunderte Tonnen CO2 und DeepSeek weniger als eine Tonne.

Die Firma hinter DeepSeek

DeepSeek wurde vom Chinesen Liang WenFeng gegründet, über den aber nur wenig bekannt ist. Er gründete 2015 zusammen mit Xu Jin den Hedge Fonds High Flyer. 2019 gründete er High Flyer AI, 2023 rief er schließlich das Start-up DeepSeek ins Leben. Der Firmensitz ist in Hangzhou, südwestlich von Shanghai.

Meta richtet "War Rooms" ein

MoE ist dabei keine Erfindung von DeepSeek, auch Gemini und ChatGPT nutzen das. Inwiefern DeepSeek das Prinzip aber besser umsetzt als die anderen, ist jetzt Gegenstand der Diskussionen. Die Aufregung hat einem Bericht von The Information zufolge sogar schon dafür gesorgt, dass Meta ganze 4 „War Rooms“ eingerichtet hat, um möglichst schnell auf DeepSeek zu reagieren. Die große Frage, die sich die Ingenieure – sehr wahrscheinlich nicht nur bei Meta – stellen: Wie kann das sein?

➤ Mehr lesen: DeepSeek: Chinas neue KI lässt die USA zittern

Eine Antwort wäre, dass DeepSeek technisch einfach überlegen ist. Eine andere Antwort ist, dass man sich bei ChatGPT bedient hat. Einige Experten vermuten, dass durch die sogenannte Modell-Destillation das Wissen von GPT-4 angezapft wurde. Das würde erklären, warum DeepSeek mit einem so geringen Trainingsaufwand lernen konnte.

Nvidia und Sam Altman gratulieren

Diskussionen über die Richtigkeit der Angaben kreisten auch um Einfuhrverbote für Nvidia-GPUs nach China. Zumindest Nvidias Top-KI-Prozessoren H100 durften dort nie verkauft werden, die schwächere H800 wurde als Ersatz-GPU für China produziert, darf seit Oktober 2024 aber ebenfalls nicht mehr verkauft werden.

Allerdings teilte Nvidia Bloomberg mit, DeepSeek sei ein „ausgezeichneter KI-Fortschritt“ und habe nicht gegen Handelsrecht verstoßen. Einige Experten vermuten, dass gerade die eingeschränkte Verfügbarkeit der US-Hardware dafür gesorgt hat, aus der Not eine Tugend zu machen und einen so effizienten Ansatz zu entwickeln. Auch OpenAI-Chef Sam Altman lobte den neuen Konkurrenten, nicht ohne anzumerken, dass ChatGPT „offensichtlich viel bessere Modelle liefern“ würde.

Die KI-Blase

Die große Frage, die dieses Szenario aufwirft, ist aber weniger technischer als vielmehr wirtschaftlicher Natur. Die aktuelle Situation macht deutlich, dass der KI-Markt eine Gelddruck-Maschine ist. Warum sollte man ressourcenschonend arbeiten, wenn sich die Firmen gegenseitig Milliarden-Investitionen zuschieben können?

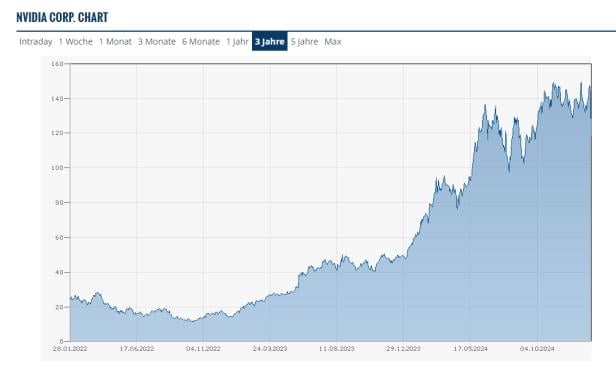

Ganz im Gegenteil profitieren sämtliche Beteiligten davon, ebendas nicht zu tun, sei es durch staatliche Förderungen oder durch einen rasant steigenden Börsenwert. Die 600 Milliarden Dollar Verlust, die Nvidia an der Börse machte, sind ein perfektes Beispiel dafür. Sie klingen enorm, sind im Gesamtbild aber verkraftbar. 2022 kostete eine Aktie des Unternehmens noch um die 13 Euro, Anfang Jänner erreichte sie einen Spitzenwert von 145 Euro. Der rasante Anstieg des Unternehmenswerts ist allein dem KI-Hype zu verdanken und hat jetzt erstmals einen bemerkbaren Dämpfer bekommen.

➤ Mehr lesen: Nvidia im Höhenflug: Was Grafikchips mit dem KI-Boom zu tun haben

Die Kursentwicklung von Nvidia in den letzten 3 Jahren

© Finanzen.at / Screenshot

Bisher konnten KI-Entwickler erklären, immer mehr Rechenleistung zu brauchen, um ihre Modelle noch perfekter zu trainieren. GPU-Hersteller lieferten die Prozessoren, die in riesigen Rechenzentren auf Hochtouren laufen. Stromanbieter sorgen dafür, dass das reibungslos läuft, ohne die Netzstabilität zu gefährden. Eine Hand wusch die andere und die reichsten Menschen wurden noch reicher.

Die richtigen Fragen werden jetzt gestellt

Hinterfragt wurde das nur gelegentlich, wie etwa von Goldman Sachs in einem Bericht von Juni 2024. Dort stellte man die Frage, wie wirtschaftlich die enormen Investitionen eigentlich sind und einige Experten stellen das durchaus in Frage, sagen aber langfristige Erfolge voraus. Noch rechnet sich das Investment zumindest nicht, was am Beispiel von OpenAI deutlich wird. Trotz 200-Dollar-Abo macht das Unternehmen Verluste (futurezone berichtete).

➤ Mehr lesen: KI-Hype: Vorsicht vor dem hungrigen Schwarzen Loch

Auch wenn es im Moment für manch Beobachter eine gewisse Befriedigung mit sich bringt, dem KI-Hype-Kartenhaus beim Zusammenfallen zuzusehen, so ehrlich muss man die Situation auch betrachten. Es herrscht völlige Ahnungslosigkeit darüber, wie DeepSeek sein Sprachmodell so billig und ressourcenschonend umsetzen kann – bzw. ob das überhaupt den Tatsachen entspricht. Das gilt es, in den kommenden Tagen und Wochen zu ermitteln. Unabhängig vom Ergebnis hat DeepSeek der Branche aber eine Ohrfeige verpasst. Selbst wenn sie sich als weniger revolutionär herausstellt, wird die Frage bleiben: Ist der KI-Markt im aktuellen Ausmaß eine unnötig aufgeblasene Ressourcenverschwendung?

Frag die futurezone

In der Rubrik "Frag die futurezone" recherchieren und beantworten wir ausgewählte Fragen zu Tech-Themen für euch.

Stellen könnt ihr sie mit einer E-Mail an die Adresse redaktion@futurezone.at - Betreff: "Frag die futurezone", ihr könnt uns aber auch gern via Social Media (Facebook, Instagram, Twitter) kontaktieren.

Kommentare