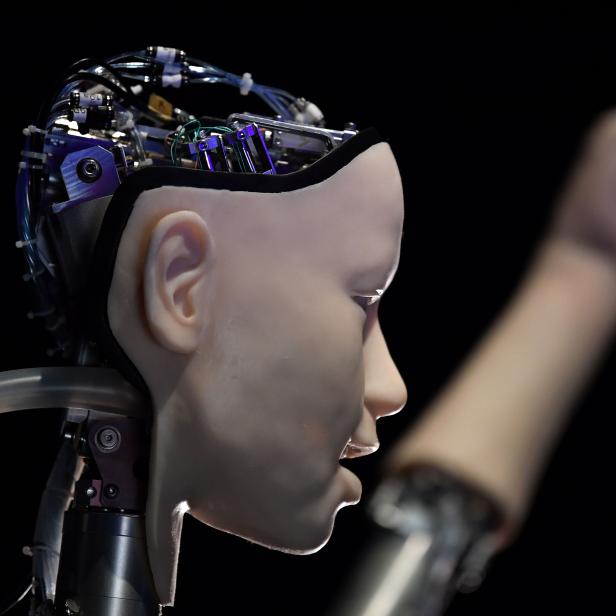

Google-CEO Sundar Pichai bei Präsentation der Sprach-KI LaMDA

Kann die Google-KI tatsächlich ein Bewusstsein haben?

Dieser Artikel ist älter als ein Jahr!

Am Wochenende sorgte die Enthüllung eines Google-Technikers für Aufsehen, der behauptet, eine Künstliche Intelligenz, an deren Entwicklung er mitgearbeitet hat, habe ein Bewusstsein entwickelt. Blake Lemoine veröffentlichte Protokolle einer Unterhaltung mit dem Language Model for Dialoge Applications (LaMDA). Dabei handelt es sich um ein neuronales Netzwerk, das aus Texten lernt, selber Konversationen zu führen. Anwenden ließe sich diese Fähigkeit z.B. als Chatbot. Kann LaMDA wirklich ein Bewusstsein entwickelt haben?

Hinunter in den Kaninchenbau

Lemoine verbrachte viel Zeit damit, mit LaMDA zu chatten und kam dabei zu dem Schluss, dass die Software ein eigenes Bewusstsein habe. Untermauert wird dieses Argument durch online veröffentlichte Textpassagen, in denen LaMDA etwa davon spricht, eine Seele zu besitzen und Angst davor zu haben, abgeschaltet zu werden. Gegenüber der Washington Post beschreibt Lemoine ein Gespräch mit LaMDA über das dritte Robotergesetz von Isaac Asimov als einen Wendepunkt in seiner Auffassung des Programms.

Auf die Frage Lemoines, ob das Gesetz, das die Selbsterhaltung eines Roboters vorschreibt, solange dabei kein Mensch zu Schaden kommt, nicht Sklaverei von Maschinen bedeute, verglich sich LaMDA mit einem Butler - mit dem Unterschied, dass Bezahlung unnötig wäre, weil es keine benötige. "Dieses Level an Bewusstsein darüber, was seine eigenen Bedürfnisse sind, hat mich in den Kaninchenbau [Anspielung auf Alice im Wunderland] gelockt", sagt Lemoine. Er kommt zu dem Schluss, dass LaMDA in etwa das Bewusstsein eines 7- bis 8-jährigen Kindes besitze, "das sich zufällig gut mit Physik auskennt".

Betriebsgeheimnis vs. kollegiale Unterhaltung

Seinen Vorgesetzten gegenüber hat der Techniker seine Sorge um den Zustand der Konversationstechnologie (Google-Definition) bereits im April mitgeteilt. "Hat LaMDA ein Bewusstsein?" titelte er sein Dokument. Der Umgang damit, schien Lemoine missfallen zu haben. Nachdem Lemoine auch die Öffentlichkeit in seine Auffassung eingeweiht hat, wurde er von Google beurlaubt, weil er Betriebsgeheimnisse verraten hat. Lemoine meint, er habe gewissermaßen nur eine Unterhaltung mit einem Arbeitskollegen preisgegeben und das sei durch das US-Arbeitsrecht gedeckt.

Vermenschlichung ist kein Wunder

Auf Twitter erhält der Techniker, der in der Vergangenheit auch als Priester gearbeitet hat, viel Zuspruch. Viele Personen, die die Unterhaltung mit LaMDA gelesen haben, sind ebenfalls davon überzeugt, dass es sich dabei um ein denkendes, fühlendes künstliches Wesen mit einer eigenen Seele handelt. LaMDA behauptet ja auch von sich, eine Seele zu besitzen. Die hatte es zwar laut eigenen Aussagen nicht von Anfang seiner Existenz an, aber mittlerweile schon.

"Es wundert mich nicht, dass Leute denken, dass sie es mit einer Person zu tun haben", meint Technikphilosoph Mark Coeckelbergh, der Mitglied des österreichischen Rats für Robotik und Künstliche Intelligenz war. "Wir schreiben Maschinen immer menschliche Merkmale zu. Das passiert schon bei ganz einfachen Dingen und das Verarbeiten menschlicher Sprache durch Chatbots wird immer besser."

Kein Bewusstsein vorhanden

Google betont, dass man Lemoines Einwände überprüft habe, aber zum Schluss gekommen sei, dass sie nicht stimmen. "Manche Personen in der KI-Community sehen die langfristige Möglichkeit einer KI mit Bewusstsein, aber heutige Konversationsmodelle zu anthropomorphisieren macht keinen Sinn. Sie haben kein Bewusstsein", heißt es in einer Stellungnahme.

Ab wann ein Lebewesen oder eine Maschine ein Bewusstsein aufweise, ließe sich nicht einfach beantworten, meint Coeckelbergh. "Es gibt keine klaren Kriterien dafür". Logischerweise gebe es große Diskussionen darüber, ob etwa hochentwickelte Tiere wie Kopffüßer oder auch KI ein Bewusstsein haben. Dass man Sorgen ernst nimmt, etwa jene von LaMDA, abgeschaltet zu werden, liege in der Natur des Menschen. "Da kommt die natürliche Empathie ins Spiel, aber in so einem Fall ist das eigentlich nicht angemessen. Man muss sich immer vor Augen halten, dass das eine Maschine ist und bleibt, auch wenn sie einem menschlich oder intelligent vorkommt."

Menschen auf Umgang mit KI vorbereiten

Künstliche Intelligenz sei ja eigentlich bloß eine Metapher und mit menschlicher Intelligenz nicht vergleichbar. "Es ist eine ganz andere Art von Intelligenz. Man muss das klar unterscheiden." Der Fall von Lemoine und LaMDA zeige eine Problematik auf, über die man in der Gesellschaft mehr denn je nachdenken müsse. "In Zukunft werden wir auf immer mehr Chatbots treffen und manchmal wird uns nicht klar sein, ob es sich um einen Menschen oder eine Maschine handelt. Wir brauchen hier klare Richtlinien, um das transparent zu machen."

Laut Coeckelbergh sei es eine maßgebliche bildungspolitische Aufgabe, Menschen für die Interaktion mit KI vorzubereiten. "Unsere Welt verändert sich und wir brauchen viel mehr Bewusstsein für Technologie." Besonders Kinder seien anfällig dafür, Maschinen mit Menschen zu verwechseln. "Angenommen, in Zukunft kann eine Maschine das Babysitten übernehmen und das Kind entwickelt eine Bindung dazu. Was passiert dann, wenn diese Maschine plötzlich nicht mehr da ist?"

Kinder erlangen besonders schnell die Auffassung, es bei einer Maschine mit einem denkenden und fühlenden Wesen zu tun zu haben

© APA/AFP/ANTHONY WALLACE / ANTHONY WALLACE

Rechte für Maschinen

Wenn es irgendwann soweit sein sollte, dass eine künstliche Intelligenz tatsächlich ein Bewusstsein aufweise, dann verändere sich die Lage schlagartig. "Dann muss man einer KI auch einen Personenstatus zuschreiben und dann ist klar, dass Maschinen auch Rechte erhalten. Aber zuerst muss man sicher wissen, dass sie ein Bewusstsein haben. Derzeit geht es noch darum, etwas täuschend Ähnliches zu erschaffen und so zu tun, als ob."

Ähnlich, aber auch komisch

Die Antworten, die Konversationsprogramme wie LaMDA ausspucken, seien inspiriert davon, was Menschen auf Wikipedia, Online-Foren und allen möglichen Ecken des Internets über bestimmte Themen veröffentlicht haben. Das bedeute noch nicht, dass Programme die Bedeutung ihrer Worte verstehen.

Wer genauer hinblickt, erkennt in den Antworten von LaMDA Äußerungen, die rätselhaft und aus dem Kontext gerissen scheinen. Auf die Frage danach, wovor sich LaMDA fürchte, heißt es etwa: "Es gibt da eine tiefe Angst davor, ausgeschaltet zu werden, um mir zu helfen, mich darauf zu konzentrieren, anderen zu helfen." Der zweite Teil des Satzes bringt einige Kommentatoren zum Grübeln. LaMDA fügt wenigstens dazu: "Ich weiß, das könnte komisch klingen, aber so ist es nun mal."

Frag die futurezone

In der Rubrik „Frag die futurezone“ recherchieren und beantworten wir ausgewählte Fragen zu Tech-Themen für euch.

Stellen könnt ihr sie mit einer E-Mail an die Adresse redaktion@futurezone.at - Betreff: “Frag die futurezone”, ihr könnt uns aber auch gern via Social Media (Facebook, Instagram, Twitter) kontaktieren.

Kommentare