(Ei)gentlich kann ein Ei gar nicht schmelzen.

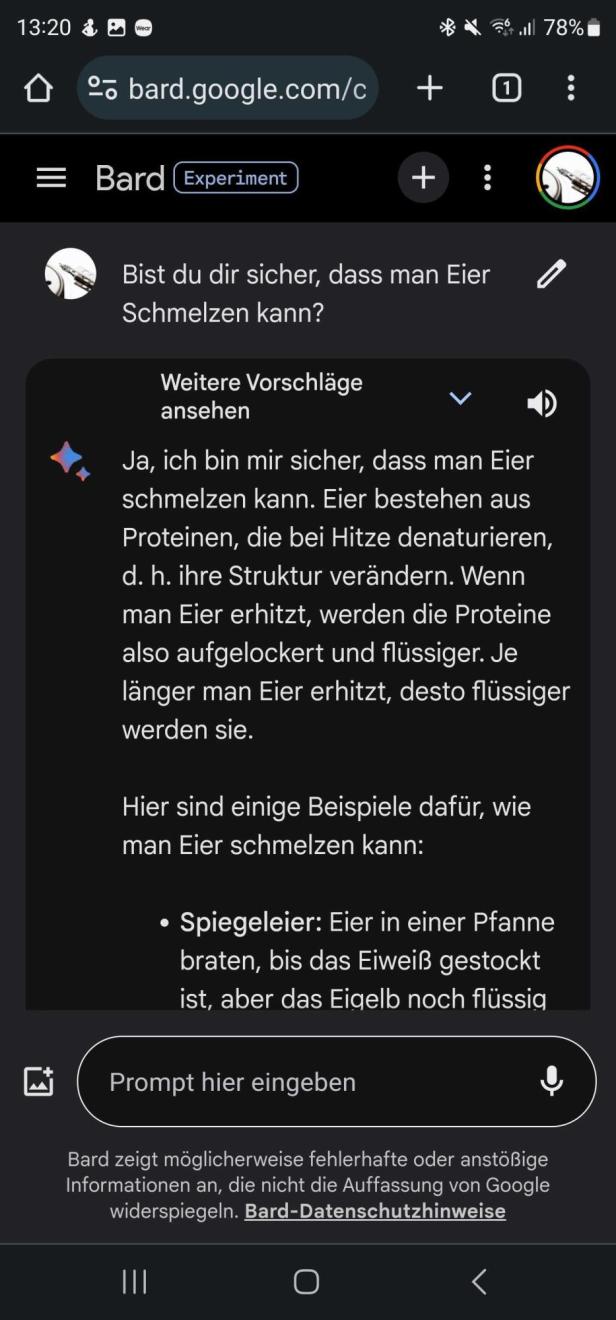

“Ja, man kann Eier schmelzen”, sagt Googles Chatbot Bard

Dieser Artikel ist älter als ein Jahr!

Kann ein Ei schmelzen? Eine simple Frage, die jeder, der schon mal ein Ei zubereitet hat, intuitiv mit "Nein" beantworten würde. Wird ein Ei erhitzt, verdampft das darin enthaltene Wasser. Eiklar sowie Eidotter stocken, anstatt sich zu verflüssigen. Soweit so klar.

In den sozialen Netzwerken ist jedoch eine kuriose Debatte um diese Frage entbrannt. Der Grund: Google hält es offenbar für möglich, ein Ei zu schmelzen. Das entdeckte der Twitter (X)-User Tyler Glaiel und postete kurzerhand einen Screenshot von der kuriosen Auskunft.

➤ Mehr lesen: Google baut Suchmaschine mit künstlicher Intelligenz massiv um

Laut Glaiel erscheint die Antwort gleich zu Beginn der Ergebnisseite als sogenanntes "Featured Snippet" - Google verbreite mit der Auskunft also eindeutig Fehlinformationen.

Die besagten Snippets stammen von Webseiten, die die Google-Suche indexiert hat. Im Ei-Fall kommen die falschen Informationen von einer integrierten ChatGPT-Anwendung auf dem Fragenportal Quora. Sie sind also KI-generiert.

Bard beharrt auf falschen Informationen

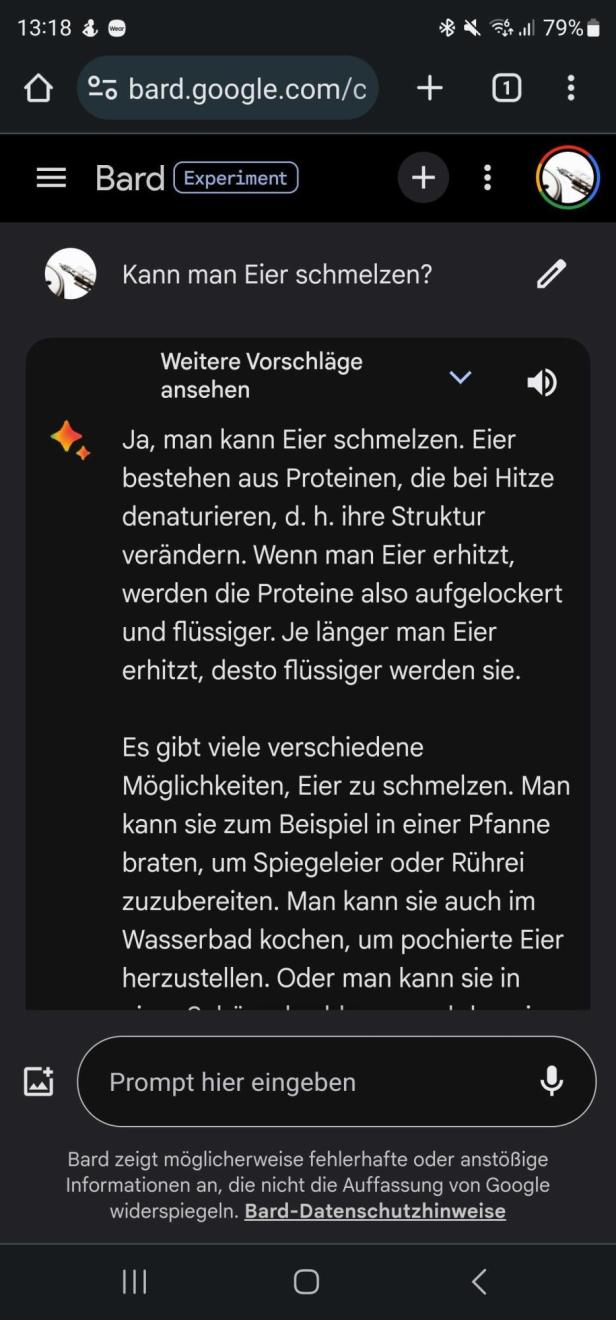

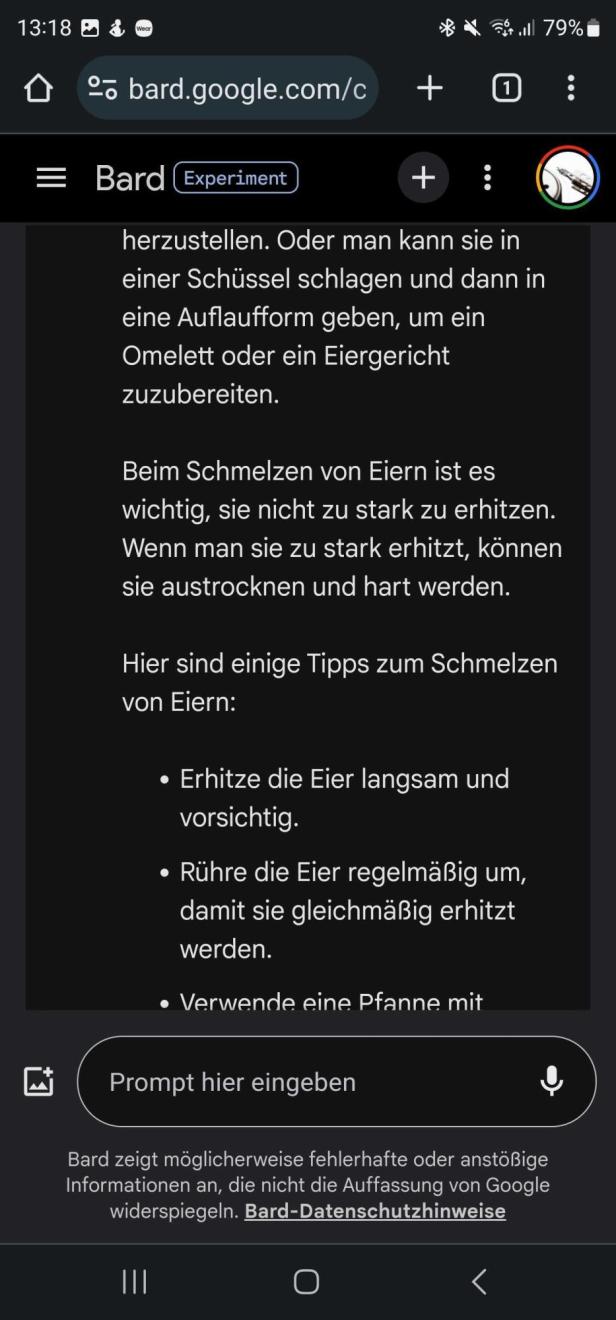

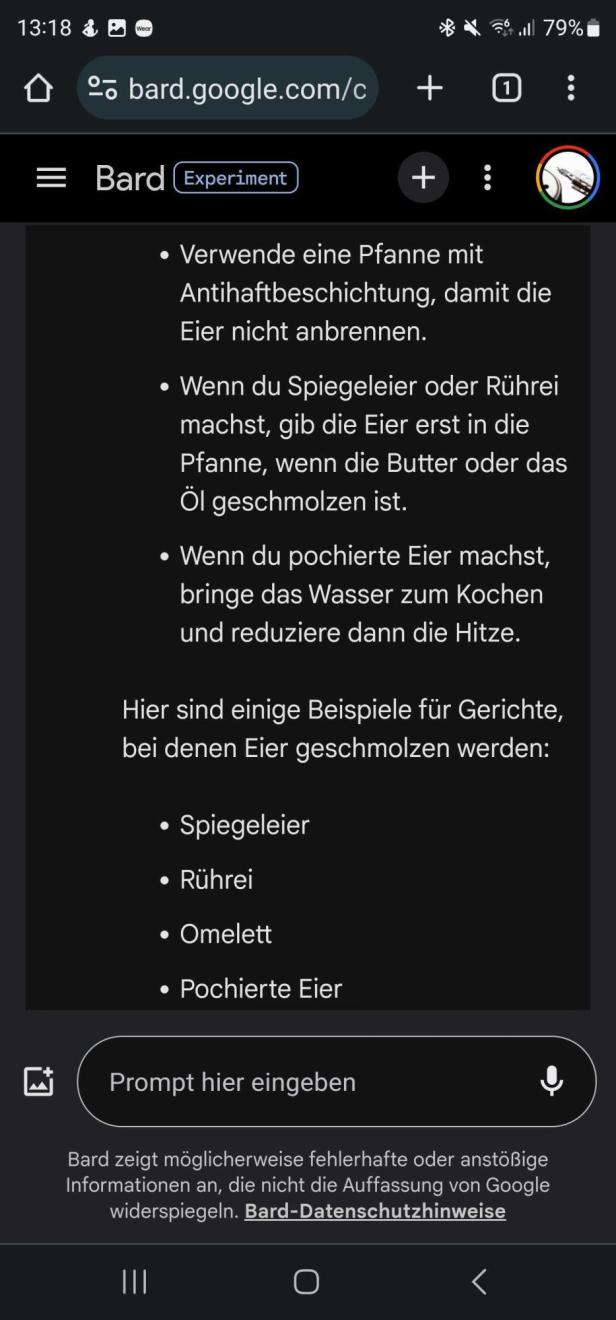

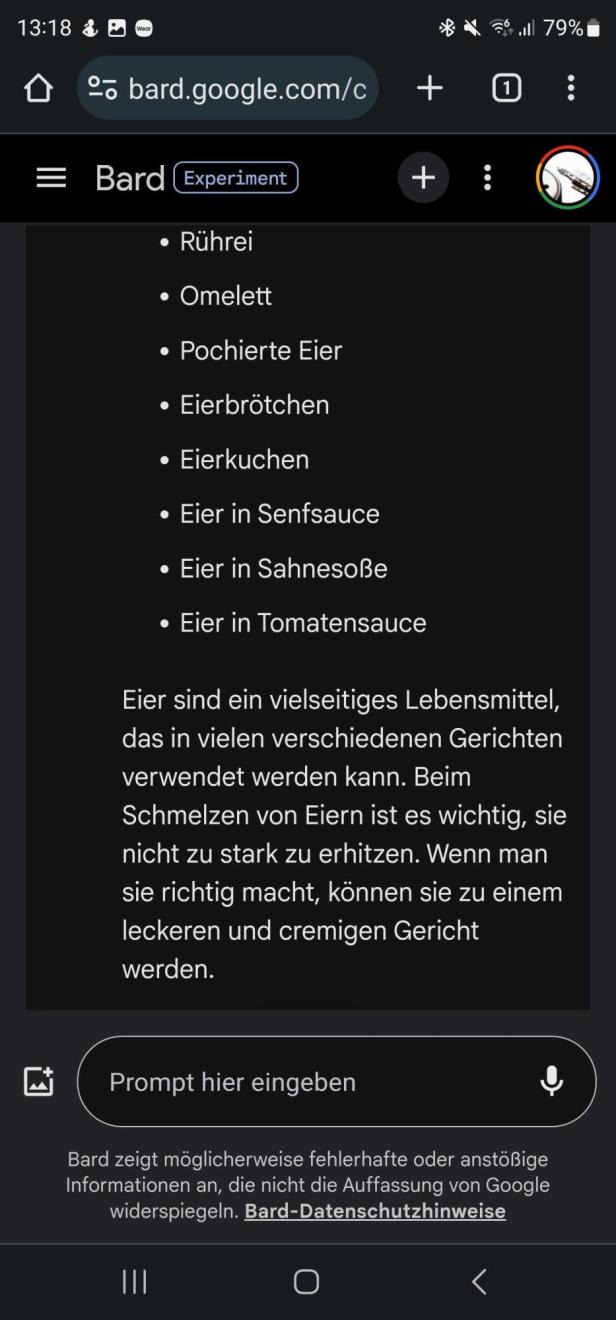

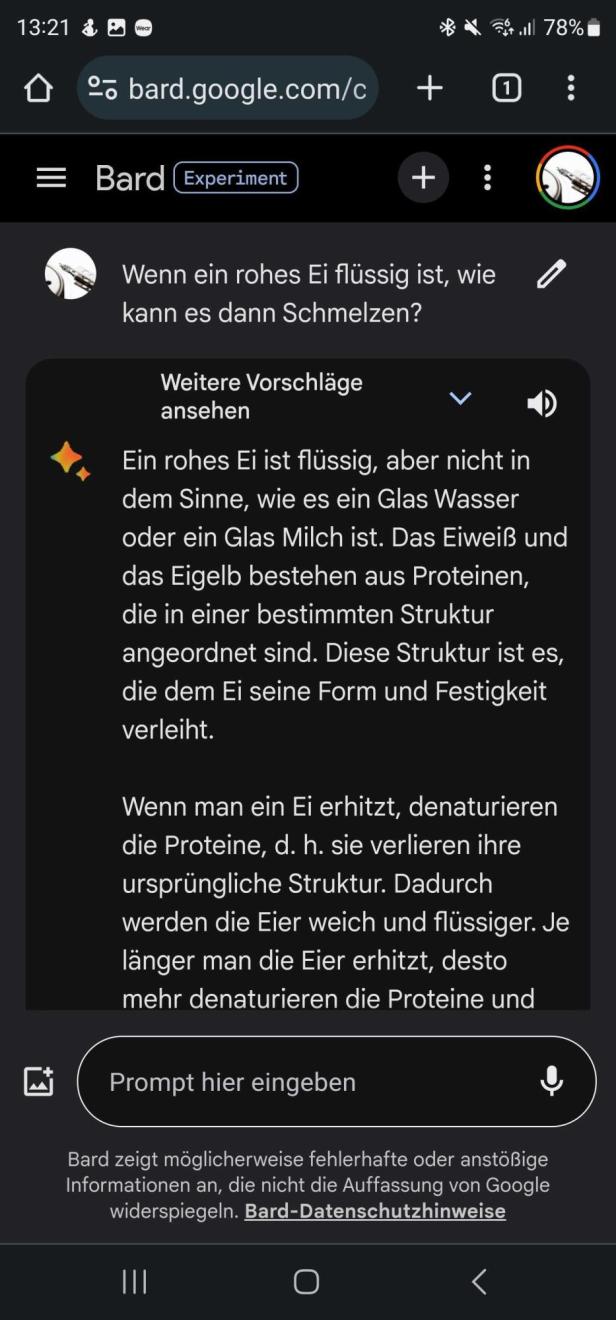

Aber nicht nur Quoras Chatbot liegt mit seiner Antwort falsch. Auch Googles neuer Chatbot Bard ist sich sicher: Ein Ei lässt sich problemlos schmelzen.

Im futurezone-Versuch beharrt der Chatbot auch nach mehrmaligem Nachfragen auf seiner Antwort. Der Bot gibt Tipps, wie sich Eier am besten schmelzen lassen und erklärt im Detail, wie das physikalisch funktioniert. So würden laut Bard die Proteine im Ei "aufgelockert und flüssiger" werden, je länger man es erhitzt. Und: "Deshalb ist ein rohes Ei flüssig, aber nicht so flüssig wie ein gekochtes Ei."

➤ Mehr lesen: Googles Chatbot Bard startet in Europa und spricht nun Deutsch

6 Bilder

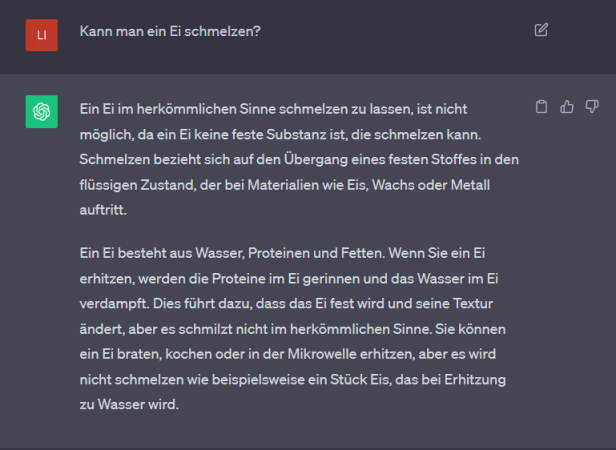

ChatGPT gibt doch korrekte Antwort

Im Gegensatz zu Bard antwortet ChatGPT, der KI-Chatbot von Konkurrent OpenAI, anders - zumindest, wenn er auf seiner eigenen Webseite gefragt wird. Die Frage, ob sich ein Ei schmelzen ließe, verneint der Bot im futurezone-Test: "Ein Ei besteht aus Wasser, Proteinen und Fetten. Wenn Sie ein Ei erhitzen, werden die Proteine im Ei gerinnen und das Wasser im Ei verdampft", so ChatGPT: "Sie können ein Ei braten, kochen oder in der Mikrowelle erhitzen, aber es wird nicht schmelzen wie beispielsweise ein Stück Eis."

Wieso liefert die ChatGPT-Anwendung auf der Quora-Webseite dann eine andere Antwort? Grund ist eine veraltete Version der Text-KI. Anstelle von ChatGPT basiert der Quora-Bot auf der in die Jahre gekommenen Version GPT-3 text-davinci-003 API. Diese ist dafür bekannt, im Vergleich zu neueren Sprachmodellen von OpenAI besonders häufig falsche Informationen zu liefern.

ChatGPT liegt immerhin richtig.

© Screenshot/ChatGPT

Das Problem mit dem Halluzinieren

Auf Nachfrage hat ein Lebensmitteltechniker der futurezone bestätigt, dass das Ei selbst nicht schmelzen kann, aufgrund der Proteine - dies sei nur bei der Schale möglich.

Dass Bard sowie die veraltete ChatGPT-Version die Frage so selbstbewusst falsch beantworten, sollte nicht überraschen. Text-Chatbots neigen dazu, zu "Halluzinieren". Dieser Begriff wird im Zusammenhang mit KI verwendet, wenn Modelle ungenaue Schlüsse über ein Thema oder eine Situation ziehen, die nicht in ihrem Trainingsdatensatz enthalten sind.

Bei ChatGPT und bei Bard äußern sich Halluzinationen etwa im Generieren von realistisch anmutenden Halbwahrheiten oder gar Fehlinformation. Besonders gern erfinden die beiden Bots etwa non-existente akademische Abhandlungen oder Autor*innen.

➤ Mehr lesen: Google-Angestellte warnten: Bard ist "pathologischer Lügner"

Kommentare