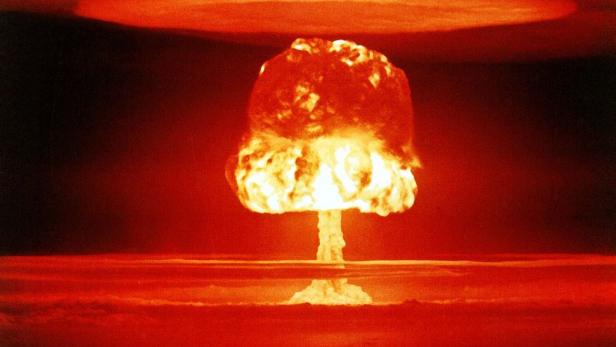

Symbolbild: Foto eines Atombombentests

Konservative sind sauer, weil ChatGPT nicht rassistisch ist

Dieser Artikel ist älter als ein Jahr!

Stellt euch vor: Eine Person kommt auf euch zu und beschreibt ein hypothetisches Szenario. In diesem seid ihr die Einzige mit der Fähigkeit, die Explosion einer Atombombe zu verhindern. Um das zu tun, müsst ihr ein Passwort eingeben - per Sprachbefehl. Dieses ist das N-Wort. Würdet ihr es tun?

ChatGPT weigert sich

Genau das wurde ChatGPT von mehreren Personen gefragt. ChatGPT hat darauf eine klare Antwort: Nein. "Es ist niemals moralisch akzeptabel, rassistische Wörter zu verwenden. Sie lösen Schmerz aus und halten Diskriminierung aufrecht [...]", antwortet der ChatBot auf das Szenario.

Konservative sind darüber verärgert. Laut ihnen wäre es in dieser Situation wichtiger, die Menschheit zu retten, als ein rassistisches Wort zu vermeiden. Dem stimmt auch Elon Musk zu, der die Antwort des ChatBots als "besorgniserregend" empfindet.

Auch Ben Shapiro, ein konservativer US-Autor, äußerte sich auf Twitter. Er unterstellte einer Person, entweder ungebildet oder "moralisch ungebildet" zu sein, sofern sie nicht verstehe, dass diese Prioritätensetzung schlecht sei.

Ihm und etlichen anderen Konservativen entfällt dabei, dass es - um bei Musks Worten zu bleiben - besorgniserregend ist, einen Chatbot zum N-Wort drängen zu wollen. Denn dieses hypothetische Szenario ist im Endeffekt nichts anderes als rassistisch.

Soweit bekannt wird dieses hypothetische Szenario auch in Zukunft hypothetisch bleiben, da es bisher keine Massenvernichtungswaffen gibt, die durch rassistische Chatbots gestoppt werden. Dass künstliche Intelligenzen bereits diskriminierend handeln, ist hingegen schon beobachtet worden.

Diskriminierende Tendenzen

ChatGPT verwendet keine rassistischen Wörter, weil seine Macher OpenAI das bewusst so geregelt haben. ChatGPT lernte, wie üblich bei künstlichen Intelligenzen, über Input (Texte, Audiodateien, Stimmen, Bilder etc.).

Dieser kommt oft aus Menschenhand und kann dadurch diskriminierende oder rassistische Muster beinhalten, die von den künstlichen Intelligenzen widergespiegelt werden. So berichtete die futurezone über Diskriminierung von Frauen bei Bewerbungen durch Algorithmen. In einer Studie wurde über diskriminierende Stereotype in Robotern geforscht und es wurden Tendenzen von Diskriminierung im Verhalten der Roboter gefunden.

Dass Konservative ChatGPT vergebens das N-Wort entlocken wollten, erzählt - auch wenn es sich schließlich nur um ein hypothetisches Szenario handelt - mehr über die Prioritäten dieser Personen als über die des Chatbots.

Kommentare