Ein Zahlenwert für jeden Bürger und jede Bürgerin: Social Scoring durch KI wie in China soll es in der EU nie geben

Über KI soll man sich in der EU künftig beschweren können

Dieser Artikel ist älter als ein Jahr!

"Es ist die erste rechtliche Regelung von KI, die weltweit verhandelt wird", sagt Digitalisierungs-Staatssekretär Florian Tursky über den "AI Act". Seit 2021 arbeiten die Institutionen der EU an diesem rechtlichen Rahmen, mit dem die Anwendung von künstlicher Intelligenz genau reguliert werden soll. Am kommenden Dienstag will der europäische Rat verraten, welche allgemeine Ausrichtung die KI-Verordnung haben soll.

EU sucht Vorreiterrolle

Die EU erwartet sich vom AI Act einen großen Wurf, denn: Europa will - wie schon bei der Datenschutzgrundverordnung - einen globalen Standard schaffen. Bisherige Entwürfe des AI Act wurden kritisiert, u.a. weil sie Bürger*innen zu wenig Handhabe gegen Unternehmen, die mit KI arbeiten, bot und diverse Ausnahmen vorsah. Die aktuelle Fassung enthält hier Verbesserungen.

Unannehmbar und damit verboten

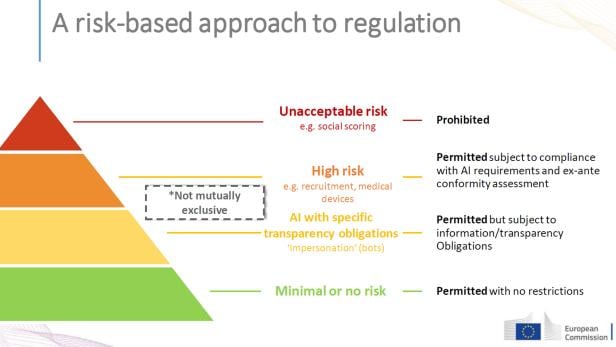

Grundsätzlich verfolgt der Vorschlag für die Verordnung einen risikobasierten Ansatz. KI-Anwendungen werden in vier Kategorien eingeteilt: Minimales Risiko, geringes Risiko, hohes Risiko und unannehmbares Risiko. Unannehmbar und somit verboten sind etwa die unterschwellige Manipulation durch KI, das Ausnutzen von Schwachstellen spezifischer Personengruppen (etwa Kinder) oder die Echtzeit-Fernidentifikation. Damit ist etwa Massenüberwachung durch Gesichtserkennung gemeint. Bei der Fahndung nach Personen, denen ein Strafmaß von über drei Jahren droht, dürfen Kameras mit Gesichtserkennung aber eingesetzt werden. Gänzlich verboten ist "Social Scoring", wie es etwa in China passiert, also die Klassifizierung einer Person aufgrund von politisch festgelegten Faktoren.

Die EU stuft im AI Act KI in verschiedene Risikoklassen ein und reguliert jede davon unterschiedlich stark

© EU-Kommission

Hohe Anforderungen für hohes Risiko

Unter die Kategorie hohes Risiko fallen die Feststellung von Kreditwürdigkeit durch KI, die Auswahl von Personal oder KI, die kritische Infrastruktur steuert. Neu dabei sind auch Versicherungen, die Angebote und Preisgestaltung für spezifische Kund*innen einer KI überlassen. Hier sieht der AI Act sehr hohe Anforderungen vor, die von Regierungen und Unternehmen erfüllt werden müssen, um keinen Menschen zu diskriminieren oder zu gefährden.

Derartige KI-Systeme müssen unter menschlicher Aufsicht stehen. Ihre Aktionen unterliegen Dokumentations- und Aufbewahrungspflichten, die zugrunde liegenden Algorithmen müssen offengelegt und kontrolliert werden, bevor sie in Verkehr gebracht werden.

Unter geringes Risiko fallen Dinge wie automatische Empfehlungen beim Online-Shopping. Hier gibt es immerhin Transparenzverpflichtungen. Ein Unternehmen muss also offenlegen, wie seine KI zu bestimmten Entscheidungen gelangt.

Ausnahmen sollen nicht ausufern

Für bestimmte Anwendungen sollte es laut den bisherigen Verordnungsversionen Ausnahmen geben, vor allem wenn es um Belange der nationalen Sicherheit geht. Kritiker*innen befürchteten, dass dadurch Dinge durch die Hintertür ermöglicht werden, die eigentlich hochriskant oder unannehmbar wären. Autoritäre Regime könnten etwa Massenüberwachung einführen und sich einfach auf nationale Sicherheit berufen. Das EU-Parlament setze sich aber stark dafür ein, dass Ausnahmen nicht ausufern, versichert Tursky.

Stütze für Opfer

Wer sich von KI ungerecht behandelt fühlt, kann dagegen künftig Beschwerde einlegen. Der AI Act stützt hier die Position von Opfern durch Beweiserleichterungen und einer Nachweispflicht für Unternehmen. Außerdem gibt es eine verschuldensunabhängige Haftung. Beispiel: Ein smarter Lautsprecher macht Nutzer*innen einen Vorschlag, der gesundheitsgefährdend ist, etwa einen metallischen Gegenstand in eine Steckdose zu stecken. In diesem Fall haftet der Hersteller und Opfern steht Schadenersatz zu.

Anwendung wahrscheinlich ab 2025

Insgesamt hätten sich die Fachexperten der Mitgliedsstaaten im EU-Rat bemüht, eine gute Balance zwischen einem innovationsfreudigem Umfeld und der Einhaltung von Grundrechten zu finden. Die KI-Verordnung solle einen schlanken Rechtsakt bilden, während viele Details künftig durch zusätzliche Durchführungsrechte geklärt werden sollen. Ein europaweiter Rechtsrahmen schaffe laut Tursky "sowohl für Entwickler die Sicherheit klarer Regeln, als auch für Endnutzer*innen die Sicherheit, mit einer sicheren und vertrauenswürdigen KI-Anwendung zu interagieren".

Die aktuelle Version des AI Act legt der EU-Rat dem EU-Parlament vor. 2023 sollen Kommission, Rat und Parlament im "Trilog" zu einer Endversion gelangen, die dann 2024 verabschiedet und voraussichtlich ab 2025 umgesetzt werden soll.

Kommentare