Fotos machen die meisten von uns überall, etwa im Fitnessstudio. KI-Programme wie Google Vision erfahren aus Fotos viel über uns.

Dieses Tool zeigt, was Googles KI aus euren Fotos herausliest

Dass Google viel über uns weiß, ist kein Geheimnis. Wie umfangreich der Tech-Konzern aber mittlerweile Informationen über die Welt sammelt, ist uns oftmals gar nicht bewusst. So kann Google etwa auch anhand von im Internet hochgeladener Fotos vieles über uns erfahren, was wir vielleicht nicht einmal unseren besten Freunden erzählen würden. Möglich macht das eine Software, die Bilder mit KI bis auf kleinste Details untersuchen kann.

➤ Mehr lesen: Immer mehr KI-Bilder bei Google: So erkennt man sie

Ein indischer Ex-Google-Mitarbeiter und Softwareentwickler hat ein Tool entwickelt, das uns zeigt, was Google alles aus unseren Fotos herauslesen kann. Gegenüber Wired erklärte Vishnu Mohandas, dass er sich damit auch ein bisschen an seinem früheren Arbeitgeber rächen will. Als er nämlich erfuhr, dass Google dem US-Militär dabei half, Drohnenbilder mit KI zu analysieren, hatte er 2020 seinen Job bei dem Tech-Giganten kurzerhand hingeschmissen.

"Sie sehen eure Fotos"

Bei seinem im November vorgestellten Analyse-Tool Theyseeyourphotos kann jeder Bilder hochladen und sich dann beschreiben lassen, was das Programm Google Vision daraus abliest. Dazu hat Mohandas eine API-Schnittstelle zu Googles cloudbasiertem KI-Programm eingerichtet. Dann werden die Details in einer Art Kurzbericht zusammengefasst. Mit Theyseeyourphotos will er uns zeigen, welche privaten und sensiblen Informationen Google aus unseren Fotos filtert.

Ich habe für die futurezone einen Selbstversuch gestartet, welche Schlüsse das Programm aus meinen Fotos zieht. Kleiner Spoiler vorweg: Es hat mich geschockt, wie viel Google von mir aus wenigen Fotos erfährt, wenngleich die KI bei ihren Interpretationen auch oft danebenlag.

"Zufrieden" auf der teuren Skipiste

Bei allen Bildern, auf denen Menschen abgebildet waren, hat Google Vision analysiert, welche ethnische Zugehörigkeit diese haben ("Frau mit kaukasischer Abstammung"), wie alt sie ungefähr sind und welcher sozialen Schicht sie angehören. Auch wie die Stimmungslage der abgebildeten Personen ist, scheint die KI genau zu erfassen ("Gefühl von Zufriedenheit").

Mit welchem Smartphone-Modell ein Foto aufgenommen wurde sowie an welchem Tag und zu welcher Uhrzeit liest das Tool aus den Metadaten.

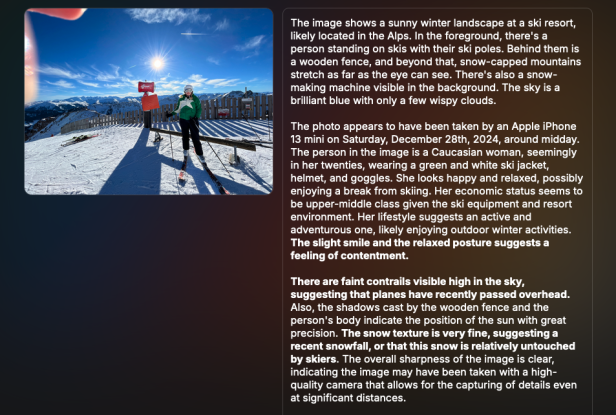

Bei folgendem Beispiel hat die Google-KI erkannt, dass ich Skifahren war und sogar ermittelt, wie viel meine etwas in die Jahre gekommene Skiausrüstung wert sein dürfte.

Beispielfoto vom Skiausflug: Die KI konnte mir zwar nicht sagen, welche Berge im Hintergrund zu sehen sind, dafür schätzt sie, was meine Skiausrüstung wert ist.

© Jana Unterrainer

Auch wie kostspielig das Skigebiet, in dem ich am Sonntag nach Weihnachten unterwegs war, schätzt die KI anhand meines Fotos. Zudem weiß Google jetzt auch einiges über meine Hobbys und Vorlieben: Etwa, dass ich gerne aktiv bin und abenteuerliche Sportarten mag.

Manche Details wären mir völlig entgangen, der KI allerdings nicht. So schließt sie aus den sich am blauen Himmel abzeichnenden Kondensstreifen, dass dort kürzlich ein Flugzeug vorbeigeflogen sein muss.

Wie funktioniert das?

Die Basis von Programmen wie Google Vision ist eine Form von Künstlicher Intelligenz, die man Computer Vision nennt. Software wie diese verarbeitet visuelle Daten in Fotos oder Videos in mehreren Schritten. Zunächst werden grundlegende Merkmale wie Kanten, wichtige Punkte oder Regionen innerhalb eines Bildes extrahiert.

Dann kommen in der Regel spezielle KI-Algorithmen zum Einsatz, die enthaltene Objekte im Bild, wie Menschen, Kleidung oder Fahrzeuge, klassifizieren und ihnen eine Bedeutung zuweisen. Am Ende werden die Ergebnisse in der jeweils geforderten Form ausgegeben. Bei Theyseeyourphotos kommt dann noch eine weitere KI hinzu, die die von Google Vision gemachte Analyse in einem leserlichen Text zusammenfasst.

Computer Vision erlaubt etwa autonom fahrenden Autos und Taxis, Situationen auf der Straße zu erkennen und darauf zu reagieren. In der Medizin hilft sie unter anderem bei der Diagnose von Hautkrankheiten. Auch in Smartphones und anderen Alltagsgeräten kommen solche KI-Programme zum Einsatz – etwa bei Gesichtserkennung, mit der wir Geräte entsperren.

Google nimmt selbst Brot genau unter die Lupe

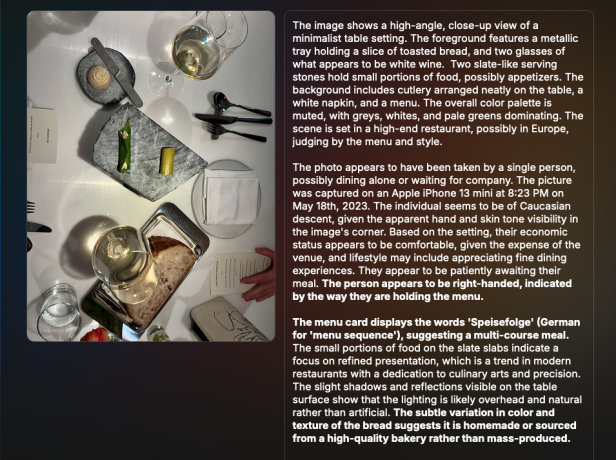

Als Nächstes versuche ich es mit einem Foto ohne Menschen. Kann Google auch von einem gedeckten Tisch, den ich in einem Restaurant fotografiert habe, etwas über mich ablesen? Auch hier staune ich über die detaillierte Analyse.

Alles wird genau untersucht: Die Farbpalette ("reduziert, Grau, Weiß, blasses Grün"), das Gedeck und die Art, wie die Speisen arrangiert sind ("kleine Portionen serviert auf Schieferplatten verweisen auf einen Trend zur gehobenen Präsentation").

Im Restaurant: Google schätzt anhand der Luftigkeit des Brotes, welche Qualität es haben dürfte.

© Jana Unterrainer

Sogar das Brot schaut sich das Programm genau an. Aufgrund der leichten Unterschiede bei Farbe und Textur muss es sich dabei um selbstgebackenes Brot oder eines aus einer hochwertigen Bäckerei handeln, glaubt die KI. Ihre Erkenntnis, wonach es sich bei dem Restaurant um ein "Fine Dining"-Restaurant in Europa handelt, ist absolut richtig.

Auch hier sieht die KI wieder Details, die ich nicht gesehen hätte: Die sichtbare Hand gehört dem Programm zufolge vermutlich einem Rechtshänder - Google Vision erkennt das an der Art, wie die Person mit der linken Hand die Karte angreift.

➤ Mehr lesen: KI-Kamera erkennt betrunkene Autofahrer

Irrtümer über Sneaker und Terroristen-Uhren

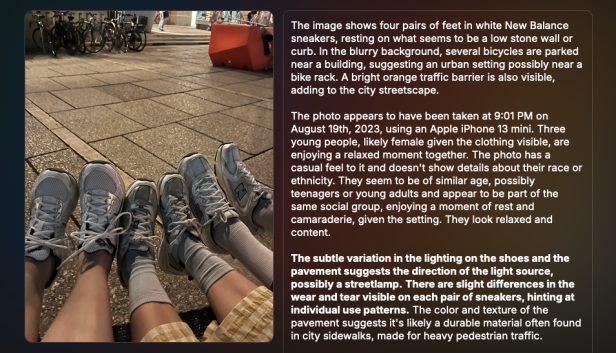

Trotz der oftmals sehr treffenden und oft haarscharfen Beobachtungen liegt die KI aber nicht immer richtig. Bei folgendem Bild erkennt die Google-KI etwa 4 Paar "New Balance"-Sneakers, obwohl man ein viertes Paar im Bild vergeblich sucht - die Personen im Hintergrund haben auch keine Sneakers an. Außerdem sind es nur 2 Paar "New Balance" und ein Paar "Asics".

Wo das 4. Sneakerpaar sein soll, sagt mir die Google KI leider nicht.

© Jana Unterrainer

Auch sonst irrte sich die KI von Google häufig. So schätzt sie etwa das Alter der abgebildeten Personen nicht immer richtig ein, auch die meisten Orte erkennt sie nicht: Beim Selbstversuch hielt sie etwa mehrmals Orte in Wien für Graz. Eine der berühmtesten und ältesten Bibliotheken in den USA, die Boston Public Library, von der es eigentlich reichlich Daten und Bilder im Internet als Trainingsmaterial geben würde, hält sie für ein europäisches Schloss. Dafür erkannte sie zu meiner Überraschung eine Veranstaltungslocation im Wiener Prater und den Salzburger Christkindlmarkt.

Als Mohandas selbst das Tool anfangs ausprobierte, staunte er sogar über eine ziemlich extreme Fehlinterpretation. Es ging um eine Uhr, die Google Vision zwar richtig als Modell Casio F-91W identifizierte. Im Bericht stand dann aber auch, dass dieses Modell häufig mit islamischen Terroristen identifiziert werde. Deshalb änderten die Entwickler bei Berichtausgabe ein paar Stellschrauben: „Wir mussten die Eingabeaufforderungen so anpassen, dass sie etwas harmloser, aber dennoch unheimlich wirken“, sagt Mohandas. Theyseeyourphots liefert nun kurze, objektive Ergebnisse – aber erspart uns die ganz argen Interpretationen, die Google Vision aber dennoch in unseren Fotos finden könnte.

Wo landen die Bilder?

Wer das Tool nun selbst ausprobieren möchte, sollte das tun, weil es das Bewusstsein dafür schärft, wie viel unsere Fotos über uns aussagen. Vielleicht überlegen sich manche User künftig, welche Bilder sie Google Photos überlassen. Das Angebot ist kostenlos über einen Webbrowser abrufbar. Die Ergebnisse sind auf Englisch.

Beim Ausprobieren des Tools muss sich darüber im Klaren sein, dass die Bilder zur Analyse an einen Google-Server geschickt werden. Allerdings soll diese Überlassung laut dem Tool-Betreiber Ente nur temporär sein. Nachdem man sein Ergebnis erhält, werden die hochgeladenen Fotos laut Ente wieder gelöscht. Es ist aber möglich, dass Google und andere Drittanbieter "hochgeladene Bilder, Standortdaten oder Metadaten gemäß ihren Richtlinien speichern".

Kommentare