KI-Chatbots haben im Schach versagt.

ChatGPT und Copilot blamieren sich im Schach gegen Atari 2600

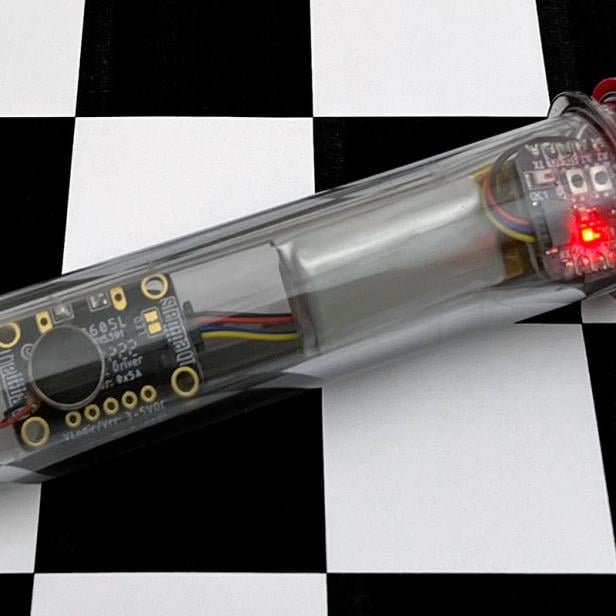

Die Retro-Spielekonsole Atari 2600 feiert bald ihren 50. Geburtstag. Darauf läuft ein Schachprogramm, das Ende der 1970er Jahre fast als Technik-Wunder galt: Menschen konnten damit gegen den Computer Schach spielen.

Schlechte Spieler ärgerten sich damals, wenn sie gegen das einfache Programm verloren. Heutzutage ärgern sich nicht nur schlechte menschliche Schachspieler – sondern auch KI-Programme würden das, wenn sie denn Gefühle hätten. Obwohl ChatGPT mittlerweile ganze Diplomarbeiten schreiben und in der Buchhaltung von Unternehmen Aufgaben übernehmen kann, ist es im Schach erstaunlich schwach. Kürzlich verlor das Modell 4o, das hinter dem beliebten Chatbot steckt, gegen das Atari-2600-Schachprogramm.

➤ Mehr lesen: In Duolingo kann man bald auch Schach spielen

Primitives Schachprogramm

Raffiniert ist das alte Schachprogramm eigentlich nicht – es plant seine Züge maximal 1 bis 2 Schritte im Voraus. Es läuft auf einem 8-Bit-Chip mit einer Rechenleistung von gerade einmal 1,19 MHz. Zum Vergleich: Der Prozessor eines modernen Smartphones ist millionenfach leistungsfähiger. Damit wären heutige Anwendungen undenkbar.

Trotzdem verlor OpenAIs KI-Modell 4o – das sowohl ChatGPT als auch Microsofts Copilot antreibt – im Juni bei mehreren Schachpartien gegen den Atari 2600. Das Experiment führte ein Techniker namens Robert Caruso durch, der beim Softwareunternehmen Citrix arbeitet.

ChatGPT stellte sich ungeschickt an

Anfangs schob ChatGPT sein Versagen auf die verwendeten Schachsymbole. Laut der KI seien die Darstellungen zu abstrakt gewesen. Daraufhin vereinfachte Caruso die Symbole extra für die KI. Doch auch diese Anpassung führte zu keiner Verbesserung. Laut Caruso, der das Experiment in einem LinkedIn-Post beschreibt, „machte ChatGPT genug Fehler, um von einem Drittklässler-Schachclub ausgelacht zu werden.“

4o ist bekannt für sein großes Selbstvertrauen – mit dem es gelegentlich auch Nutzer in die Irre führt. So auch bei den Schachpartien: Immer wieder versprach das Modell, sich zu steigern und den Atari 2600 beim nächsten Spiel zu besiegen. Doch die Versprechen blieben unerfüllt – und ChatGPT blamierte sich wiederholt gegen ein Schachprogramm aus einer Zeit, in der Computer noch ganze Räume füllten. Hinzu kamen gravierende Fehler: etwa illegale Züge oder das Übersehen eines offensichtlich bedrohten Königs.

Schachleistung als KI-Meilenstein

Das Versagen ist bemerkenswert, weil die Schachleistung als Meilenstein der KI-Geschichte gilt. Schon 1997 besiegte IBMs Supercomputer Deep Blue den damaligen Schachweltmeister Garri Kasparow – mit deutlich geringerer Rechenleistung als heutige Systeme.

Auch andere, die 2024 versuchten, Large Language Models wie 4o zum Schachspielen zu bringen, berichteten von ähnlichen Problemen: Die Modelle erkennen taktische Manöver nur schwer und verlieren leicht den Überblick über das Geschehen auf dem Brett. Selbst legale Züge erkennen sie mitunter schwer.

Getestet wurden neben GPT-4o auch andere Modelle wie LLaMA 3 und 4 (von Meta), Google Gemini 1.5 sowie GPT-4.

➤ Mehr lesen: Mathematiker löst 150 Jahre altes Schach-Problem

Text-Bots sind keine Schach-Bots

Am Wissen mangelt es nicht: Die Sprachmodelle wurden mit umfassenden Sachwissen über Schach trainiert. Sie können Theorien erklären, historische Partien analysieren und die Regeln im Detail erläutern. Aber die Anwendung ist eine andere Sache.

Offenbar werden LLMs beim Training nicht darauf optimiert, Schach zu spielen – sondern Texte zu erstellen und Wahrscheinlichkeiten zu berechnen. Und so verhalten sie sich auch beim Schach: Ihre Züge basieren auf statistischen Wahrscheinlichkeiten, nicht auf einem tatsächlichen Verständnis des Brettgeschehens.

Ganz anders ist das bei spezialisierten KI-Systemen wie Stockfish oder AlphaZero. Diese Programme berechnen Zugfolgen präzise, lernen aus Millionen Partien und verbessern ihre Spielstärke laufend.

Das Versagen der Sprachmodelle ist zwar bedauerlich, aber es zeigt auch etwas wichtiges: Wir sind weit davon entfernt, dass wir KI-Modelle haben, die alles können. Einzelne Modelle haben unterschiedliche Stärken - je nachdem, für welche Aufgaben sie trainiert wurden.

Kommentare