Tool entlarvt, mit welchen Flickr-Fotos KI trainiert wurde

Dieser Artikel ist älter als ein Jahr!

Seit einigen Jahren ist bekannt, dass einige der gängigen Gesichtserkennungssysteme mit Flickr-Fotos trainiert worden sind, um die Algorithmen zu verbessern. Forscher haben nun tausende Datensets analysiert, um herauszufinden, dass Millionen von Flickr-Bildern dazu verwendet worden sind, um Biometriesysteme zu verbessern.

Da die Foto-Plattform Flickr einst extrem beliebt war, befinden sich Millionen alter Fotos online. Viele davon unter Creative-Commons-Lizenz, viele davon zeigen Gesichter, viele zeigen Menschen in privaten Situationen, auf Partys, oder im Urlaub. Doch wessen Gesichter wurden von den Plattformen genommen, und welche nicht? Genau das will das Projekt Exposing AI nun aufzeigen.

Datenbank mit Flickr-Fotos

Exposing.ai wurde von Adam Harvey und Jules LaPlace ins Leben gerufen. Es ging 2021 an den Start und will entlarven, mit welchen Flickr-Fotos sechs gängige Gesichtserkennungstools trainiert worden sind. Unter den Programm befinden sich VGG Face, die 13.955 Flickr-Fotos verwendet haben, Pipa mit 31.518 Flickr-Fotos, MegaFace mit 3.5810.71 Fotos, IJB-C mit 5.757 Flickr-Fotos und FaceScrub mit 211 Flickr-Fotos sowie DiveFace mit 115.729 Flickr-Fotos.

Mit dem Tool können Nutzer feststellen, ob auch ihre Fotos - oder private Fotos ihrer Gesichter, die von Freunden hochgeladen worden waren, in den Datenbanken gelandet sind, mit denen Gesichtserkennungssysteme trainiert worden sind. Die Fotos, die dabei berücksichtigt worden sind, reichen von 2004 bis 2020.

© Flickr

Öffentliche Datensets

Das Projekt wurde mit Fellowships der Karlsruhe HfG Critical AI Group und dem Weizenbaum Institut in Berlin finanziert. Es entstand ein Prototyp. Gemeinsam mit Liz O’Sullivan und dem Surveillance Technology Oversight Project (STOP) wurde dann die Version fertig gestellt, die nun online und für alle abrufbar ist. „Menschen müssen realisieren, dass ihre intimsten Momente zu einer Waffe gemacht wurden“, sagt O’Sullivan zur New York Times.

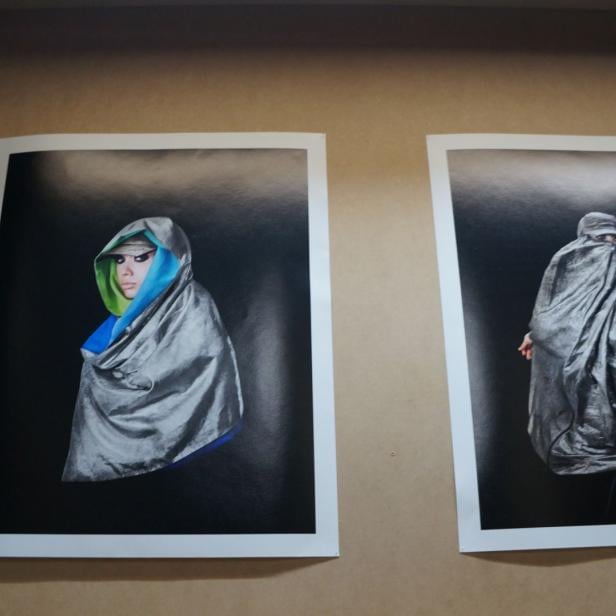

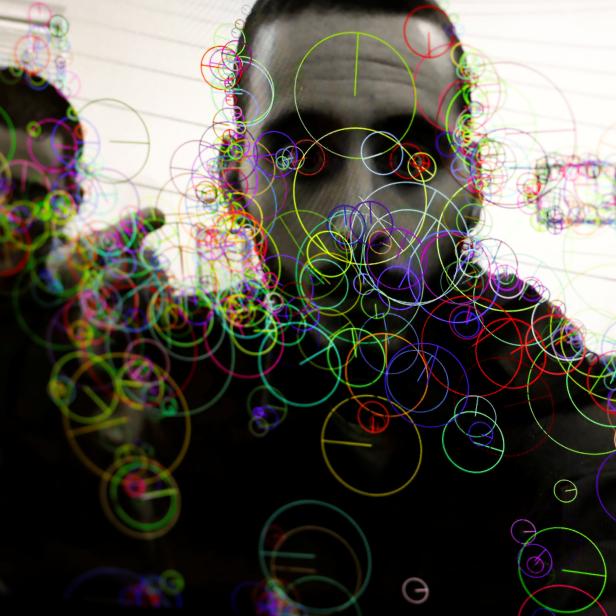

Der Künstler und Privatsphäre-Aktivist Adam Harvey hatte im Jahr 2013 seine Anti-Drohnen-Mode im Wiener Museumsquartier augestellt und bereits damals gezeigt, wie man Gesichtserkennungstools mit Make-Up austricksen kann. Er beschäftigt sich mit dem Thema schon lange und hatte in der Vergangenheit immer wieder vor der Macht von Gesichtserkennung gewarnt.

Exposing.ai funktioniert wie eine Suchmaschine. Gibt man etwa die URL eines seiner Flickr-Fotos ein, durchsucht Exposing.ai die Datenbanken und checkt, ob die Fotos verwendet worden sind. Es können dabei allerdings nur Datensets berücksichtig werden, die öffentlich zugänglich gemacht worden sind. Wenn bei einem Foto kein Ergebnis aufpoppt, heißt das nicht automatisch, dass das Foto nicht trotzdem von anderen Forschungsprojekten dazu verwendet worden ist, um Gesichtserkennungsalgorithmen damit zu trainieren.

IBM unter Kritik geraten

In Verruf gekommen war im Jahr 2019 auch der Technologiekonzern IBM, der ebenfalls auf Flickr-Fotos zurückgegriffen hatte, um seine Gesichtserkennungstools damit zu trainieren. Auch Österreicher waren damals davon betroffen gewesen, doch da IBM die Datenbank nicht öffentlich gestellt hat, fließt sie leider nicht in die Datensets von Exposing.AI mit ein. IBM hat sich mittlerweile vom Einsatz von Gesichtserkennung distanziert und Mitte Juni 2020 angekündigt, keine Gesichterkennungstechnologien mehr entwickeln und einsetzen zu wollen.

Kommentare