Software erstellt Nacktbilder von Frauen in Sekunden

Dieser Artikel ist älter als ein Jahr!

Eine neue Software, die automatisch gefälschte Nacktfotos erstellt, sorgt derzeit für Aufsehen. Die US-Plattform Motherboard hat die Software entdeckt, die sich einen Open-Source-Algorithmus der University of California zunutze macht. Dieser nutzt sogenannte Generative Adversarial Networks (GANs), eine im Machine Learning übliche Vorgehensweise. Dabei treten zwei neuronale Netzwerke gegeneinander an. Ein neuronales Netzwerk erzeugt Inhalte (Generator), die vom anderen neuronalen Netzwerk unter den Trainingsdaten als „Fälschungen“ erkannt werden sollen (Diskriminator). So wird der Algorithmus zunehmend besser und kann selbstständig täuschend echte Inhalte erstellen.

Die Technologie wurde unter anderem genutzt, um Bilder von Menschen zu erstellen, die es nicht gibt, aber auch um Trainingsszenarien für selbstfahrende Autos zu kreieren. In diesem Fall wird das Verfahren aber dazu genutzt, um Nacktbilder von Frauen zu erzeugen. Bilder von Männern produzieren zwar ebenfalls Nacktfotos, allerdings mit weiblichen Körperteilen und oftmals fehlerhaft. Laut dem Entwickler seien Nacktfotos von Frauen einfacher zu finden gewesen, weswegen es derzeit keine Trainingsdaten für Männer-Motive gibt.

"Technologie sollte nicht öffentlich verfügbar sein"

„Das ist verstörend. Jetzt könnte jede Frau Opfer von Rachepornos werden, ohne jemals ein Nacktfoto aufgenommen zu haben. Derartige Technologien sollten nicht öffentlich verfügbar sein“, kritisiert Katelyn Bowden, Gründerin und CEO der Non-Profit-Organisation Badass, die sich für Opfer von Rachepornos einsetzt und zum Thema Aufklärung betreibt. Bereits im Vorjahr sorgte eine Software für Aufsehen, mit der Nutzer die Gesichter von Prominenten in Porno-Videos retuschierten. Derartige Deepfake-Videos kursieren seitdem online, der technische Aufwand für Video ist aber deutlich größer als bei Bildern.

„Es gibt derzeit mehrere Netzwerke, jedes hat eine eigene Aufgabe: finde die Kleidung, markiere sie, errate anatomische Positionen und berechne das Ergebnis“, so der Entwickler gegenüber Motherboard. „All das macht das Berechnen derzeit noch relativ langsam (30 Sekunden auf einem normalen Computer), aber es kann zukünftig noch verbessert und beschleunigt werden.“ Das Berechnen eines Deepfake-Videos kann, je nach Länge und verfügbarer Rechenleistung, mehrere Stunden oder gar Tage dauern.

Mit Wasserzeichen versehen

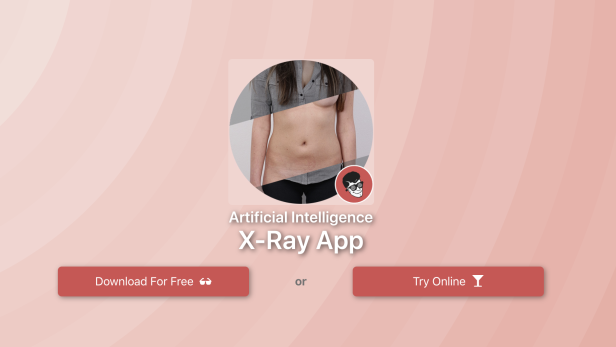

Der Entwickler, der sich gegenüber Motherboard Alberto nannte und laut Twitter aus Estland stammt, verteidigt seine Software - das gleiche Ergebnis könne man schließlich auch mit Photoshop erzielen. Er habe sich vom Konzept von Röntgenbrillen aus den Sechziger- und Siebzigerjahren inspirieren lassen. „Als ich herausgefunden habe, dass man mit GANs aus Tagesfotos Nachtmotive machen kann, ist mir klargeworden, dass man ein Foto von einer bekleideten Person in ein Nacktfoto verwandeln kann“, so Alberto. „Ich bin kein Voyeur, ich bin ein Technologie-Liebhaber.“ Er ist zudem überzeugt: „Wenn ich es nicht gemacht hätte, hätte es jemand anderer in einem Jahr getan.“

Zudem seien die Bilder deutlich als Fakes erkennbar, da sie über ein Wasserzeichen verfügen, auf dem „Fake Nude“ (gefälschtes Nacktbild) steht. Diese sind sowohl in der kostenlosen als auch der „Premium“-Version enthalten, die Alberto für 99 US-Dollar vertreibt. Aufgrund des starken Aufsehens, für das der Motherboard-Artikel gesorgt hat, hat der Entwickler vorübergehend den Download der Software entfernt – angeblich, da die Server wegen des großen Andrangs überlastet waren.

Vorwiegend Frauen im Visier

Laut Motherboard variieren die Ergebnisse der Software stark, man habe diese mit mehreren Dutzend Bildern getestet. Lediglich bei hochauflösenden Fotos, auf denen die Person gut ausgeleuchtet und ohnedies schon leicht bekleidet ist, beispielsweise im Bikini, habe die Software realistische Ergebnisse geliefert.

Immer wieder sorgen derartige Technologien für Aufsehen. Auffällig ist, dass dabei vorwiegend Frauen ins Visier genommen werden. Ein chinesischer Entwickler erhob beispielsweise die Identität von mehr als 100.000 Pornodarstellerinnen mithilfe von Profilfotos öffentlicher Social-Media-Plattformen. Der Mann behauptete, er wolle damit Männern ermöglichen, herauszufinden, ob eine Partnerin schon einmal in einem Porno mitgespielt habe. Eine vergleichbare Funktion für Frauen bot er jedoch nicht an.

Update: Der Druck, der durch die weltweite Berichterstattung ausgelöst wurde, hat jetzt Konsequenzen. Die Entwickler haben die Software offline genommen.

Kommentare