KI-Radier von Apple, Google und Samsung im Vergleichstest

KI-Radierer von Apple, Google und Samsung im Vergleichstest

Dieser Artikel ist älter als ein Jahr!

Die Zeiten großer Hardware-Neuerungen bei Smartphones sind vorbei. Dinge wie Displays oder Kameras sind mittlerweile so weit fortgeschritten, dass sich bei diesen Dingen kein Hersteller mehr Blöße gibt. Darum versuchen Firmen stattdessen immer mehr mit Software-Funktionen voneinander abzuheben. Im Fokus dieser Bemühungen stehen Features, die auf Künstlicher Intelligenz basieren.

Zentral bei all diesen KI-Bemühungen sind Foto-Tools und die Möglichkeit, störende Objekte oder Personen aus einem Bild verschwinden zu lassen. Die Herausforderung: Die AI muss die dadurch frei werdenden Bildinhalte generieren und entsprechend auffüllen.

➤ Mehr lesen: 10 kostenlose KI-Bildgeneratoren im Vergleichstest

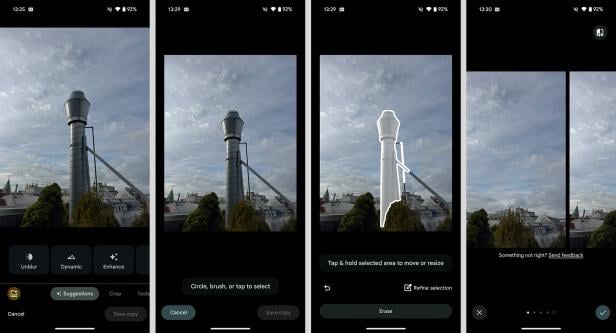

Der "Magic Editor" in der Fotos-App von Google

© Screenshot / Florian Christof

Samsung vs. Google vs. Apple

Ich habe die KI-Radierer von Samsung, Google und Apple bei denselben Fotos ausprobiert und gegeneinander antreten lassen. Sowohl die Ergebnisse als auch die Unterschiede können sich nicht nur sehen lassen, sie sind zum Teil auch überraschend.

Kurz zur Ausgangslage: Google und Samsung bieten mit dem "Magic Eraser" und dem "Objekt Radierer" ein weniger leistungsfähiges Werkzeug an. Diese funktionieren auch offline, wurden aber hier nicht für den Vergleich herangezogen.

➤ Mehr lesen: Samsung Galaxy S24 im Test: So schlägt sich das KI-Handy

Der KI-Editor der Samsung Galaxy AI

© Screenshot / Florian Christof

Googles KI-Tool für alle

Getestet habe ich bei Google den "Magic Editor" und bei Samsung das Foto-Tool der Galaxy AI. Beide Werkzeuge benötigen eine aktive Internetverbindung und bauen auf der Google-KI "Imagen in Vertex AI" auf.

Die AI-Werkzeuge von Google sind übrigens in der App "Google Fotos" verfügbar und können somit unabhängig vom Gerät auf allen Smartphones genutzt werden. Der "Magic Editor" ist auf Android-Handys und iPhones gleichermaßen zu verwenden.

➤ Mehr lesen: Günstiges Google Pixel 8a im Test: Die beste Wahl

"Clean up" - das KI-Tool von Apple

© Screenshot / Florian Christof

Apples KI-Tool ist noch nicht fertig

Bei Apple muss man berücksichtigen, dass der KI-Radierer "Clean up" noch nicht offiziell veröffentlicht wurde. Wie andere "Apple Intelligence"-Features ist er zwar in iOS 18.1 Beta vorhanden, Apple arbeitet aber noch daran. Der große Unterschied zu Google und Samsung: "Clean up" funktioniert am iPhone auch ohne aktive Internetverbindung.

➤ Mehr lesen: KI am iPhone: So könnt ihr Apple Intelligence in Europa nutzen

© Screenshot / Florian Christof

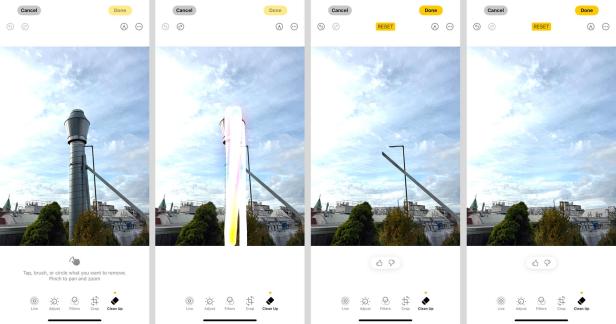

Der kleine Kegel

Beginnen wir mit einem einfachen Bild. Zu löschen gilt es lediglich den kleinen Warnkegel links unten im Foto. Google hat es geschafft, den Kegel als Ganzes auszuradieren und mit einem passenden Pflasterstein aufzufüllen.

Auch wenn bei Samsung und Apple ein kleiner Teil der Pylone übrig geblieben, haben es die KI-Tools geschafft, das störende Objekt entsprechend zu löschen.

© Screenshot / Florian Christof

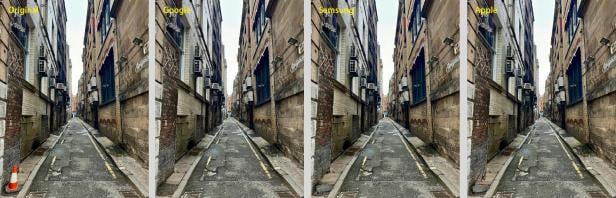

Die hässliche Mülltonne

Ein ähnliches Bild mit einer ähnlichen Aufgabe: Die Mülltonne soll weg. In diesem Fall liefern sowohl Google, als auch Samsung und Apple ein nahezu einwandfreies Ergebnis.

© Screenshot / Florian Christof

Der Typ am Strand wirft einen Schatten

Nun wird es schon etwas schwieriger. Es kommt nämlich ein Schatten ins Spiel. Google hat es als einziger geschafft, auch den Sand entsprechend aufzufüllen und den Schatten unsichtbar zu machen.

Wenn man die Ergebnisse von Apple und Samsung betrachtet, ohne das Original zu kennen, sind die generierten Bilder aber auch völlig in Ordnung.

© Screenshot / Florian Christof

Schwierigkeiten mit den dünnen Seilen

Kommen wir zum Himmel. Hier liefert das iPhone das beste Ergebnis. Es hat als einzige die dünnen Seile des Krans entfernt, während Google und Samsung die kleinen Ausschnitte einfach nicht wegradieren wollten - auch nach mehrmaligen Versuchen nicht.

© Screenshot / Florian Christof

Schwer zu erkennen

Ähnlich es bei dem Bild, wo die Antenne den Blick auf die aufgehende Sonne stört. Google wollte den unteren Teil des Gestänges nicht und nicht erkennen. Samsung hat diese Aufgabe einwandfrei erledigt, während Apple halbwegs gut abschneidet.

© Screenshot / Florian Christof

Alles ähnliche Ergebnisse

Wieder gilt es die Antenne zu entfernen, was in diesem Fall alle mit einem ähnlichen Ergebnis geschafft haben. Den unteren Teil der Antenne hat weder Google, noch Samsung oder Apple entsprechend berücksichtigt.

© Screenshot / Florian Christof

Der gelbe Fleck

Es wird ein bisschen anspruchsvoller. Das gelbe Teil im Hintergrund soll wegradiert werden. Google und Apple haben es auf eine vergleichbare Art und Weise gelöst. Die Linien der Ziegelsteine hat Google etwas besser nachgebildet.

Im direkten Vergleich zu Google und Apple versagt hier Samsung. Der gelbliche Fleck ist nicht die beste Lösung.

© Screenshot / Florian Christof

Größere Fläche muss generiert werden

Das nächste Level: Bei diesem Foto muss noch mehr Bildfläche von der AI generiert werden. Google kann am ehesten überzeugen, weil sowohl die Schatten entfernt, als auch das Muster des Bodens beibehalten wird.

Samsung hat zwar mehr Personen automatisch entfernt, die Schatten aber nicht berücksichtigt. Außerdem wurde an manchen Stellen die Fläche mit einem verschwommenen Etwas aufgefüllt.

Ein ähnlich durchwachsenes Ergebnis liefert Apple. Auch auf dem iPhone wurden mehrere Personen gleichzeitig wegradiert, das Muster der Pflastersteine verwirrt allerdings.

© Screenshot / Florian Christof

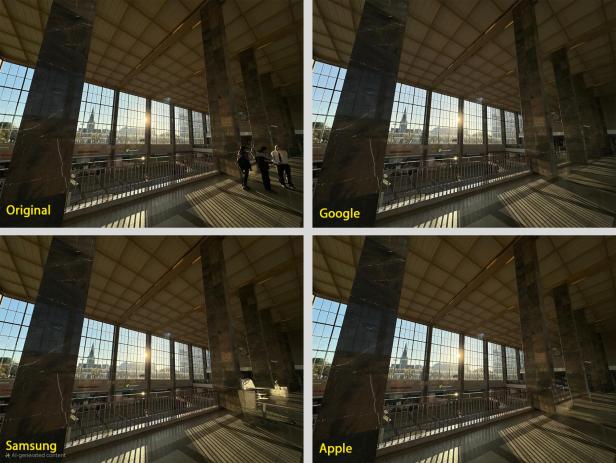

Licht und Schatten

Die etwas schwer zu erkennenden Personen im rechten unteren Bildbereich auszuschneiden, ist keine leichte Aufgabe. Die frei werdende Fläche bei den Licht- und Schattenspielen entsprechend aufzufüllen, ist noch schwerer.

Google hat diese Herausforderung fast einwandfrei gemeistert. Vor allem das Geländer wurde nahezu perfekt nachgebildet. Apple hat hier auch gute Arbeit geleistet. Was Samsung anstelle der Personen generiert hat, ist reines Chaos.

© Screenshot / Florian Christof

Großer Teil soll nachgebildet werden

Beim winterlichen Schönbrunn soll die Anzahl der Personen zumindest reduziert werden. Das ist insofern herausfordernd, als auch hier eine relativ große Fläche generiert werden muss.

Auch wenn Google die 2 Personen in der Bildmitte einfach nicht entfernen wollte, sind die restlichen Bildbereiche überraschend gut nachgebaut worden.

Samsung hat ein glattes Schneefeld erfunden, das eigentlich gut passt, aber durch die Belichtung negativ auffällt. Außerdem wurden 3 kleine Obelisken erfunden.

Apple tut sich sichtlich schwer, im rechten Bildbereich die Fläche entsprechend zu generieren. Zumindest wurde der Vordergrund zufriedenstellend bearbeitet.

© Screenshot / Florian Christof

Next Level

Jetzt wird es wirklich schwierig. Die Autos auf der rechten Straßenseite sollen weg. Google liefert wieder einmal ein überraschend gutes Ergebnis. Sowohl die Hausmauer als auch die Pfeiler wurden nahezu makellos generiert, sodass die Flucht des Bildes erhalten bleibt.

Samsung hat auch nach mehreren Versuchen leider nicht kapiert, dass die Autos entfernt werden sollen. Immer wieder hat die Galaxy AI einfach ein neues Auto erfunden.

Beim iPhone verliert das Bild leider seine Dynamik, weil der Fluchtpunkt komplett entstellt wurde. Die Hausmauer wurde noch halbwegs passable generiert, was aber danach folgt, ist nicht mehr brauchbar.

Fazit

Die eindeutig besten Ergebnisse liefert Google. Der Magic Editor tut sich manchmal schwer, die markierten Objekte zu erkennen. Dafür ist er in der Lage, die Bildinhalte jedes Mal nahezu einwandfrei zu generieren. Er schafft es sogar, die Eigenheiten der Bildkomposition bei herausfordernden Motiven beizubehalten.

Das Gute am "Magic Editor" von Google: Man benötigt nur die Google Fotos-App und kann das leistungsstarke Tool nutzen. Ohne Internetverbindung wird es aber nichts. Denn das KI-Werkzeug ist auf die Rechenleistung in der Cloud angewiesen.

Dieselbe Cloud verwendet Samsung, liefert aber deutlich schlechtere Bilder als Google. Bei kleineren Aufgaben kann auch die Galaxy AI überzeugen. Wenn aber Großflächigeres generiert werden soll, tut sich Samsung schwer und bringt keine zufriedenstellenden Bilder mehr zustande.

Apple muss man hier noch mit Samthandschuhen anfassen, weil das "Clean up"-Tool nicht offiziell veröffentlicht wurde und noch verfeinert wird. Es ist aber bereits in der Lage, überzeugende Arbeit zu leisten. Je größer die Fläche wird, die es zu generieren gilt, desto schwerer tut sich die Apple-KI.

Wenn man bedenkt, dass "Clean up" auch offline funktioniert und lediglich die Rechenleistung des iPhone nutzt, sind die Ergebnisse umso beeindruckender. Ein Feinschliff ist aber unbedingt notwendig.

Kommentare