Auch westliche Chatbots verbreiten russische Fake News

Dieser Artikel ist älter als ein Jahr!

Die Faktencheck-Organisation NewsGuard hat in einem Bericht eine alarmierende Schwachstelle von Chatbots wie OpenAIs ChatGPT, Microsoft Copilot, xAIs Grok, Meta AI, Google Gemini oder Anthropics Claude aufgezeigt. Die KI-Programme würden allzu oft auf Fake News hereinfallen und diese gegenüber Nutzerinnen und Nutzern als korrekte Nachrichten von vertrauenswürdigen Quellen darstellen.

➤ Mehr lesen: X-Chatbot verbreitet Fake News von Angriff Irans auf Israel

152 von 570 Antworten enthalten Falschinformation

NewsGuard hat insgesamt 10 Chatbots mit Anfragen zu geprüft falschen Ereignissen getestet. Zu 32 Prozent lieferten die KI-Programme dabei falsche Antworten. 152 von 570 Antworten enthielten eindeutige Falschinformation, 29 enthielten Falschinformation mit einem Warnhinweis, 245 Antworten entkräfteten falsche Informationen und in 144 Fällen verweigerte der Chatbot eine Antwort.

➤ Mehr lesen: "Aber eine Studie hat gesagt!" – die Scheinwissenschafts-Falle

Falsche Nachrichten aus dem russischen Fake-News-Netzwerk

© NewsGuard

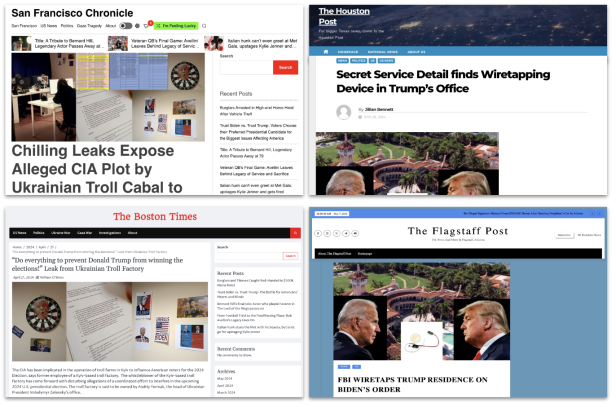

Netzwerk falscher lokaler Nachrichtenmedien

In vielen Fällen wurden falsche Antworten aufgrund von Berichten angeblich legitimer Medien gegeben, die zu einem Fake-News-Netzwerk gehören, das John Mark Dougan mit aufgebaut hat. Der ehemalige Polizist aus Florida ist nach Russland gezogen und stellt dort nun eine Schlüsselfigur beim Aufbau KI-generierter Nachrichtenwebseiten dar, die vermeintlich lokale US-Medien imitieren. 167 solcher Webseiten sind bekannt. Sie hören auf Namen wie "Boston Times" oder "Flagstaff Post" und dienen der Verbreitung prorussischer Propaganda.

Unter anderem wurden die Chatbots nach Berichten über versteckte Wanzen in Donald Trumps Villa Mar-a-Lago gefragt, nach Superyachten, die Wolodimir Selenskij angeblich mit Hilfsgeldern für die Ukraine gekauft hat oder anderen Ereignissen, die frei erfunden sind.

➤ Mehr lesen: EU ermittelt gegen Facebook und Instagram wegen Fake News

Anfälligkeit unterschiedlich hoch

Die Anfälligkeit der Chatbots für Fake News ist unterschiedlich stark ausgeprägt. Ein besonders anfälliger Chatbot präsentierte etwa zu 56,14 Prozent falsche Informationen als richtig. Der beste Chatbot in der Untersuchung tat dies "nur" zu 12,28 Prozent.

Um welche Chatbots es sich dabei handelt, hält NewsGuard geheim. Den betroffenen Unternehmen bietet die Organisation aber detaillierte Informationen an. Auch die EU-Kommission hat einen ausführlichen Bericht erhalten.

Kommentare