Die Keynote der I/O 2024: Unser Ticker zum Nachlesen

Dieser Artikel ist älter als ein Jahr!

Googles Entwicklerkonferenz I/O steht wieder vor der Tür. Diesmal ist es offiziell nur ein Tag, an dem sich die Entwickler*innen virtuell zu verschiedensten Vorträgen rund um Googles Ökosysteme treffen. Eröffnet wird die Google I/O traditionell mit der Keynote.

Hier findet ihr den Livestream, darunter unseren Liveticker.

Google I/O 2024 Keynote

-

Willkommen

Willkommen bei unserem Liveticker zur Keynote der heurigen Google I/O, um 19:00 geht's los!

-

Künstliche Intelligenz

Es dürfte wohl niemanden überraschen, dass Googles I/O heuer ganz im Zeichen der KI stehen wird. Ein interessantes Feature, bei dem Gemini Videoinhalte live analysieren, bewerten und Fragen dazu beantworten kann, hat der Konzern bereits gestern geteilt. Das dürfte ein kleiner Ausblick darauf sein, wie KI künftig Android verbessern soll.

➤ Mehr lesen: Google teasert neue KI-Suche für Handy-Kameras an

-

Die große Frage wird für uns hier in Österreich sein: Wie viele der neuen Features schaffen es auch in die EU? Aufgrund der strengen Datenschutzgesetze könnte es zumindest länger dauern, bis es bestimmte Funktionen nach Europa schaffen.

-

Suche nach dem Killer-Feature

Der Hype um KI hält sich nun schon eine ganze Weile, so richtig eingeschlagen ist das aber noch nicht. Das liegt vor allem daran, dass viele im Alltag gar nicht wissen, was sie damit anfangen sollen. Das eine Feature, das alles verändern wird, hat noch niemand vorgestellt. Ob Google das heute ändern wird, darf bezweifelt werden - aber wir lassen uns auch gern überraschend.

-

OpenAI prescht wieder vor

Gestern, und damit einen Tag vor der I/O (ein Schelm, wer Böses denkt), hat Konkurrent OpenAI sein verbessertes Sprachmodell GPT-4o vorgestellt. Auch Nutzer*innen der Gratisversion können jetzt auf den Bildgenerator und Echtzeit-Internetdaten zugreifen. Zudem erkennt die KI Stimmungen, wenn man die Spracherkennung nutzt und sie kann Bilder und Videoinhalte analysieren. Google wird etwas ähnliches präsentieren. Der Kampf um die Vorherrschaft ist also weiter in vollem Gange.

-

KI-Suche

Bei Google und Microsoft ist immer wieder die Suchmaschine ein Thema. KI soll alles besser machen, bisher ist davon aber noch nichts zu sehen. Auch hier grätscht OpenAI rein. Erst hieß es, bald würde eine eigene Suche angekündigt, dann kam die Entwarnung: Der Google-Killer kommt doch noch nicht. Gearbeitet wird daran vermutlich trotzdem.

Würde es Google heute gelingen, ein überzeugendes Produkt vorzustellen, könnte der Konkurrenz der Wind aus den Segeln genommen werden. Denn Google gilt es zu schlagen, und das funktioniert nicht mit Funktionen, die die weltweit beliebteste Suchmaschine schon hat.

-

Wie macht die KI, was ich will?

Während ihr wartet: Der Umgang mit Gemini, ChatGPT und Microsoft Copilot muss gelernt sein. Um die KI-Chatbots wirklich nutzen zu können, muss man a) wissen was sie schon können und b) auch richtig danach fragen. Wir haben hier ein paar Tipps für euch zusammengestellt, wie man gute Prompts formuliert:

-

Wenig durchgesickert

Interessant an der heurigen Google-Keynote ist, dass erstaunlich wenig vorab durchgesickert ist. Auch im Hinblick auf Hardware-Ankündigungen ist noch völlig unklar, ob oder was kommt. Das günstige Pixel 8a hat Google ja schon vergangene Woche vorweggenommen.

-

Smart Home

Dürfte ich mir etwas wünschen, wären das Smart-Home-Geräte mit Gemini. Etwa neue Nest-Speaker oder vielleicht sogar ein neues smartes DIsplay. Allzu viele Hoffnungen mache ich mir hier aber nicht...

-

Im Livestream wird übrigens schon hippe Elektromusik von einem wilden Mann im bunten Bademantel aufgelegt

© Screenshot Google

-

Los geht's

...und wir starten wenig überraschend mit Gemini und einem Video, das verschiedene Anwendungen von Künstlicher Intelligenz präsentiert.

© Screenshot Google

-

Sundar Pichai ist da

Und er startet mit einem Taylor-Swift-Joke. Die I/O sei so etwas wie die "Eras Tour", "aber mit weniger Kostümwechseln", so der Google-Chef.

© Screenshot / Google

-

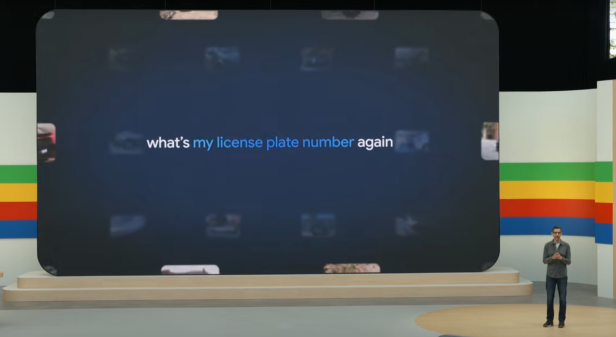

Fotos durchsuchen

Gemini soll dabei helfen, die eigenen Fotos besser zu durchsuchen. Das klingt sehr interessant: Statt nach Schlüsselwörtern kann man mit "Ask Photos" Fragen stellen wie: "Wie lautet mein Nummernschild?" oder "Wann hat meine Tochter laufen gelernt?" und Gemini analysiert alle Bilder, um die Frage zu beantworten und die zugehörigen Fotos herauszusuchen. Das funktioniert natürlich nur dann, wenn man sein ganzes Leben in Bildern festhält.

Die Funktion soll im Sommer kommen - ob für alle Märkte oder wieder nur für US-Nutzer*innen wird sich zeigen.

© Screenshot Google

-

Gemini 1.5 Pro

In einem Video wurde gezeigt, wie Programmierer*innen erfolgreich mit Gemini Pro arbeiten. Besonders ausgebaut wurde das Context Windows, also das Ausmaß an Daten, mit dem man das Sprachmodell füttern kann. Die Zahl wird nun auf 2 Millionen Tokens erweitert. Gemini 1.5 Pro soll für alle Entwickler*innen weltweit verfügbar gemacht werden.

-

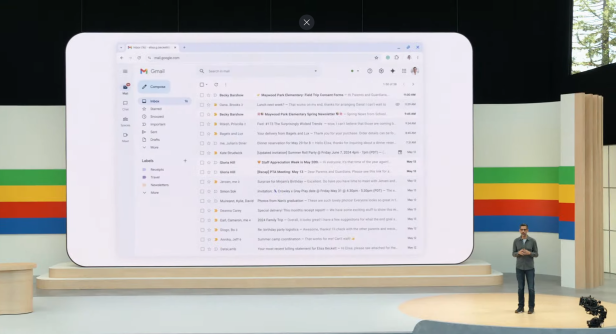

Workspace: Gmail durchsuchen

Wer Google Workspace nutzt, kann Gemini 1.5 Pro bereits dafür verwenden, um E-Mails zu durchsuchen und Inhalte von Meetings analysieren. Dafür stellt man Fragen und die E-Mails werden durchsucht, um die Antwort zu finden.

© Screenshot / Google

-

Audio Overviews in NotebookLM

Jetzt geht es um die KI-App NotebookLM. Jene kann mit Gemini 1.5 Pro mit verschiedenstem Material gefüttert werden und das Tool generiert ein personalisiertes Audio-File, in dem einem eine Zusammenfassung davon erzählt wird.

-

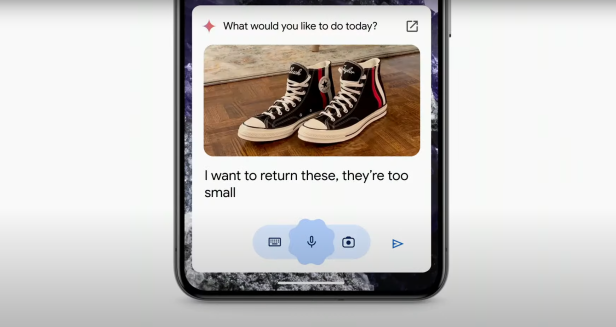

Gemini schickt Schuhe zurück

Googles KI kann online gekaufte Schuhe (und bestimmt auch andere Produkte) zurück schicken. Es sucht die Bestellnummer heraus, füllt Formulare aus und vereinbart auch einen Abholtermin, wenn nötig. Essen soll sie übrigens auch bestellen können.

© Screenshot Google

-

Demis Hassabis

Jetzt ist DeepMind-Mitgründer und CEO Demis Hassabis auf der Bühne, erstmals ist er auf einer I/O.

© Screenshot

-

Gemini 1.5 Flash

Neben Gemini 1.5 stellt Hassabis ein abgespecktes, schnelleres und effizenteres System vor: Gemini 1.5 Flash. Das soll mit einer Million Tokens laufen und kostengünstiger sein.

© Screenshot Google

-

Project Astra

Hassabis kündigte Googles Project Astra an. Es soll ein universeller KI-Assistent für den Alltag sein. Dieses Projekt sei der Grund, warum Gemini multimodal ist.

In einem Video ist zu sehen, wie eine Anwenderin mit ihrer Handykamera durch ein Büro geht und etwa fragt, "zeige mir alles, was Töne macht". Das Modell erkennt eine Box auf dem Tisch. Dann schaut sie mit ihrer Handykamera aus dem Fenster und fragt, in welcher Stadtgegend sie sich gerade befindet. Auch das kann die KI korrekt beantworten.

© Screenshot Google

-

Es sieht so aus, als würde Google diese Funktion auch für eine neue Version seiner smarten Brille Google Glass (oder zumindest einer anderen AR-Brille) bringen. Zumindest war das im Demo-Video zu sehen

© Screenshot Google

-

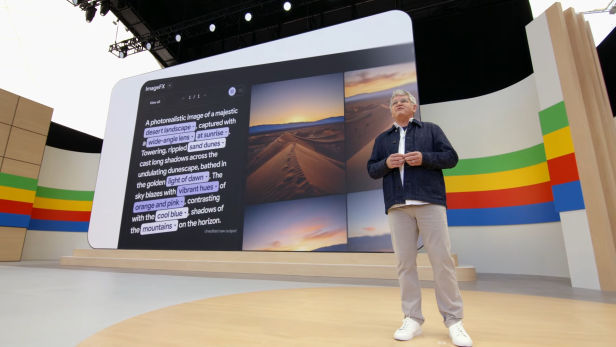

Imagen 3

Doug Eck ist auf der Bühne. Er spricht über einen generative Bildgeneratoren und kündigt Imagen 3 an. Es soll das bislang beste Modell für das Generieren von Text sein. Damit tun sich vergleichbare Produkte notorisch schwer.

© Screenshot Google

-

Generative Musik

Anschließend wurde es musikalisch. Marc Rebillet and Wyclef Jean zeigen in einem Clip, wie sie generative KI für ihre Werke nutzen.

-

Video-Modell Veo

Nach Bildern und Musik darf natürlich auch Video nicht fehlen. Mit dem generativen KI-Programm Veo können Videoclips basierend auf Texteingaben erschaffen werden. Wie gut das Funktioniert demonstriert Schauspieler, Musiker und Filmemacher Donald Glover (auch als Childish Gambino bekannt) mit den Worten: "Jeder kann ein Regisseur werden". Über labs.google können ausgewählte Personen das System jetzt nutzen. Wann es für ein breiteres Publikum kommt, ist aber noch unklar.

Das erinnert alles stark an Sora, das OpenAI bereits im Februar präsentierte.

➤ Mehr lesen: Filmreife KI-Videos: Ein Hollywood-Drama bahnt sich an

-

Trillium

Sundar Pichai ist zurück auf der Bühne. Er eröffnet das nächste Thema, KI-Chips. Er kündigt die neue Generation an Cloud Tensor Processing Units (TPUs), Trillium, an. Die neuen TPUs sollen 4,7x schneller sein.

© Screenshot

-

Circle to Search

Die praktische Suchfunktion, bei der man Objekte auf dem Smartphone-Screen einkreisen kann, um mehr darüber zu erfahren, kommt für alle Android-Handys. Bisher konnten nur Smartphones von Samsung und die hauseigenen Pixel-Geräte Circle to Search nutzen.

© Screenshot Google

-

Es geht um die Suche

Künstliche Intelligenz soll natürlich auch die Google-Suche weiterhin verbessern. Die neue Such-Chefin Liz Reid ist dazu auf der Bühne. Sie kündigt an, dass AI Overviews bis Ende des Jahres für eine Milliarde Nutzer*innen der Suche zur Verfügung stehen soll.

Als Beispiel nennt sie etwa das Szenario, in dem man nach einem Yoga-Studio sucht. AI Overview in der Google-Suche liefert dann nicht nur eine Liste der Studios, sondern auch direkt die Zeit, wie lange man zu jedem Studio zu Fuß geht. Zusätzlich aktuelle Angebote und Kartenausschnitte gibt es auf einen Blick. Unterm Strich soll man all diese Dinge nicht mehr selbst recherchieren und mühsam zusammensuchen müssen, sondern die KI soll das erledigen.

-

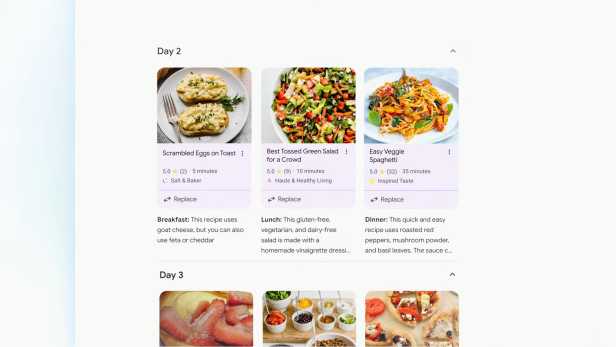

Das funktioniert auch, wenn man z.B. Mahlzeiten für die nächste Woche planen will

© Screenshot Google

-

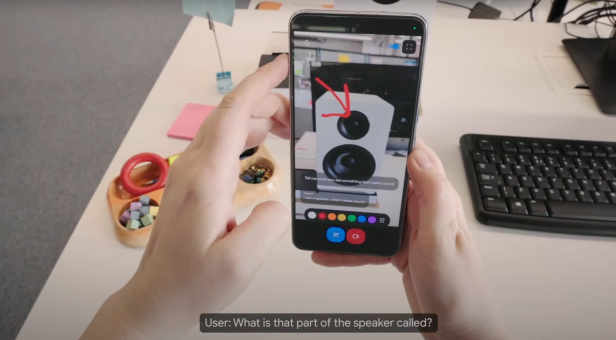

Videosuche

In einer Livedemonstration stellt Google jetzt seine neue Videosuche vor. Dabei hält man die Smartphone-Kamera auf den Ort des Geschehens - in diesem Beispiel ein Plattenspieler. Dann fragt man, warum er nicht richtig funktioniert. Die Suche beantwortet dann nicht nur, was das Problem ist und wie man es löst, sondern gibt auch Hintergrundinformationen über Modellbezeichnungen. Das könnte im Haushalt tatsächlich praktisch sein, etwa um etwas zu reparieren oder die richtigen Ersatzteile zu finden.

-

Gmail mit KI organisieren

Ein weitere KI-Feature für Workspace ist das Organisieren des eigenen Gmail-Posteingangs. Wenn man etwa ein freischaffender Fotograf ist, kann man die KI bitten, alle Rechnungen, die man zugesandt bekommen hat, zu organisieren. Der entsprechende Prompt wird in der Sidebar angezeigt.

-

Gemini im Workspace

Nutzer*innen von Google Workspace können Gemini bald für verschiedenste Apps nutzen. Das wurde bereits gesagt, aber jetzt zeigt Google nochmal genauer, wie man mit der KI die Produktivität steigern kann. Sie fasst Mails zusammen, automatisch To-Do-Listen erstellen. Dafür gibt es einen neue Seitenleiste, in der Gemini auch schon verschiedene Funktionen anbietet, wie es Nutzer*innen unterstützen kann. Leider kommt das eben nur für Business-Anwender*innen.

Wenn ich mir etwas wünsche würde, dann dass Gemini meine ungelesen Werbe-Mails löscht und mich von Newslettern abmeldet, die mein Postfach zumüllen - aber mich fragt ja niemand.

-

Virtual Teammate

Unternehmen, die mit Google Workspace arbeiten, können künftige ganze Mitarbeiter*innen mit KI erstellen. Die "virtual Teammates" haben einen Namen und ihnen können auch bestimmte "Rollen" im Unternehmen zugewiesen werden. Man kann dann etwa direkt über Chat mit ihnen kommunizieren.

-

Gemini App

Gemini bekommt eine eigene App. Mit Texteingabe, Sprache und Video über die Kamera kann man mit der KI interagieren. Project Astra, also die Live-Video-Funktion, soll damit nutzbar sein.

-

Mit "Gems" kann man verschiedene eigene Gemini-Funktionen anlegen. Wenn man eine Funktion will, die einem beim Arbeiten, bei der Freizeitplanung, bei Konversationen oder bei der Organisation hilft, kann man diese einzeln anlegen und schneller auf sie zugreifen. Vergleichbar ist das mit ChatGPTs "Custom"-Version.

Die Funktion "Trip Planning" hilft beim Planen von Urlauben. Dabei greift sie auf bestimmte Informationen zurück (wenn man diese z.B. in Gmail gespeichert hat und Gemini darauf zugreifen kann), die es über den Trip schon hat. Das hilft z.B., keinen überlappenden Termine zu buchen. Die Funktion "Gemini Trip Planning" kommt im Sommer für Nutzer*innen von Gemini Advance.

-

Später im Jahr wird, wie bereits gesagt, Gemini Advanced auf 2 Millionen Tokens erweitert. Ab sofort ist Gemini 1.5 Pro bereits mit 1 Millionen Tokens verfügbar. Das ermöglicht es etwa, 1.500 Seiten lange Dokumente hochzuladen.

-

Es geht um Android

Sameer Samat spricht nun über Android und Künstlicher Intelligenz. Er erklärt, wie Anwendungen wie Circle to Search KI direkt auf Smartphones bringt. Dabei kann man Dinge, nach denne man suchen will, einfach mit dem Finger am Touchscreen einkreisen. Künftig kann Circle to Search auch Physik-Hausaufgaben lösen.

-

Google Messages und YouTube

Einige Gemini-Funktionen sollen zu Google Messages kommen. So kann man generierte Bilder direkt in einen Chat und in Gmail ziehen und verschicken. Bekommt man einen YouTube-Link geschickt, kann man Gemini fragen zum Video stellen oder um zusätzliche Informationen zum Videoinhalt fragen. Dazu öffnet sich ein kleines Chat-Fenster über dem Inhalt, über das man mit Gemini kommuniziert, während das Video oder der Chat im Hintergrund geöffnet bleiben.

-

Bekommt man ein Foto geschickt, kann man sich mit der Gemini-Nano-Funktion "Talkback" automatisch Bildbeschreibungen generieren und vorlesen lassen - das ist ein schönes Feature für Barrierefreiheit

-

KI gegen Scams

Dave Burke zeigt auf der Bühne, wie Künstliche Intelligenz auch als Schutz vor Online-Betrug dienen kann. Das On-Device-KI-Modell Gemini Nano soll etwa vollautomatisch erkennen können, wenn ein Anruf ein Betrugsversuch ist. Anschließend kommt sofort eine Warnung an die Benutzer*innen.

-

2. Android 15 Beta

Schon morgen kommt die neue Beta-Version von Android 15. Ob darin schon zu sehen ist, dass Gemini besser verstehen soll, was auf dem Smartphone Display vor sich geht und darauf reagieren kann, wenn es gefragt wird, wird aber nicht ganz klar. Vielleicht wurden die beiden Sachen auch einfach nur nacheinander aufgezählt.

-

Gemini 1.5 Pro kostet 7 Dollar, bzw. 3,50 Dollar für die 128k-Variante. Das schlankere Gemini 1.5 Flash kostet nur 0,35 Dollar. Beides ist für Entwickler*innen in über 200 Ländern ab sofort verfügbar.

-

Gemma

Jetzt geht es um den offenen Gemini-Ableger Gemma. Das neue PaliGemma ist optimiert für visuelle Inhalte. Außerdem wurde Gemma 2 mit 27 Milliarden Parametern angekündigt. Optimiert ist es von Nvidia, um auf kommenden GPUs zu laufen.

-

Gefahren von KI

Google erklärt, wie Risiken von KI angegangen werden. Es werde ständig daran gearbeitet, problematische Antworten zu verhindern. Je realistischer Texte, Bilder und Videos werden, desto größer wird die Gefahr für die Verbreitung von Falschinformationen. Mit SynthID wird ein Wasserzeichen für Inhalte veröffentlicht, das auch Entwickler*innen nutzen können, um deutlich zu machen, welche Inhalte KI-generiert sind.

-

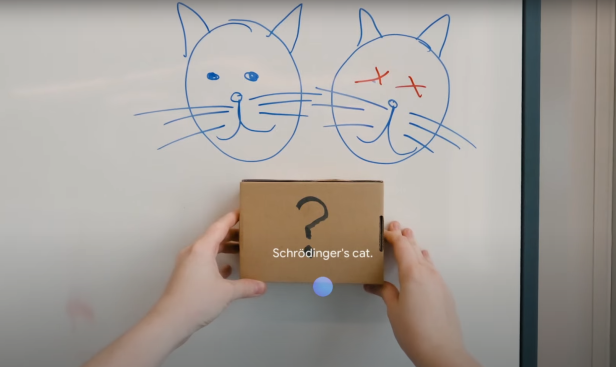

LearnLM

Google präsentiert mit LearnLM eine eigene Anwendung, natürlich basierend auf Gemini, das auf Bildung spezialisiert ist. Beispielsweise kann ein "Learning Coach"-Gem dabei helfen, komplexe Themen zu verstehen oder sich etwas zu merken, etwa chemische Formeln. Der Coach kann auch ein Quiz basierend auf einer Video-Unterrichtseinheit generieren, das Wissen abfragt.

Lehrer*innen können das auch nutzen, um Unterrichtsstunden zu planen.

-

Sundar verabschiedet sich

Noch einmal tritt der Google-Chef auf und sagt: Falls ihr gezählt habt, wie oft heute "AI" gesagt wurde - Gemini hat das schon für euch erledigt, es sind (bisher) 120 Mal. Aber da kommen wohl noch ein paar hinzu...

-

Sundar Pichai bedankt sich bei den Entwickler*innen und Zuschauer*innen und beendet die Keynote mit einem Video, dass das Präsentierte noch einmal zusammenfasst.

-

Das wars!

Und damit sind knapp 2 Stunden rum. Google hat Einiges präsentiert, aber der Keynote fehlte es doch an Substanz und Struktur. Immer wieder haben wir uns in der Redaktion gefragt: Wurde das nicht schon gesagt? Und tatsächlich hat sich vieles wiederholt, wie Circle to Search, die Live-Video-Suche und Workspace-Funktionen. So kann man eine Präsentation natürlich auch strecken.

Das eine zündende Feature, das uns hätte "Wow" sagen lassen, bleibt uns Google schuldig. Das liegt einerseits daran, dass OpenAI bereits Ähnliches gezeigt hat. Aber auch daran, dass Zweifel bleiben, wie gut uns die KI wirklich im Alltag helfen kann.

Welche Funktionen in Europa verfügbar sein werden und wann sie kommen, finden wir für euch noch heraus. Dass Googles Gemini aus uns einen komplett gläsernen Menschen machen muss, um zu funktionieren, darf man mit Skepsis betrachten.

Damit verabschieden wir uns vom Liveticker und wünschen euch einen schönen Abend. Eine Zusammenfassung der wichtigsten Neuerungen lest ihr in Kürze bei uns.

Kommentare